- Ejecución en navegador con React y TensorFlow.js usando COCO-SSD para detección en vivo sin backend.

- YOLOv3/YOLOv8 para webcam y vídeo, con seguimiento multiobjeto mediante ByteTrack o BoTSort.

- Datos y métricas clave: PASCAL VOC, MS COCO, mAP e IoU, y flujo de entrenamiento por transferencia.

- Despliegue como sitio estático o en edge (ESP32Cam/Jetson) y opciones no-code para acelerar producción.

La detección de objetos en tiempo real desde la webcam ha pasado de ser un experimento de laboratorio a una capacidad cotidiana gracias a la madurez de la visión por ordenador y del aprendizaje profundo. Hoy es posible montar un prototipo funcional que analiza el vídeo en directo sin depender de un servidor, e incluso desplegarlo como sitio estático. Desde navegadores con TensorFlow.js hasta dispositivos en el borde como ESP32Cam o plataformas Jetson, el abanico de opciones es enorme.

Trabajar con la webcam aporta inmediatez y reduce fricción: puedes probar en tu equipo, capturar datos y hacer demostraciones sin hardware extra, por ejemplo usar tu móvil como webcam. Con TensorFlow.js es posible ejecutar un detector en el navegador, y con motores como YOLO en Python puedes exprimir la GPU para procesar vídeo a alta velocidad. Esta versatilidad suma para prototipos, POCs y despliegues ligeros.

Qué entendemos por detección de objetos y por qué hacerlo desde la webcam

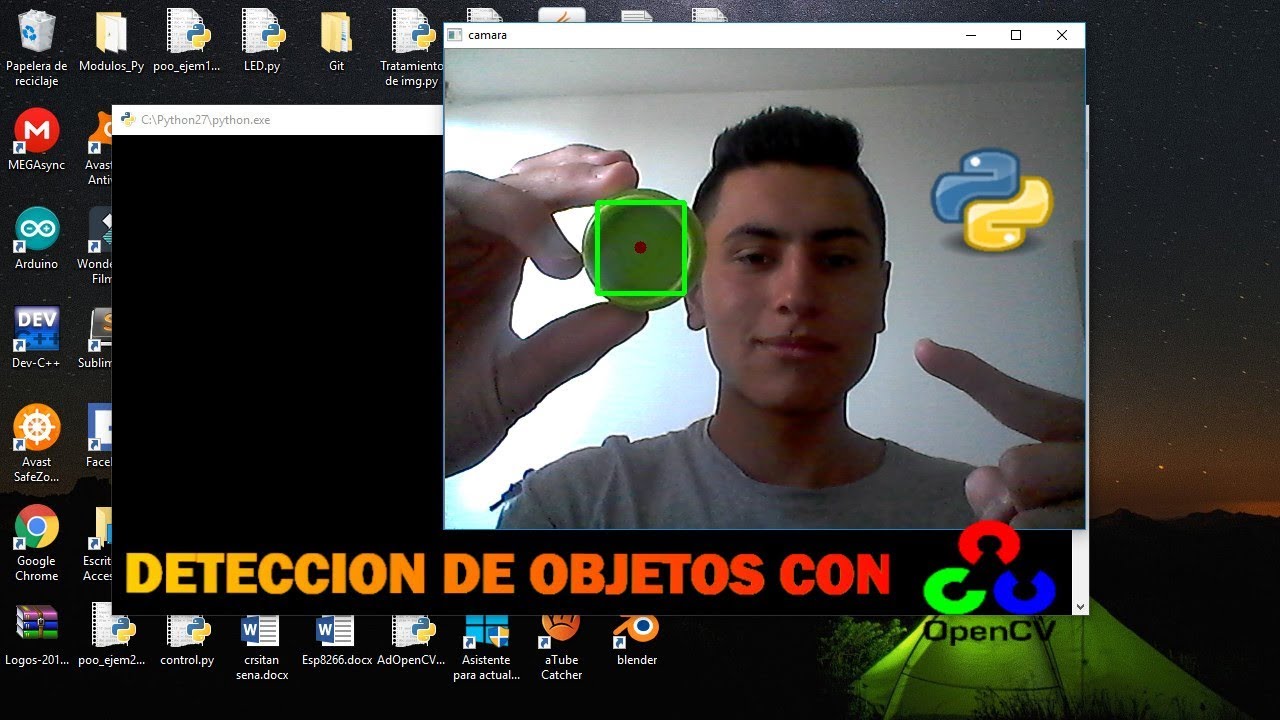

La detección de objetos identifica y ubica elementos dentro de cada fotograma de una imagen o vídeo, añadiendo cuadros delimitadores y etiquetas de clase con un nivel de confianza. A diferencia de la clasificación, que etiqueta la imagen completa, aquí necesitamos localizar la posición. Modelos como YOLO, SSD o Faster/Mask R-CNN han impulsado esta tarea hasta el tiempo real en contextos tan diversos como seguridad, retail o conducción autónoma.

Trabajar con la webcam aporta inmediatez y reduce fricción: puedes probar en tu equipo, capturar datos y hacer demostraciones sin hardware extra. Con TensorFlow.js es posible ejecutar un detector en el navegador, y con motores como YOLO en Python puedes exprimir la GPU para procesar vídeo a alta velocidad. Esta versatilidad suma para prototipos, POCs y despliegues ligeros.

Detección en el navegador con React y TensorFlow.js (COCO-SSD)

Una forma directa de empezar es crear una SPA con React que tome el flujo de la webcam, ejecute un modelo preentrenado en el propio navegador y pinte resultados. El modelo COCO-SSD reconoce decenas de clases habituales y es relativamente ligero, por lo que resulta perfecto para una demo ágil con detección en vivo.

Configuración inicial del proyecto con Vite y dependencias. Crea el esqueleto de React y añade TensorFlow.js junto al paquete del modelo COCO-SSD:

npm create vite@latest kinsta-object-detection --template react

cd kinsta-object-detection

npm i @tensorflow-models/coco-ssd @tensorflow/tfjsEn la aplicación define un componente que administre el permiso de cámara, arranque y detenga el stream, y pinte el vídeo, y si necesitas guardar capturas existen programas para tomar fotos desde la PC. Conviene gestionar el estado con React y almacenar una referencia al elemento <video> para asignarle el flujo de MediaDevices.getUserMedia.

Interfaz y flujo básico. En el componente principal puedes componer una cabecera y un componente ObjectDetection. Ese componente incluirá: un botón de inicio/parada de la webcam; el elemento del vídeo; y un contenedor donde luego dibujarás cuadros y etiquetas. El arranque pedirá permiso y asignará el stream a ‘videoRef.current.srcObject’; al detenerse, se recorre cada pista de la transmisión para detener tracks y liberar recursos.

Lógica de detección. Importa el modelo y TensorFlow.js, y prepara un estado para guardar las predicciones. Carga COCO-SSD con ‘cocoSsd.load()’ y llama a ‘model.detect(videoRef.current)’. El resultado es un array con clase, score y coordenadas del cuadro (bbox). Estos datos se usan para superponer un rectángulo y una etiqueta por cada objeto identificado en la imagen en vivo.

Frecuencia de inferencia. Para invocar la detección de forma periódica, puedes utilizar ‘setInterval’ al activarse la webcam y ‘clearInterval’ al detenerse. Un intervalo típico son 500 ms, aunque puedes variarlo. Más frecuencia implica mejor fluidez pero mayor consumo en el navegador; con equipos modestos, bajar el ritmo evita picos de memoria y CPU.

Estilos. Añade reglas CSS para posicionar etiquetas y marcadores en capas absolutas por encima del vídeo. Una etiqueta con fondo semitransparente y un cuadro con borde discontinuo facilitan la lectura de la detección en tiempo real. Recuerda mantener ligero el estilo para no penalizar el rendimiento del render.

Despliegue estático. Una vez lista la app, puedes compilar y publicar el sitio como estático. Kinsta permite hospedar hasta 100 sitios estáticos sin coste desde GitHub, GitLab o Bitbucket. En el panel, autoriza el proveedor Git, selecciona el repo y rama, asigna un nombre, y configura la build (‘npm run build’ o ‘yarn build’, Node ‘20.2.0’, directorio de publicación ‘dist’). Tras crear el sitio, ‘Visitar Sitio’ te llevará a la URL. Con el enfoque estático, tu detector con COCO-SSD y TensorFlow.js corre en el navegador del usuario, sin backend.

Si prefieres más control, el Alojamiento de Aplicaciones de Kinsta añade escalado, despliegues personalizados con Dockerfile y analíticas con datos históricos y en tiempo real. Y si trabajas con WordPress, su hosting gestionado incluye migraciones ilimitadas, soporte 24/7, Cloudflare integrado, infraestructura de Google Cloud y cobertura global en decenas de centros de datos; es un ecosistema estable para proyectos que mezclarán web y visión por ordenador.

Modelos y familias: de R-CNN a YOLOv8 pasando por SSD

La evolución de la detección ha ido de pipelines en dos pasos a soluciones de una sola pasada. R-CNN y variantes (Fast, Faster y Mask R-CNN) se apoyan en propuestas de regiones para detectar y luego clasificar, con Mask R-CNN extendiendo además a segmentación por píxel. Por su parte, SSD y YOLO predicen directamente cuadros y clases en una sola inferencia, lo que los hace ideales para tiempo real.

YOLO aporta una visión holística de la imagen completa en cada evaluación, capturando contexto y reduciendo falsos positivos en escenas complejas. Versiones como YOLOv3 y YOLOv4 marcaron un salto de rendimiento; más tarde, YOLOv5 y YOLOv8 han refinado aún más velocidad y precisión. Su filosofía ‘You Only Look Once’ encaja con webcam y streaming al exigir baja latencia y altas tasas de fotogramas.

Para seguimiento multiobjeto, los detectores se combinan con trackers. Con YOLOv8 es habitual integrar ByteTrack, conocido por su equilibrio entre precisión y robustez, o alternativas como BoTSort. En Python, lanzar hilos paralelos permite atender múltiples flujos simultáneos, donde cada hilo gestiona su propia instancia de detección y tracking para cámaras de vigilancia o análisis de varias fuentes en paralelo.

Si trabajas en VS Code, la experiencia es directa: cargas el modelo (por ejemplo, un YOLOv8 de tamaño medio), ajustas el backend (CPU/GPU) y ejecutas inferencias sobre vídeo pregrabado o directamente sobre la webcam. Cambiar de fuente a captura en vivo permite comprobar el comportamiento frente a oclusiones, cambios de iluminación y movimiento de cámara, claves del rendimiento real en escenarios dinámicos.

Datos, anotación y métricas: la base del rendimiento

Sin datos buenos, no hay detección fiable. Los conjuntos PASCAL VOC, MS COCO o ImageNet han sido fundamentales para entrenar y evaluar detectores. Cada imagen se anota con clases y cajas; la diversidad (fondos, tamaños, condiciones de luz) es crucial para que el modelo generalice. Cuando no tenemos datos suficientes, el aprendizaje por transferencia sobre modelos preentrenados es la vía más eficiente en costes.

En entrenamiento y evaluación, las métricas más comunes son mAP (precisión media promedio) e IoU (intersección sobre unión). El mAP mide precisión promediada a diferentes umbrales de IoU; en benchmarks de referencia hay modelos que superan el 60–70% mAP en COCO. Además, para producción interesa medir latencia, throughput y estabilidad, especialmente si el objetivo es streaming en tiempo real.

La segmentación semántica y de instancias va un paso más allá al etiquetar píxeles. En tareas donde la forma exacta importa (p. ej., médica o industrial), Mask R-CNN puede delimitar con precisión los contornos. No siempre es necesario para webcam, pero añade valor cuando el área del objeto, y no solo su presencia, es relevante para tomas de decisión.

El pipeline típico arranca con preprocesado (redimensionar, normalizar, aumentos), pasa por la red convolucional para extraer rasgos y finalmente predice cajas y clases. En aplicaciones en vivo, optimizar esta cadena y reducir cómputo redundante marca la diferencia para mantener una experiencia fluida en equipos con recursos modestos.

YOLOv3 en acción: webcam, vídeo y entrenamiento personalizado

Si prefieres Python y PyTorch, YOLOv3 sigue siendo una opción sólida para webcam y vídeo. Hay repositorios que permiten ejecutar detección sobre streams en vivo y ficheros, con instrucciones para instalar dependencias, descargar pesos preentrenados y preparar un entorno reproducible. Cuando hay GPU NVIDIA, las ganancias de velocidad en inferencia resultan muy notables.

Entorno y dependencias. Puedes crear un entorno con Anaconda específico (por ejemplo, ‘deteccionobj’ con Python 3.6) e instalar los paquetes listados en ‘requirements.txt’ del proyecto. Esto evita conflictos de versiones y asegura que PyTorch y el resto de librerías son compatibles con tu hardware y sistema.

Pesos preentrenados. Descarga los ‘weights’ oficiales para ahorrar el coste de entrenar desde cero. Colócalos en el directorio correspondiente (por ejemplo, ‘weights/’) para que el script detecte y cargue el checkpoint. Así podrás lanzar detección sobre webcam de forma inmediata sin fase previa de entrenamiento.

Ejecución sobre webcam o vídeo. Normalmente el repo incluye comandos o flags para elegir la fuente: webcam en vivo o un archivo de vídeo. Cambiando el parámetro o el índice de la cámara iniciarás la detección sobre la fuente deseada. Con GPU, verás cómo aumenta el número de FPS y se reduce la latencia, manteniendo cuadros y etiquetas de forma estable.

Entrenar tus clases. Si quieres detectar categorías propias, etiqueta imágenes en formato VOC y genera la configuración de red (archivo ‘.cfg’) para transfer learning. La estructura típica de datos es ‘data/custom/images’ para imágenes y ‘data/custom/labels’ para anotaciones, con un ‘.txt’ por cada ‘.jpg’. Define ‘data/custom/classes.names’ con un nombre por línea y lista rutas en ‘train.txt’ y ‘valid.txt’. A partir de ahí, el script de entrenamiento ajustará los pesos del modelo a tu dominio específico.

Detección de objetos con YOLOv8 y seguimiento multiobjeto

La versión YOLOv8 de Ultralytics facilita un flujo moderno con detección y tracking integrados. Configurar un modelo de tamaño medio suele dar un buen equilibrio; si cuentas con hardware solvente, incluso modelos más grandes pueden ir en tiempo real. El tutorial típico muestra cómo lanzar inferencia, visualizar resultados y cambiar de vídeo a webcam sin complicaciones.

Trackers habituales. ByteTrack es un candidato fuerte por su precisión y fiabilidad, aunque BoTSort es otra alternativa consolidada. El identificador único por objeto ayuda a hacer seguimiento pese a oclusiones o cambios de trayectoria; en demos en directo es fácil comprobar la solidez del sistema cuando el sujeto se cruza con otros elementos o sale y entra del encuadre.

Multistream. Cuando la tarea requiere vigilar varias cámaras, el enfoque con hilos de Python permite levantar una instancia por stream. Cada hebra lanza su detector y su tracker, maximizando el uso de núcleos y manteniendo la independencia de los pipelines. Es un patrón práctico para centros de control, retail o analítica urbana.

Edge AI: ESP32Cam, Jetson y plataformas sin código

No todo es navegador o servidor. En el extremo opuesto están los dispositivos embebidos, donde el procesamiento se hace en el mismo equipo que captura. Con ESP32Cam abundan los ejemplos, aunque muchos artículos en realidad delegan el cómputo en un PC y usan el módulo como simple cámara; si hace falta visualizar en un ordenador, existen herramientas para ver las cámaras IP desde la PC. Existen proyectos autónomos (por ejemplo, lectura de códigos QR on-device) y la comunidad busca activamente decodificar también códigos de barras sin depender de backend.

Si necesitas más músculo en el borde, el ecosistema NVIDIA Jetson (Nano Orin, NX Orin, AGX Orin) permite convertir prácticamente cualquier cámara en una cámara con IA. Hay soluciones que integran modelos de detección y seguimiento listos para campo, incluyendo herramientas comerciales que prometen transformar cualquier flujo en analítica accionable. Para quien no quiere escribir código, plataformas de visión como ‘visionplatform.ai’ admiten cargar modelos y operar detección/tracking sin tocar una línea, reduciendo tiempo de integración.

Este abanico de opciones cubre desde demostraciones en navegador hasta despliegues industriales. Elegir entre browser, Python con GPU o edge depende del presupuesto, la latencia objetivo, la conectividad disponible y la necesidad de privacidad de datos en el dispositivo.

Casos de uso y aplicaciones transversales

La detección de objetos se utiliza en vigilancia y control de accesos, con software de videovigilancia (detección de personas, reconocimiento de rostros), retail (análisis de comportamiento y stock), automoción (detección de peatones y vehículos), salud (anomalías en imágenes médicas) o agricultura (monitorización de cultivos y plagas). La clave está en combinar clasificación y caja delimitadora para entender el contexto y tomar decisiones en entornos cambiantes.

En ciudades inteligentes, la detección en tiempo real facilita conteos, seguimiento de trayectorias y alertas. En fábricas, ayuda a control de calidad y seguridad laboral. Y en productos de consumo, se integra en experiencias de RA y utilidades como escáneres de códigos. Elegir el modelo correcto (por ejemplo, YOLO para latencia baja) y ajustar el pipeline de datos marca el éxito a escala productiva.

Paso a producción y consideraciones adicionales

Si vas a publicar una demo web, además del hosting (por ejemplo, sitios estáticos gratuitos en Kinsta desde tu repositorio Git), recuerda los permisos de cámara y la UX asociada. También es habitual ver banners de cookies que informan del uso de almacenamiento local y analítica; estos avisos ayudan a cumplir normativa y a explicar qué datos se manejan en el navegador del usuario.

En despliegues Python, documenta la versión de CUDA, los drivers y la versión de PyTorch/TensorFlow, y consulta guías sobre problemas de reconocimiento de periféricos. Mantener un ‘requirements.txt’ y scripts de arranque claros te ahorra horas al replicar entornos. Si vas a entrenar, automatiza la creación de ‘train.txt’ y ‘valid.txt’, y cuida la consistencia entre ‘classes.names’ y las etiquetas de tus anotaciones para evitar errores sutiles.

Todo lo anterior converge en un panorama en el que puedes empezar con una app React que ejecuta COCO-SSD en el navegador, dar el salto a YOLOv3 o YOLOv8 con webcam y tracking sobre GPU, o moverte al edge con ESP32Cam/Jetson y soluciones sin código. La elección depende de tus requisitos de precisión, latencia, coste y facilidad de operación, pero el camino para pasar de idea a prototipo y de prototipo a producto viable nunca había sido tan corto.

La esencia de la detección desde la webcam es que puedes combinar rapidez de implementación con potencia real: una SPA con TensorFlow.js para validar, YOLO para exprimir rendimiento, datasets bien anotados para entrenar a medida y un despliegue que, según tu caso, puede ser tan simple como un sitio estático o tan robusto como una aplicación con tracking multipista en GPU o un dispositivo embebido; con estos bloques, montar soluciones prácticas es cuestión de horas más que de semanas, manteniendo el control de la experiencia en tiempo real.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.