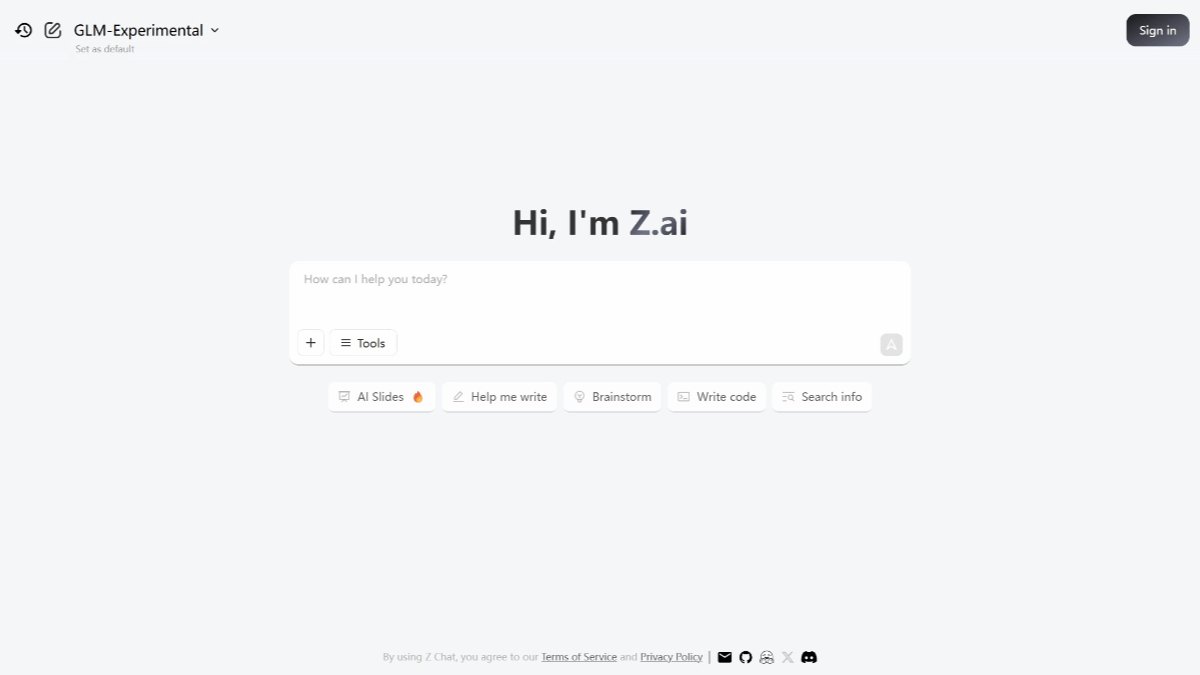

- Z.AI es una plataforma de chat con IA gratuita basada en modelos propios GLM-4.5 y GLM-4.6, centrada en razonamiento y código.

- Su desarrolladora, Zhipu AI, es una startup china muy financiada que apuesta por modelos abiertos bajo licencia MIT.

- Los modelos GLM permiten resumir textos largos, programar, analizar archivos y actuar como agentes automatizados con ventanas de contexto muy amplias.

- Z.AI combina acceso inmediato desde el navegador con una API de suscripción pensada para escalar y crear productos de IA a medida.

La pregunta de qué es Z.AI se repite cada vez más entre quienes buscan alternativas potentes a ChatGPT, Claude o Gemini, pero sin cuotas mensuales ni tantas restricciones. Esta herramienta se ha hecho un hueco a base de combinar un chat gratuito muy capaz con una base tecnológica propia: los modelos GLM desarrollados por la compañía china Zhipu AI, una de las grandes promesas del ecosistema de inteligencia artificial del país.

Frente a otros asistentes, Z.AI apuesta por un enfoque bastante directo: acceso inmediato desde el navegador, modelos de lenguaje abiertos y una API de pago pensada para desarrolladores y empresas que quieran integrar la IA en sus productos. Detrás de esta cara “sencilla” hay bastante chicha técnica: razonamiento avanzado, soporte multimodal, capacidades de agente y una estrategia de open source que la diferencia claramente de proveedores cerrados como OpenAI.

Qué es Z.AI y para qué sirve

Z.AI es, en esencia, un chat de inteligencia artificial accesible desde cualquier navegador moderno, sin necesidad de instalar nada y, en muchos casos, incluso sin registro obligatorio. Su función principal es la misma que la de otros asistentes conversacionales: responder preguntas, generar textos, ayudar a programar o analizar documentos, pero con un foco especial en contenidos largos y estructurados.

La plataforma está impulsada por los modelos GLM-4.5 y GLM-4.6, parte de la serie General Language Model, diseñados para ofrecer un equilibrio entre razonamiento profundo, rendimiento en programación y eficiencia en el uso de tokens. Estos modelos le permiten desenvolverse bien tanto en tareas generales (explicar conceptos, redactar correos o artículos) como en escenarios más técnicos (depuración de código, generación de snippets, diseño de flujos tipo agente).

A nivel de experiencia de uso, Z.AI se plantea como una herramienta gratuita para el día a día, con un límite diario de tokens lo bastante generoso como para cubrir las necesidades de la mayoría de usuarios. Cuando se quiere ir más allá —automatizar procesos, integrarla en productos, desarrollar aplicaciones— entra en juego la API de pago, que funciona en formato de suscripción mensual en lugar de facturación por token, con planes que arrancan en torno a los 3 dólares al mes.

Otro punto distintivo es que Z.AI no depende de la infraestructura de OpenAI ni de intermediarios como Cloudflare para su funcionamiento básico. Esto la convierte en una opción interesante para quienes desconfían de las grandes plataformas estadounidenses, buscan diversidad de proveedores o necesitan soluciones más alineadas con ecosistemas tecnológicos alternativos, como el chino.

En la práctica, esto significa que es útil tanto para un estudiante que quiere resumir textos o preparar trabajos, o para quien busque formarse y convertirse en asistente virtual, como para un profesional de marketing que necesita generar borradores de campañas, un desarrollador que quiera soporte al escribir y depurar código, o un pequeño equipo que busque montar un MVP con capacidades de IA en pocos días.

Zhipu AI: la empresa detrás de Z.AI

Para entender bien qué es Z.AI conviene mirar a Zhipu AI, la compañía responsable de sus modelos. Su nombre completo es Beijing Zhipu Huazhang Technology, y nació originalmente como un proyecto vinculado a la Universidad de Tsinghua, una de las instituciones académicas más prestigiosas de China. Con el tiempo, la iniciativa universitaria se transformó en una startup independiente centrada por completo en el desarrollo de modelos de lenguaje masivos.

Dentro del ecosistema chino, Zhipu AI se ha ganado la etiqueta de uno de los “Tigres de la IA”, un grupo reducido de empresas que están liderando el desarrollo de LLM en el país. Según datos de International Data Group, la compañía se sitúa ya como el tercer actor más importante en el mercado chino de modelos de lenguaje, lo que da una idea del nivel de ambición y de la velocidad con la que ha crecido.

El apartado de financiación es especialmente llamativo: en 2023, Zhipu AI recaudó más de 2,5 mil millones de yuanes procedentes de gigantes como Alibaba y Tencent. A esta lista se suman otros inversores de primer nivel, entre ellos Ant Group, Meituan, Xiaomi y HongShan, que han apostado por la empresa como una pieza clave del futuro de la IA en la región.

En 2024 la cosa no se frenó, al contrario: el fondo saudí Prosperity7 Ventures inyectó unos 400 millones de dólares, elevando la valoración de Zhipu AI a unos 3.000 millones. Esta entrada de capital internacional refuerza la posición de la compañía como competidor global, no solo local, y le da músculo para acelerar la investigación en modelos de texto, voz y vídeo.

En paralelo, la empresa ha ido ampliando su oferta más allá de los modelos GLM que impulsan Z.AI. Ha trabajado en tecnologías de texto a vídeo similares a Sora, ha lanzado modelos de voz de extremo a extremo y ha presentado aplicaciones tipo agente como AutoGLM, pensadas para ejecutar tareas complejas en dispositivos móviles de forma casi autónoma.

Estrategia open source y ecosistema de modelos GLM

Uno de los elementos que más diferencian a Zhipu AI de otros actores del sector es su apuesta por el open source. Mientras que OpenAI o algunos modelos de Google se distribuyen con licencias muy restrictivas, la serie GLM se publica bajo licencia MIT, una de las más permisivas del mundo del software. Esto implica que cualquiera puede descargar los modelos, ejecutarlos en local, modificarlos y utilizarlos con fines comerciales, siempre respetando los términos de la licencia.

Los modelos GLM pueden encontrarse en repositorios públicos como HuggingFace o Model Scope, lo que facilita enormemente su adopción por parte de la comunidad técnica. Desarrolladores, investigadores y empresas pueden experimentar con ellos, ajustarlos a sus propios datos y desplegarlos en su propia infraestructura, sin necesidad de depender de los servidores de Zhipu AI si no lo desean.

Esta filosofía de apertura contrasta con el enfoque más cerrado de OpenAI, donde el acceso a modelos como GPT-5 pasa por el uso de sus APIs propietarias, normalmente bajo un esquema de pago por uso. En el caso de GLM, la infraestructura es flexible: se puede utilizar la plataforma Z.AI como puerta de entrada rápida y sencilla, o bien optar por integrar directamente los modelos abiertos en entornos propios, ya sea en la nube o on-premise.

A nivel técnico, los modelos GLM que dan vida a Z.AI se basan en arquitecturas de tipo MoE (Mixture of Experts), que combinan diferentes “expertos” internos para resolver mejor tipos distintos de tareas. Esta aproximación permite mejorar el rendimiento en escenarios complejos, mantener una buena eficiencia de cálculo y ofrecer resultados competitivos en benchmarks de razonamiento y programación frente a modelos punteros como GPT-5.

Además, Zhipu AI trabaja activamente para garantizar la compatibilidad de sus modelos con chips y ecosistemas alternativos a los dominados por NVIDIA. Han anunciado soporte para procesadores Huawei Ascend y para hardware de Cambricon, lo que encaja con la estrategia china de reducir dependencia de tecnologías occidentales y crear un stack de IA más soberano.

Características clave de Z.AI como plataforma

A nivel de usuario, lo que más llama la atención de Z.AI es que se puede empezar a chatear prácticamente al instante. En muchos casos ni siquiera es necesario crear una cuenta, basta con abrir la página en el navegador, elegir un modelo y escribir la primera consulta. Esta inmediatez y la sensación de “entra y usa” la diferencian de otras herramientas que obligan a pasar por formularios largos, verificaciones o incluso introducir tarjeta de crédito desde el primer momento.

La interfaz web está pensada para ser simple y directa: un área de conversación tipo chat, un selector de modelo y algunas opciones adicionales relacionadas con funciones avanzadas como la búsqueda web o el razonamiento profundo. No hay menús infinitos ni configuraciones abrumadoras, así que cualquiera que haya usado ChatGPT, Claude, Perplexity u otro asistente similar se sentirá cómodo en cuestión de segundos.

En cuanto a formatos, Z.AI no se limita solo a texto plano. La plataforma puede analizar archivos como PDF, Word o TXT, así como trabajar con imágenes en escenarios multimodales. Esto abre la puerta a casos de uso como resumir un informe completo, comentar un contrato, extraer puntos clave de una presentación o revisar el contenido de un documento técnico con tablas y gráficos.

Otra capacidad destacable son sus funciones de agente automatizado. En lugar de limitarse a responder de forma aislada a cada mensaje, el modelo puede descomponer tareas complejas en pasos más pequeños, encadenar acciones, llamar a APIs externas y ejecutar flujos relativamente sofisticados. Esto lo hace especialmente útil para automatizar tareas repetitivas o para orquestar procesos donde intervienen varias herramientas.

En lo relativo a la experiencia de escritorio, algunos usuarios han optado por envolver la versión web de Z.AI en aplicaciones no oficiales tipo “wrapper” para macOS y Windows. Estos envoltorios no añaden funciones nativas extra, pero sí permiten trabajar con la plataforma en una ventana dedicada, gestionar múltiples cuentas o integrarla mejor en el flujo de trabajo del sistema operativo, como si fuera una app independiente.

Modelos GLM-4.5 y GLM-4.6: qué aporta cada uno

El corazón de Z.AI está en sus modelos de lenguaje, y en la actualidad los protagonistas son GLM-4.5 y GLM-4.6. Ambos pertenecen a la misma familia, pero están optimizados para resolver mejor tipos específicos de tareas y para ofrecer diferentes equilibrios entre rendimiento, coste y consumo de tokens.

GLM-4.5 actúa como modelo “generalista” dentro de la plataforma. Es la opción recomendada para preguntas de cultura general, redacción básica, generación de textos no excesivamente largos y tareas donde lo más importante es un equilibrio entre calidad y eficiencia. Para la mayoría de usuarios, este modelo cubre perfectamente necesidades cotidianas como redactar emails, resumir artículos breves, generar borradores de posts o pedir explicaciones de conceptos técnicos.

GLM-4.6, por su parte, es la versión más avanzada y potente, especialmente cuando se activa con el modo de razonamiento profundo o se utiliza en su variante especializada en programación. Su ventana de contexto puede llegar hasta los 128.000 tokens de entrada y unos 96.000 de salida, lo que permite trabajar con documentos muy extensos, conversaciones prolongadas y análisis detallados sin que el modelo pierda coherencia o se “olvide” del principio de la conversación.

En el terreno de la codificación, los benchmarks internos y comparativas prácticas señalan que la variante de GLM-4.6 optimizada para código supera a varios competidores en decenas de escenarios reales, llegando a mostrar una mejora de alrededor de un 30 % en eficiencia en un conjunto de 74 pruebas típicas de desarrollo y depuración. Esto se traduce en menos errores, propuestas de solución más útiles y mejor comprensión del contexto de un proyecto.

Además, GLM-4.6 se ha diseñado pensando explícitamente en su despliegue sobre chips domésticos chinos, incluyendo los procesadores de Cambricon Technologies y otros hardware alineados con la estrategia tecnológica del país. Esta compatibilidad le da margen para escalar en infraestructuras alternativas y evitar cuellos de botella derivados de la dependencia de GPUs occidentales.

Cómo elegir el modelo adecuado en Z.AI

Una de las claves para sacarle jugo a Z.AI es elegir bien el modelo en cada caso. Usar siempre el modelo más potente puede sonar tentador, pero no siempre es necesario y, además, implica un consumo mayor de tokens. En cambio, ajustar la elección al tipo de tarea ayuda a mejorar tanto la calidad de las respuestas como la eficiencia.

Si el objetivo es resumir textos largos, como informes extensos, manuales o trabajos académicos, la mejor opción suele ser GLM-4.6 en modo de razonamiento profundo. Gracias a su enorme ventana de contexto, puede procesar documentos de hasta unos 200.000 tokens, mantener la visión global del contenido y sintetizar la información de manera coherente, sin perder matices importantes.

Para tareas de programación y depuración de código, lo más recomendable es la variante de GLM-4.6 afinada para codificación. Esta versión está entrenada y evaluada de manera específica en escenarios de desarrollo, por lo que resulta especialmente hábil a la hora de entender repositorios, explicar errores, proponer tests, refactorizar funciones o generar snippets funcionales en distintos lenguajes.

Cuando lo que se busca son respuestas generales, redacción básica o consultas rápidas, GLM-4.5 suele ser el modelo ideal. Consume menos recursos, ofrece un rendimiento más que suficiente en la mayoría de situaciones y permite aprovechar mejor los límites diarios del plan gratuito, al no “gastar” tantos tokens por interacción.

Si la tarea pasa por analizar archivos y combinarlo con búsqueda en la web, el candidato preferente vuelve a ser GLM-4.6, esta vez con la función de Búsqueda Web activada. Esta configuración permite cargar documentos (PDF, Word, TXT) y, al mismo tiempo, enriquecer el análisis con información actualizada de Internet, lo que es especialmente útil para estudios de mercado, investigación, verificación de datos o seguimiento de noticias.

En todos los casos, conviene tener claro que el consumo de tokens depende tanto del modelo elegido como de la longitud de los mensajes y la complejidad de la tarea. Si se agota la cuota diaria en el plan gratuito, toca esperar hasta el día siguiente para seguir usando el chat, así que ser selectivo con el modelo y redactar prompts claros ayuda a estirar bastante ese límite.

Cómo empezar tu primer chat con Z.AI

Ponerse en marcha con Z.AI no tiene mucha ciencia: el flujo es muy parecido al de otros chatbots que ya se han hecho populares. Aun así, seguir unos pasos básicos ayuda a aprovechar mejor la primera sesión y a evitar malgastar tokens en pruebas desordenadas.

Lo primero es acceder a la página oficial de la plataforma desde el navegador. Una vez dentro, lo habitual es que puedas empezar a usar el chat sin necesidad de registro, lo que de paso reduce la fricción y mejora la sensación de privacidad, ya que no tienes que facilitar datos personales ni tarjetas de crédito para probar la herramienta.

El siguiente paso clave es seleccionar el modelo de lenguaje adecuado. En la interfaz verás varias opciones de la serie GLM, cada una orientada a un tipo de tarea: modelos generales, variantes optimizadas para código, opciones con búsqueda web o modos de razonamiento profundo. Elegir bien aquí marca la diferencia entre una respuesta normalita y una solución realmente útil.

Una vez elegido el modelo, basta con escribir la consulta en el campo de texto y pulsar enviar. A partir de ahí, la conversación puede continuar de manera natural, haciendo preguntas de seguimiento o afinando la petición inicial. Z.AI mantiene el contexto dentro del hilo, de modo que no hace falta repetir todo desde cero en cada mensaje, lo que resulta especialmente cómodo en sesiones largas.

Una buena práctica en estas primeras pruebas es preparar de antemano unas cuantas preguntas reales de tu día a día (por ejemplo, algo de marketing, un problema de producto, una duda de código) y usarlas para evaluar tanto la calidad como la velocidad de las respuestas. Así tendrás una idea bastante clara de si Z.AI encaja en tu flujo de trabajo y en qué tareas brilla más.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.