- SAM 3 entiende texto complejo para segmentar y seguir objetos en imágenes y vídeo con precisión.

- SAM 3D reconstruye objetos y personas desde una sola imagen y permite exportar objetos en PLY o vídeo.

- Playground facilita probar, seleccionar y exportar, con módulo humano limitado para evitar usos sensibles.

- Aplicaciones reales en Edits, Vibes y Marketplace, además de potencial en robótica, ciencia, educación y AR/VR.

En los últimos meses, el mundo de la edición y la creación visual ha dado un salto importante con la llegada de SAM 3 y, especialmente, de SAM 3D. Meta ha presentado una tecnología capaz de detectar, seguir y reconstruir objetos y personas en 3D con una facilidad que, hasta hace nada, parecía ciencia ficción. Este avance acerca la edición avanzada y la visualización tridimensional a cualquiera con un navegador y ganas de trastear.

Lo interesante no es solo que el sistema “vea” qué hay en una foto o un vídeo, sino que además entiende lo que le pedimos por texto y lo lleva a cabo con precisión. Ahora puedes escribir el nombre de un objeto en un cuadro de prompt, o hacer clic sobre él, y el modelo lo aísla para editarlo, seguirlo en movimiento o convertirlo en un modelo tridimensional utilizable en software profesional, incluyendo técnicas para crear personajes 3D. Todo ello, además, arropado por una plataforma web de pruebas que hace que experimentar sea un paseo.

Qué es SAM 3 y qué aporta SAM 3D

Cuando hablamos de SAM 3, nos referimos a la nueva generación del famoso Segment Anything Model de Meta centrada en detección y segmentación en imágenes y vídeo. La gran diferencia con respecto a versiones anteriores es la comprensión de instrucciones de texto más complejas, que permite localizar no solo “un coche” o “una pelota”, sino conceptos mucho más específicos como “gorro de béisbol rojo”. Esta capacidad eleva la segmentación a otro nivel, haciendo posible filtrar y transformar elementos con un control fino.

El hermano más llamativo es SAM 3D. Este modelo da un paso más allá al reconstruir la geometría y la apariencia de objetos y personas a partir de una única imagen. Con las máscaras y detecciones de SAM 3 como base, SAM 3D aísla el elemento seleccionado y lo reconstruye para exportarlo y utilizarlo en pipelines de 3D, ya sea en software de modelado como Blender o en motores de videojuegos como Unreal Engine o Unity.

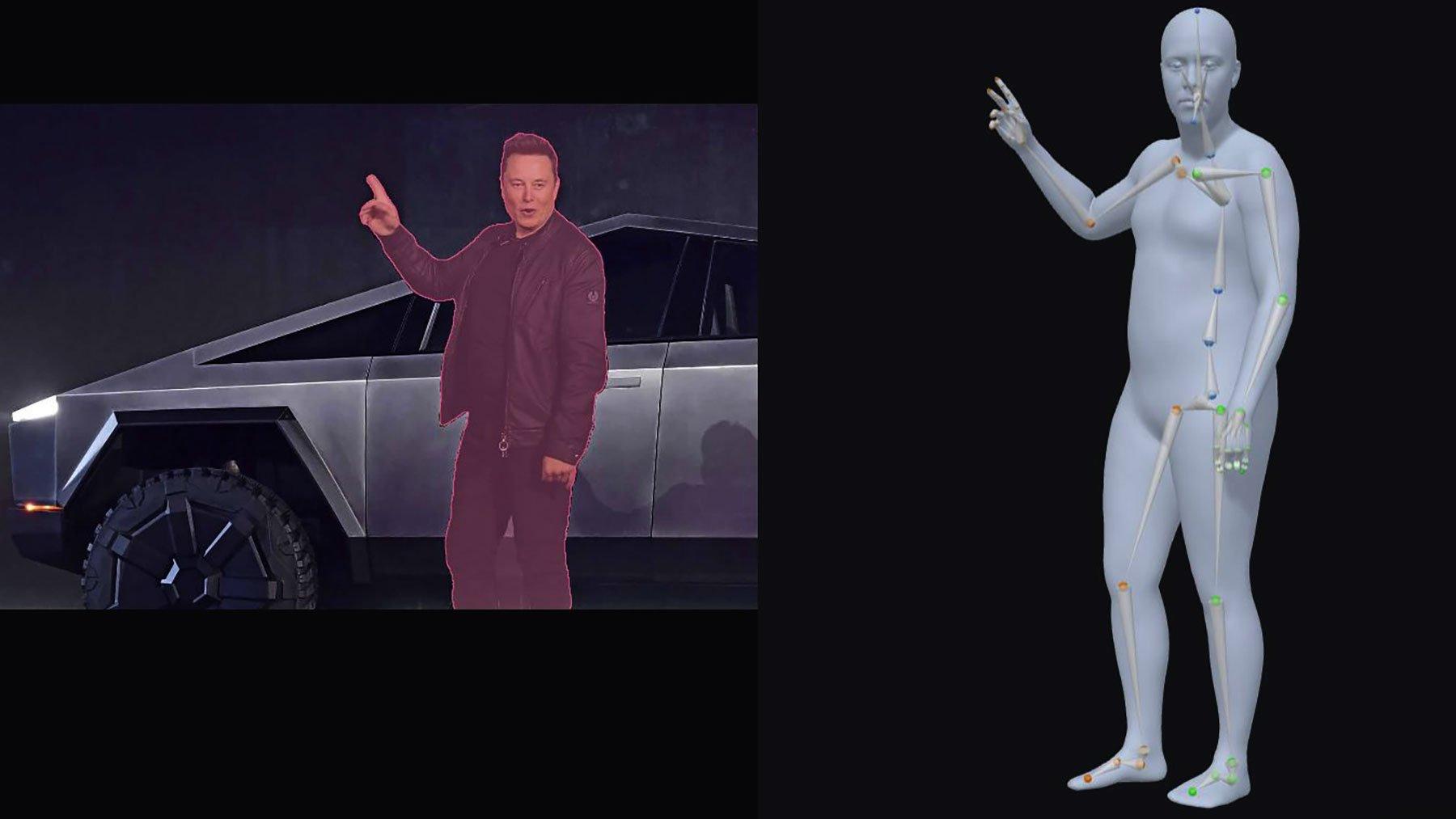

Meta ha diseñado SAM 3D con dos módulos diferenciados para cubrir casos de uso distintos. Por un lado está el módulo orientado a objetos y escenas, ideal para seleccionar elementos en una foto y reconstruirlos; por otro, un módulo especializado en personas que, además de segmentar, genera una malla aproximada con esqueleto y ajusta la pose para visualización.

Eso sí, hay matices importantes en la exportación. En el Playground, el módulo para personas no permite extraer modelos 3D completos, mientras que en el caso de objetos la herramienta puede exportar el resultado por separado. Este diseño responde a límites de la versión de prueba y a consideraciones de uso responsable en torno a rostros y cuerpos humanos.

Segment Anything Playground: el terreno de pruebas

Para que cualquiera pueda echarse a la mochila estas novedades, Meta ha lanzado Segment Anything Playground, una aplicación web en la que puedes subir fotos o vídeos y empezar a jugar con selecciones y efectos. La interfaz recuerda a la varita mágica de Photoshop: haces clic sobre el objeto, el sistema genera una máscara y tú la vas refinando hasta dejarla a tu gusto.

El editor del Playground incluye algunos prompts predefinidos para arrancar, aunque lo divertido llega cuando subes tu propio contenido. Solo con escribir en el cuadro de instrucciones lo que quieres aislar, SAM 3 entiende la orden y te prepara la selección automáticamente. Para quien edite vídeo, esto es oro: segmentar y seguir un elemento cuadro a cuadro era, hasta ahora, un trabajo tedioso.

Conviene remarcar que la herramienta es deliberadamente sencilla. No pretende competir con editores profesionales como Premiere, sino mostrar el potencial del modelo de segmentación y, de paso, enseñar cómo puede integrarse en flujos más complejos. Aun así, ya permite recortar, añadir efectos y visualizar cómo respondería a distintas indicaciones.

En lo que respecta a exportación, el Playground permite sacar los resultados por separado. Para objetos, se pueden exportar archivos PLY o incluso un vídeo con la reconstrucción. Es una forma rápida de mover el material a tu software 3D favorito o de preparar una previsualización sin complicarte, por ejemplo para una presentación 3D con animación.

Para quienes trabajan con personas, el módulo humano del Playground, como decíamos, no habilita la extracción del modelo final. Aun así genera una malla aproximada con esqueleto y pose ajustada para visualización, suficiente para comprobar el potencial y entender cómo encajaría en un pipeline más completo en un futuro.

Resultados, limitaciones y cómo sacarles partido

Si vienes esperando modelos hiperrealistas nada más exportar, mejor bajar un pelín las expectativas. Los objetos se exportan como nubes de puntos, no como mallas. Es un formato habitual en fotogrametría y reconstrucción, muy útil como base, pero requiere un paso adicional si quieres una malla limpia con texturas y todo el paquete.

La parte buena es que ese paso extra se puede completar con herramientas consolidadas. Programas como MeshLab o los nodos de geometría de Blender sirven para convertir la nube de puntos en una malla y seguir puliendo; o incluso usar el constructor 3D de Windows. No tendrás un modelo ultrarrealista de primeras, pero es una buena aproximación para empezar a iterar.

Es importante distinguir lo que muestra el Playground de lo que podrías lograr con trabajo de postproceso. El visor del Playground ofrece una vista llamativa del resultado, pero llevarlo a producción implica limpieza, retopología y, si hace falta, proyección de texturas. No es magia, aunque sí un ahorro enorme de tiempo en la etapa de captura o segmentación inicial.

En el caso de personas, además del límite de exportación, hay que considerar las implicaciones éticas. Reconstruir cuerpos o rostros sin permiso puede tener consecuencias legales y reputacionales. Por eso, aunque la tecnología permita ciertas cosas, la recomendación pasa por trabajar con consentimiento explícito y contextos adecuados.

Como práctica recomendada, antes de lanzarte a publicar modelos, asegúrate de revisar metadatos, origen del material y permisos. La propia Meta afirma que integrará controles para reducir usos indebidos, pero en última instancia la responsabilidad sobre el contenido y su difusión recae en quien lo crea y lo comparte.

Textos, indicaciones y detección: la clave de SAM 3

Más allá del 3D, el salto cualitativo de SAM 3 está en su entendimiento del lenguaje. Ahora puede procesar descripciones detalladas y vincularlas con elementos específicos en imágenes y vídeos, ampliando el alcance de la segmentación mucho más allá de categorías genéricas. Esto habilita flujos de trabajo basados en prompts que antes eran imposibles.

Esta mejora se sustenta en una arquitectura entrenada con grandes volúmenes de datos y en la combinación de indicaciones visuales y textuales. El modelo hace “match” entre lo que escribes y lo que ve, interpretando conceptos y relaciones visuales con mayor precisión que en SAM 1 o SAM 2, que funcionaban bien con pistas visuales pero flojeaban en lenguaje natural complejo.

Otro concepto clave que aparece en el modelo es la generalización de cero disparos (zero-shot). En la práctica, esto significa que puede segmentar objetos que no ha visto en su base de datos siempre que se le dé una referencia visual o textual adecuada. Esta capacidad es esencial para el mundo real, donde los elementos son variados y no siempre coinciden con categorías cerradas.

Según la información disponible, el entrenamiento de este ecosistema se apoyó en un volumen masivo de máscaras de diferentes fuentes públicas. Se mencionan repositorios visuales ampliamente extendidos como Wikipedia, Flickr o Instagram, lo que explica la robustez del modelo para generalizar y su desempeño al identificar objetos en contextos heterogéneos.

Como beneficio colateral, SAM 3 ofrece salidas de múltiples máscaras, algo muy útil para canalizar resultados a otros sistemas. Estas máscaras se pueden encadenar con editores 2D y 3D, herramientas de tracking de vídeo o procesos creativos como composiciones y collages, agilizando flujos de postproducción de forma considerable.

Integración en productos de Meta y usos reales

La estrategia de Meta no se queda en el laboratorio. La compañía ha anunciado que integrará SAM 3 en Edits, su herramienta para la creación de vídeos cortos en Instagram y Facebook, similar a CapCut. Esto abre la puerta a filtros de segmentación más finos, efectos aplicados a elementos concretos y cambios de fondo sin sacrificar calidad.

En el ámbito de las experiencias generativas, Meta también apunta a Vibes, donde prevé aplicar su modelo de segmentación en vídeos creados por IA. La idea es utilizar la precisión de SAM 3 para aislar y transformar elementos dentro de clips sin intervención manual enmascarando cada fotograma, algo que complica mucho los flujos tradicionales.

Quizá la aplicación más tangible para el gran público llegue a través del comercio. En Facebook Marketplace, la función View in Room permitirá visualizar productos en casa, usando modelos 3D generados automáticamente que pueden ayudar a generar escenas 3D de aspecto cinematográfico. Piénsalo con lámparas o muebles: apuntas la cámara al salón y ves cómo quedaría ese objeto antes de comprar.

Más allá de redes y compras, el potencial trasciende el entretenimiento. Se señalan aplicaciones en robótica, ciencia, educación, creación de videojuegos o experiencias VR/AR. Poder reconstruir en 3D a partir de una foto simplifica enormemente la captura y prototipado para simuladores, análisis y contenidos formativos.

En medicina deportiva, por ejemplo, el uso de reconstrucciones basadas en imágenes puede ayudar a generar materiales didácticos o simulaciones de movimientos. Estos escenarios aún requieren validación clínica y procesos de calidad, pero la base técnica de segmentación y reconstrucción abre una vía de exploración prometedora.

Cómo se trabaja con objetos y personas en SAM 3D

El módulo de objetos y escenas funciona con una lógica de selección asistida. Seleccionas un elemento con un clic y el sistema genera una máscara al estilo “varita mágica”, reconociendo bordes y características. Después, puedes perfilar esa máscara e iniciar la reconstrucción para su exportación.

En esa exportación, el formato protagonista es PLY, que consiste en la nube de puntos que representa el objeto. Este archivo se puede llevar a herramientas como Blender o MeshLab para convertirlo en malla y seguir puliendo; o incluso usar el para operaciones rápidas. Este archivo se puede llevar a herramientas como Blender o MeshLab para convertirlo en malla y seguir puliendo. Este archivo se puede llevar a herramientas como Blender o MeshLab para convertirlo en malla y seguir puliendo. No tendrás un modelo ultrarrealista de primeras, pero es una buena base para seguir trabajando.

El módulo de personas sigue una filosofía similar en cuanto a selección, pero su salida está restringida en la versión web de pruebas. Genera una malla aproximada con esqueleto y ajusta la postura, una función práctica para visualizar la figura o la pose, aunque sin descarga del modelo 3D completo desde el Playground.

Esta diferenciación responde tanto a cuestiones técnicas como a valoraciones éticas. El tratamiento de datos biométricos y la reconstrucción de identidades exigen cautela, por lo que limitar la exportación en el módulo humano evita usos sensibles mientras la comunidad y las herramientas de control maduran.

Recursos abiertos, benchmarking y comunidad

Para impulsar la investigación y la adopción, Meta ha puesto a disposición recursos del modelo y conjuntos de datos de benchmarking. Investigadores, desarrolladores y artistas pueden acceder al código y a colecciones de imágenes diversificadas con las que evaluar el rendimiento y comparar resultados de forma consistente.

Esta apertura no solo sirve para medir el estado del arte. También sienta bases comunes para que la comunidad itere, encuentre límites y proponga mejoras en ámbitos como la fidelidad geométrica de las reconstrucciones, la robustez ante oclusiones o la comprensión de lenguaje natural en dominios especializados.

Es importante, eso sí, respetar el marco de uso. Meta insiste en que el modelo debe emplearse con fines investigativos en esta fase y no para usos comerciales directos. Este enfoque ayuda a acotar riesgos, a la vez que se recopilan evidencias y se construyen mejores prácticas.

En paralelo, distintos equipos creativos y de marketing ya tantean su encaje en flujos reales. Agencias y departamentos de performance exploran cómo aprovechar estas máscaras y reconstrucciones para mejorar la segmentación en campañas o la generación de materiales audiovisuales, conectando con herramientas como Google Ads Data Manager cuando el contenido visual juega un papel clave.

Ventajas prácticas que marcan la diferencia

Ya en el día a día, varias ventajas destacan frente a lo que había. Las múltiples indicaciones de entrada (clics, puntos, texto) simplifican la selección sin pasos intermedios, acelerando la edición. Esta flexibilidad hace que perfiles no técnicos también puedan conseguir resultados dignos.

La interoperabilidad es otra baza. El diseño de SAM facilita la integración con sistemas de AR/VR, editores y motores, por lo que lo normal será verlo como un bloque más dentro de pipelines existentes. Nada de reinventar el flujo, sino de meter una pieza nueva que te ahorra tiempo.

La salida en forma de máscaras múltiples y objetos separados permite canalizar la información a donde toque. Desde rastreo de vídeo hasta composiciones complejas, pasando por pipelines 3D, la idea es que lo que sale de SAM encaje como una llave en cerradura con el resto de herramientas.

Por último, el salto en comprensión del mundo visual, alimentado por grandes repositorios de datos, se nota en el rendimiento en casos reales. Que el sistema entienda “lo que le cuentas” y lo vincule con “lo que ve” es precisamente lo que lo hace útil más allá del laboratorio.

Ética, seguridad y buenas prácticas

La potencia conlleva responsabilidad. Trabajar con imágenes de personas exige consentimiento y respeto a la privacidad, especialmente si se planea compartir o publicar resultados. Evita reconstruir rostros ajenos, manipular escenas sensibles o difundir modelos que puedan revelar información privada.

Cualquier flujo profesional debería incluir revisiones de fuentes y permisos. Verifica la procedencia de las imágenes, elimina metadatos sensibles cuando proceda y limita la distribución a contextos adecuados. Si el contenido incluye menores o colectivos vulnerables, redobla las cautelas o descarta el proyecto.

Meta ha señalado que irá introduciendo controles para reducir el uso indebido, pero eso no exime a los creadores. La rendición de cuentas recae en quien sube, procesa y publica. Adoptar guías internas de ética y seguridad es tan importante como saber usar la herramienta.

Además, si vas a llevar resultados a producción, diseña un pipeline con controles de calidad. Incluye validaciones técnicas (geometría, oclusiones, artefactos) y legales (permisos, licencias), y documenta el proceso para que sea auditable. Reducirás riesgos y ganarás en trazabilidad.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.