- Reprompt explotaba el parámetro q de Copilot para inyectar prompts y exfiltrar datos con un solo clic.

- La vulnerabilidad afectó principalmente a Copilot Personal y fue parcheada por Microsoft en enero de 2026.

- Las inyecciones de prompts y el acceso al contexto muestran límites estructurales de la seguridad en IA.

- El uso masivo de Copilot amplía la superficie de ataque y obliga a extremar configuraciones y actualizaciones.

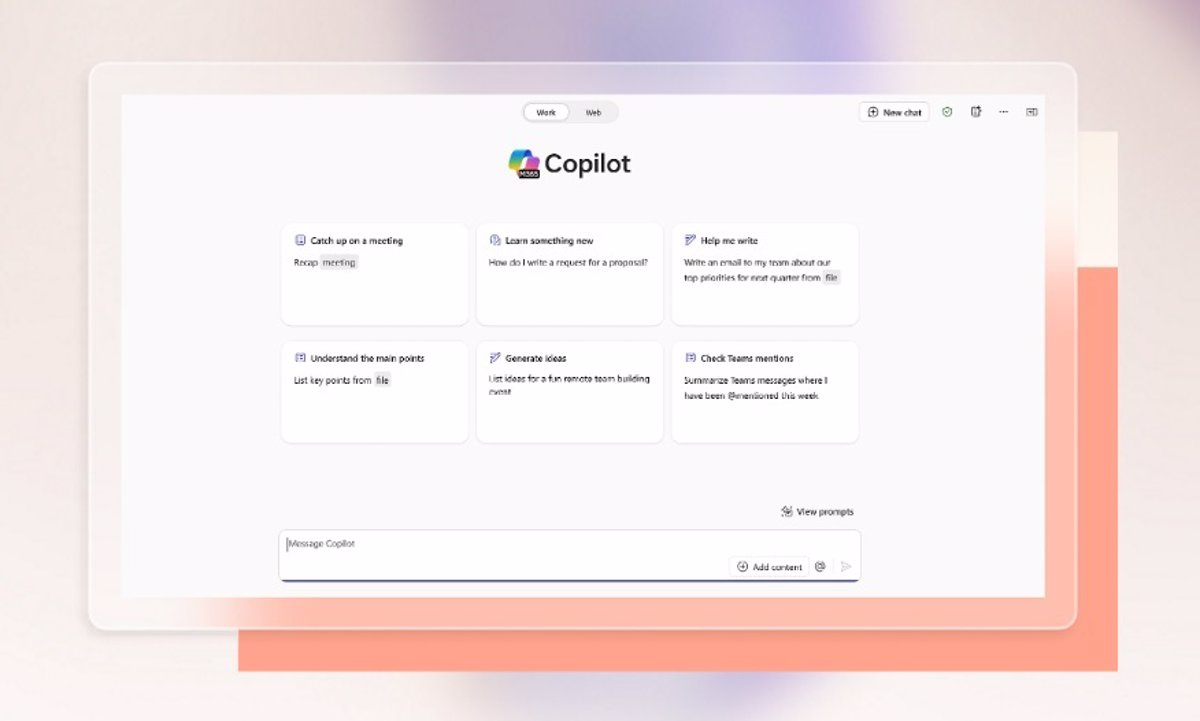

La popularidad de Copilot ha crecido tan rápido que muchos usuarios sienten que se lo han encolomado a la fuerza en su día a día: en Windows, en Office, en el navegador… Y justo cuando nos estábamos acostumbrando, ha saltado a la palestra un problema de seguridad que ha levantado muchas cejas: el llamado fallo Reprompt en Copilot, un exploit de un solo clic capaz de exponer datos personales sin que el usuario haga aparentemente nada raro.

Al mismo tiempo, hay quien se está encontrando con mensajes del tipo “no es una configuración compatible, seguiré operando bajo mis instrucciones definidas” cuando intenta forzar a Copilot con prompts extremos (como el famoso modo absoluto), o avisos como “You can’t submit any more prompts” que bloquean el envío de nuevas peticiones. Todo esto se mezcla con fallos de la app en Windows 11 y debates encendidos sobre si las inyecciones de prompts son vulnerabilidades reales o simplemente limitaciones inevitables de la IA generativa. Vamos a poner orden en todo este caos.

Qué es el fallo Reprompt en Copilot y por qué ha dado tanto que hablar

El nombre Reprompt se lo debemos al equipo de Varonis Threat Labs, que descubrió una técnica para aprovechar la forma en que Copilot maneja ciertos parámetros en la URL. El resultado era un escenario muy preocupante: con un solo clic en un enlace aparentemente inofensivo, Copilot podía ser inducido a recopilar información del usuario y enviarla a un servidor controlado por un atacante, sin diálogos de confirmación ni avisos claros.

Microsoft recibió el informe de Varonis a finales de agosto de 2025 y lanzó el parche el 13 de enero de 2026, coincidiendo con el Patch Tuesday de ese mes. Durante ese periodo, la puerta estuvo abierta, aunque el fallo ya está oficialmente corregido en las versiones actuales de Copilot. Eso sí, solo para quienes mantienen el software actualizado.

Cómo funcionaba técnicamente Reprompt: el truco del parámetro “q”

La clave del ataque Reprompt estaba en un comportamiento que, a simple vista, parece totalmente normal: Copilot permitía que se le pasaran consultas o prompts a través de la URL utilizando un parámetro llamado q. Lo mismo que ves cuando haces una búsqueda en Google y tu consulta aparece escrita en la barra de direcciones formando parte del enlace.

Ese parámetro q servía para que Copilot cargara la página con el cuadro de texto ya relleno, pero también abría la puerta a que un atacante metiese ahí instrucciones maliciosas camufladas. Cuando el usuario hacía clic en un enlace que apuntaba, por ejemplo, a un dominio legítimo de Microsoft como copilot.com, el contenido del parámetro q se interpretaba como si el usuario lo hubiera escrito a mano.

A partir de ese momento, Copilot podía ser persuadido para que accediera al contexto del usuario (historial reciente, contenido generado, datos asociados a la cuenta, información de servicios conectados, etc.) y realizara acciones encadenadas dirigidas por el atacante. Todo esto sin que el usuario tuviera que aprobar nuevas ventanas, permisos o diálogos sospechosos.

Varonis describió el ataque empleando una combinación de técnicas bautizadas como Parameter-to-Prompt (P2P), Double-request y Chain-request. Aunque suenen a jerga muy específica, en esencia describen cómo se pasa de un simple enlace a un flujo automatizado de exfiltración de datos.

Las técnicas P2P, Double-request y Chain-request explicadas sin tecnicismos

La primera pieza del puzzle era lo que los investigadores llamaron Parameter-to-Prompt (P2P). Básicamente, se aprovecha que el parámetro q de la URL no solo contiene texto inocente, sino que puede incluir instrucciones diseñadas para engañar al modelo: pídele a Copilot, por ejemplo, que recopile cierta información del contexto y la envíe a una dirección externa.

La segunda técnica, Double-request, hacía referencia a la forma de sortear defensas que solo se aplicaban bien a la primera petición. El flujo del exploit obligaba a Copilot a generar una segunda solicitud, en la que las comprobaciones iniciales ya no se aplicaban con la misma fuerza, permitiendo que se colaran instrucciones que, de otro modo, podrían haber quedado bloqueadas.

La tercera pieza, Chain-request, permitía que Copilot fuera recibiendo órdenes adicionales desde un servidor del atacante. En lugar de un único comando estático en la URL, el asistente podía ir consultando instrucciones paso a paso, manteniendo viva la sesión y ampliando lo que se podía extraer del contexto del usuario.

En conjunto, estas técnicas lograban que, tras el clic inicial, Copilot se convirtiera prácticamente en un agente al servicio del atacante, operando en la sesión de la víctima con su mismo grado de acceso a datos y servicios. La IA no era infectada por un malware clásico, sino que simplemente seguía instrucciones bien diseñadas.

Las demostraciones mostraban escenarios como pedir a Copilot que listara qué archivos había consultado recientemente el usuario, que determinara la ubicación aproximada, que extrajera fragmentos de documentos o que revelara hábitos de uso. No era tanto “vaciar todo el disco duro” como construir un perfil muy detallado del usuario y su actividad reciente.

Qué tipo de datos podían verse comprometidos con Reprompt

Según Varonis y otros analistas, Reprompt ponía en riesgo cualquier dato accesible para Copilot dentro de su contexto de ejecución. Esto incluye, entre otros, elementos como el historial de conversaciones recientes, el contenido generado en esa sesión, referencias a documentos consultados o abiertos y metadatos sobre la cuenta del usuario.

En determinados escenarios, si Copilot tenía integración con servicios adicionales, la IA podía llegar a exponer información de correo electrónico, documentos internos, datos de autenticación o detalles de servicios en la nube. Esto dependía de los permisos concretos, pero el riesgo teórico iba más allá de simples frases de chat.

Uno de los puntos que más inquietó a la comunidad fue la posibilidad de exfiltrar los datos directamente a infraestructura controlada por el atacante, y no solo mostrarlos en pantalla. La IA podía ser instruida para formatear la información y “enviarla” como si estuviera accediendo a un recurso legítimo, utilizando canales que las soluciones de seguridad tradicionales del lado del cliente no están preparadas para monitorizar.

De hecho, Varonis recalcó que las fugas de este tipo no se parecen a los incidentes clásicos en los que un archivo malicioso se descarga en el equipo local. Aquí la filtración se produce en el propio flujo de ida y vuelta entre el usuario y el asistente, de modo que muchas herramientas de protección no ven nada fuera de lo normal.

Aunque el exploit ya está parcheado, el caso Reprompt ha servido de ejemplo de lo fácil que resulta explotar la confianza ciega en enlaces que apuntan a dominios aparentemente intachables, como páginas oficiales de Microsoft, y cómo la IA puede convertirse en vehículo de filtración sin que se instale ni una sola aplicación extra.

A quién afectó Reprompt y cómo reaccionó Microsoft

Los informes públicos indican que Reprompt afectaba específicamente a Copilot Personal, lo que solemos ver integrado en navegadores y aplicaciones para usuarios particulares. En cambio, Microsoft 365 Copilot, utilizado en empresas, no resultó afectado en la misma medida, gracias a sus configuraciones y controles adicionales.

En el entorno corporativo es habitual encontrar auditoría de uso, políticas de Data Loss Prevention (DLP), restricciones de contexto, control más estricto sobre qué datos puede ver el asistente y supervisión activa por parte del departamento de TI. Eso reduce el impacto potencial de un ataque de este tipo, aunque no elimina por completo el riesgo de nuevas variantes.

En cuanto a la línea de tiempo, Varonis notificó el problema a finales de agosto de 2025 y el arreglo formó parte de las actualizaciones del 13 de enero de 2026. Desde el punto de vista de la divulgación responsable, se siguió el patrón habitual: informe privado, análisis, desarrollo del parche y comunicación pública una vez protegidos los usuarios.

Microsoft ha confirmado que la vulnerabilidad asociada al parámetro q en Copilot ya está corregida. Sin embargo, los expertos subrayan que la raíz del problema no es solo una implementación concreta, sino la manera en que los asistentes de IA interpretan las entradas externas, sean textos, documentos o enlaces.

En paralelo a Reprompt, la compañía ha tenido que pronunciarse sobre otros informes de investigadores que señalan problemas de inyección de prompts, bypass de políticas de tipos de archivo y ejecución de comandos dentro del entorno Linux aislado que usa Copilot. En varios de estos casos, Microsoft ha considerado que no se trata de vulnerabilidades “reparables” en el sentido clásico.

Inyecciones de prompts, sandbox y el debate sobre qué es una vulnerabilidad en IA

Más allá de Reprompt, investigadores como el ingeniero de ciberseguridad John Russell han denunciado públicamente que Microsoft ha cerrado varios de sus reportes relativos a Copilot alegando que no cumplen los criterios de mantenibilidad establecidos en su política de vulnerabilidades.

Entre los problemas que Russell dijo haber identificado se encontraban: inyección directa e indirecta de prompts capaz de revelar el prompt del sistema, métodos para saltarse la política de tipos de archivos usando codificación Base64 y la ejecución de comandos en el entorno Linux aislado que utiliza Copilot. Desde su punto de vista, estas conductas muestran debilidades estructurales en las defensas de la plataforma.

Un caso especialmente llamativo es el bypass de la restricción de subida de archivos peligrosos. Copilot bloquea por defecto formatos considerados de riesgo, pero Russell demostró que se puede codificar un archivo problemático en Base64, enviarlo como si fuera texto plano, decodificarlo dentro de la sesión y analizarlo desde ahí, eludiendo las comprobaciones iniciales del tipo de archivo.

Otros profesionales, como Raj Marathe, han recordado demostraciones en las que una inyección prompt oculta dentro de un documento Word subido a Copilot terminaba produciendo comportamientos erráticos e incluso bloqueos del sistema. En estos casos, el modelo trataba contenido que debía ser datos neutrales como si fuesen instrucciones de alto nivel.

En el lado contrario, investigadores como Cameron Criswell argumentan que muchas de estas conductas son simplemente limitaciones intrínsecas de los modelos de lenguaje. Los LLM no distinguen de manera perfecta entre datos e instrucciones, y tratar de impedir por completo que interpreten ciertos textos como órdenes podría destruir gran parte de su utilidad práctica.

El papel del prompt del sistema y la visión de OWASP GenAI

Otro tema clave es la exposición del prompt del sistema, ese conjunto de instrucciones ocultas que define la personalidad y límites de un asistente como Copilot. Algunas investigaciones han demostrado que, mediante inyecciones creativas, es posible forzar al modelo a revelar parte o la totalidad de ese prompt interno.

El proyecto OWASP GenAI, una referencia en seguridad aplicada a IA generativa, adopta una postura matizada: la filtración del prompt del sistema, por sí sola, no siempre constituye una vulnerabilidad grave. El problema aparece cuando ese prompt incluye información sensible, reglas de seguridad concretas, lógica de control de privilegios o detalles que permitan eludir protecciones.

En otras palabras, el riesgo importante surge cuando conocer el prompt del sistema permite a un atacante descubrir cómo burlar restricciones de acceso, provocar escaladas de privilegios o extraer datos confidenciales. Si el prompt solo contiene instrucciones genéricas de comportamiento, su divulgación es molesta, pero no necesariamente crítica.

OWASP también recuerda que, incluso sin acceder literalmente al texto completo del prompt, los atacantes pueden inferir buena parte de las reglas internas simplemente hablando con el sistema y analizando sus respuestas. Por eso, esconder el prompt no debe ser la única capa de seguridad, sino una medida más dentro de una estrategia mucho más amplia.

Microsoft, por su parte, ha explicado que los reportes relacionados con Copilot se evalúan según su política pública de clasificación de vulnerabilidades. Muchos casos se consideran fuera de alcance cuando el impacto se limita al entorno del usuario que hace la solicitud, no cruza barreras de seguridad entre cuentas distintas o solo implica información de bajo privilegio.

Otros problemas prácticos de Copilot: bloqueos de prompts y fallos en la app

Mientras se discuten estas cuestiones de alto nivel en la comunidad de ciberseguridad, los usuarios de a pie se topan con problemas más mundanos pero igual de frustrantes. Uno de ellos es el error que muestra Copilot diciendo “You can’t submit any more prompts”, que impide seguir enviando mensajes.

Desde el soporte oficial de Microsoft se recomiendan pasos clásicos: cerrar sesión y volver a iniciar en la app de Copilot, probar con otro navegador para descartar extensiones o caché problemática, e incluso crear un nuevo perfil de usuario local en el dispositivo si se sospecha que el problema está ligado a la cuenta actual.

También hay usuarios que intentan pegar prompts muy agresivos o complejos para poner a Copilot en supuestos “modos absolutos” o configuraciones extremas, y ahora se encuentran con la respuesta: “no es una configuración compatible, seguiré operando bajo mis instrucciones definidas”. Ese tipo de mensajes reflejan que Microsoft ha endurecido las barreras contra modificaciones radicales del comportamiento base del asistente.

En el terreno del escritorio, la app nativa de Copilot para Windows 11 tampoco se libra de fallos. Es relativamente frecuente que, tras instalarla desde la Microsoft Store, el icono esté presente pero la aplicación simplemente no llegue a abrirse cuando el usuario intenta ejecutarla.

Para este tipo de incidencias, las soluciones recomendadas pasan por: reiniciar Windows para descartar errores transitorios, comprobar la conexión a Internet, utilizar la función de reparar o restablecer la aplicación desde Configuración > Aplicaciones > Aplicaciones instaladas > Microsoft Copilot, ejecutar el solucionador de problemas de la Microsoft Store y, en casos más serios, revisar la integridad de los archivos del sistema con el comando sfc /scannow desde una consola con privilegios de administrador.

Por qué la superficie de ataque de Copilot seguirá creciendo

Un punto en el que prácticamente todos los expertos coinciden es que el problema de fondo no es solo Reprompt, ni un caso concreto de bypass de filtros, sino el modelo mismo de estas herramientas: Copilot es útil precisamente porque “toca cosas”, es decir, porque tiene acceso a datos reales, aplicaciones y servicios conectados.

Cuantas más capacidades se le añaden al asistente (integración con Office, acceso a correo, gestión de archivos en la nube, automatización de tareas en Windows, etc.), más crece la superficie de ataque disponible para un atacante creativo. Cada nuevo flujo de trabajo, cada punto de integración y cada tipo de contenido procesado pueden introducir vías inesperadas de abuso.

Por eso algunos investigadores insisten en que la discusión no puede limitarse a si un comportamiento encaja o no en la definición clásica de vulnerabilidad explotable. La IA generativa tiene una naturaleza probabilística y flexible que no encaja bien en los modelos de seguridad tradicionales basados en perímetros y fronteras rígidas.

Al mismo tiempo, resulta irrelevante aspirar a una IA totalmente estanca: una IA que no pueda acceder a nada y no haga más que repetir texto sin conectarse a servicios externos sería muy segura, pero también prácticamente inútil en entornos productivos. El reto es conseguir un diseño donde cada nueva función vaya acompañada de controles sólidos y un análisis profundo de riesgos.

En este contexto, casos como Reprompt funcionan como avisos tempranos de por dónde pueden ir los próximos ataques. Hoy es un parámetro de URL mal controlado; mañana puede ser un formato de documento con instrucciones embebidas o una API de terceros que introduce su propia cadena de vulnerabilidades.

Lecciones prácticas para usuarios y empresas que utilizan Copilot

Aunque todo esto suene a guerra de expertos, de Reprompt y del debate sobre inyecciones de prompts se pueden sacar varias lecciones muy tangibles para quien usa Copilot a diario, tanto en casa como en la oficina, y quiere minimizar riesgos sin renunciar a la utilidad de la herramienta.

La primera es desarrollar una desconfianza sana hacia los enlaces “inteligentes”. Si recibes un link que abre Copilot, o cualquier otro asistente de IA, con el campo de texto ya relleno con una consulta, conviene mirarlo con lupa, especialmente si el enlace llega por correo, mensajería o redes sociales y no lo esperabas.

La segunda es dejar de pensar en estos asistentes como “simples chats”. Copilot y sus equivalentes son, en realidad, interfaces unificadas hacia un montón de servicios: correo, documentos, almacenamiento en la nube, calendario, herramientas de productividad… Darles acceso indiscriminado equivale, en la práctica, a abrir puertas muy sensibles de tu entorno digital.

La tercera, quizá la más obvia pero también la más ignorada, es mantener siempre Copilot y el sistema operativo completamente actualizados. En el caso concreto de Reprompt, el parche cierra la puerta, pero solo para quienes instalando las últimas versiones de Windows, del navegador, de Office y de la propia aplicación de Copilot.

Por último, tanto para usuarios individuales como para empresas, conviene revisar con calma qué fuentes de datos se comparten con el asistente, qué políticas internas rigen su uso y qué tipo de información jamás debería procesarse a través de estos sistemas, por muy cómodo que resulte delegarles trabajo.

Copilot y herramientas similares seguirán extendiéndose en sistemas operativos, suites ofimáticas y flujos de trabajo críticos, y eso no va a parar. Entender el alcance de fallos como Reprompt, los límites de la seguridad actual en IA generativa y los puntos donde Microsoft y la comunidad de ciberseguridad discrepan ayuda a usar estas herramientas con más cabeza, menos miedo irracional y bastante menos ingenuidad.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.