- KVM ofrece rendimiento cercano al nativo con gestión simplificada vía libvirt y virt‑manager.

- La seguridad y el aislamiento se refuerzan con sVirt, SELinux/AppArmor, VLANs y SR‑IOV.

- Escalabilidad y ahorro: orquestación, migración en vivo y licencias cero.

- Buenas prácticas: virtio, almacenamiento SSD, redes optimizadas y monitorización.

La virtualización en Linux ha madurado hasta el punto de competir de tú a tú con plataformas propietarias, y KVM junto con virt‑manager forman un tándem difícil de batir. Rendimiento casi nativo, licencias cero y herramientas de gestión sólidas convierten a esta combinación en una apuesta ganadora para escritorios, laboratorios y producción.

Si sueles tirar de VirtualBox o VMware Workstation, te interesará saber que KVM actúa como hipervisor de tipo 1 dentro del kernel y saca músculo cuando el hardware acompaña, y elegir la distribución adecuada para virtualización. Con libvirt, virt‑manager, virsh y virt‑install es fácil crear, monitorizar y automatizar máquinas virtuales, ya sea en tu portátil o en un clúster de cloud privado.

¿Qué es KVM y cómo funciona en entornos de virtualización?

En pocas palabras, KVM (Kernel‑based Virtual Machine) transforma el kernel de Linux en un hipervisor de alto rendimiento. Aprovecha las extensiones de virtualización de CPU (Intel VT‑x, AMD‑V) y páginas extendidas (EPT/RVI) para ejecutar sistemas invitados sin modificaciones, con acceso eficiente al hardware.

Definición de KVM (Kernel‑based Virtual Machine)

KVM es un módulo del kernel (kvm.ko) acompañado por controladores específicos de CPU (kvm‑intel.ko o kvm‑amd.ko) que habilitan la virtualización completa por hardware. Al combinarse con QEMU, se obtiene emulación de dispositivos y soporte para múltiples arquitecturas, manteniendo un rendimiento muy cercano al bare‑metal cuando la aceleración está activa.

Arquitectura de KVM en comparación con otras soluciones de virtualización

A diferencia de hipervisores de tipo 2 (p. ej., VirtualBox) que se ejecutan sobre un sistema operativo anfitrión, KVM opera integrado en el kernel. Este enfoque elimina capas intermedias y minimiza la sobrecarga. Frente a soluciones propietarias tipo VMware ESXi o Hyper‑V, KVM brilla por su flexibilidad, apertura del ecosistema y compatibilidad con herramientas estándar como libvirt.

Ventajas clave de KVM para administradores de sistemas

- Eficiencia de recursos: al estar embebido en el kernel reduce la latencia y el overhead; QEMU aporta los dispositivos virtuales que necesites.

- Escalabilidad: puedes crecer en número de VMs y ajustar CPU, memoria y almacenamiento bajo demanda, incluso con migración en vivo entre hosts.

- Compatibilidad: admite multitud de sistemas invitados (Linux, BSD, Windows, etc.) con drivers paravirtualizados (virtio) para red y disco.

- Optimización del hardware: usa VT‑x/AMD‑V y EPT/RVI para acelerar la ejecución de invitados y reducir cambios de contexto.

- Costes: solución de código abierto que evita licencias y facilita personalización profunda.

Beneficios de la virtualización con KVM en entornos de cloud hosting

En escenarios cloud, KVM encaja como un guante gracias a su modelo abierto, rendimiento alto y facilidad de integración con stacks de orquestación y almacenamiento. Es frecuente encontrarlo en nubes privadas y plataformas como OpenStack.

Escalabilidad y flexibilidad en la nube

La combinación KVM+libvirt aporta APIs estables, lo que facilita integrarlo con herramientas de automatización (Ansible, Terraform) y orquestadores. La escalabilidad horizontal y vertical resulta sencilla gracias a la asignación dinámica de recursos.

Costes operativos y de infraestructura

Sin licencias de hipervisor, las organizaciones pueden redirigir presupuesto a hardware y soporte. La consolidación de servidores y la densidad de VMs son altos, reduciendo CAPEX y OPEX, especialmente en nubes privadas.

Rendimiento y optimización de recursos en el cloud

Con virtio para red y almacenamiento, más backends rápidos (SSD/NVMe, Ceph, iSCSI), se alcanzan tiempos de respuesta muy competitivos. La migración en vivo y el pinning de CPU ayudan a equilibrar cargas sin cortes perceptibles.

Seguridad en entornos virtualizados con KVM

La seguridad es prioritaria en cualquier plataforma de virtualización. KVM ofrece un abanico de mecanismos de aislamiento y control, y libvirt añade capas de política y confinamiento que encajan bien con las distribuciones Linux modernas.

Principales desafíos de seguridad en la virtualización

Riesgos frecuentes: escape de VM, superficie de ataque en dispositivos virtuales, tráfico lateral entre invitados y mala segmentación de redes virtuales. Una configuración descuidada de permisos y almacenamiento también puede provocar filtraciones de datos.

Mecanismos de seguridad integrados en KVM

- Virtualización asistida por hardware: Intel VT‑x y AMD‑V facilitan el aislamiento de invitados y limitan el acceso al hardware real.

- Redes virtuales seguras: uso de NAT, bridges y VLANs gestionados por libvirt, además de firewalls en el hipervisor para segmentar tráfico este‑oeste.

- sVirt con SELinux/AppArmor: confinamiento obligatorio de procesos QEMU por VM, reforzando el aislamiento a nivel de sistema.

Mejores prácticas para asegurar sistemas virtualizados con KVM

- Actualizaciones constantes: kernel, KVM, QEMU y libvirt deben mantenerse al día para corregir CVEs rápidamente.

- Cortafuegos y aislamiento: define políticas en el host (iptables‑nft/firewalld) y separa redes por función mediante VLANs/bridges.

- Segmentación por criticidad: agrupa VMs por niveles de riesgo y aplica controles granulares de acceso y movilidad.

Comparación entre KVM y otras tecnologías de virtualización

KVM vs. VMware

VMware destaca por ecosistema maduro, soporte oficial y multitud de herramientas empresariales. KVM aporta apertura, costes reducidos y gran elasticidad con integraciones de terceros. La elección dependerá de requisitos de soporte, presupuesto y estandarización.

KVM vs. Hyper‑V

En entornos Windows, Hyper‑V ofrece integración nativa con el ecosistema Microsoft. KVM es preferible donde Linux es protagonista, donde se busque portabilidad, control y eficiencia de costes.

Casos de uso y recomendaciones para cada plataforma

- KVM: ideal en infraestructuras Linux y cloud hosting, con necesidad de personalización y automatización.

- VMware: óptimo para empresas que valoran soporte premium, funcionalidades avanzadas y suite integrada.

- Hyper‑V: elección natural si predomina Windows Server y servicios Microsoft.

- Xen: recomendado cuando el aislamiento estricto es el criterio dominante.

Configuración y despliegue de KVM en servidores cloud

Requisitos previos para la instalación de KVM

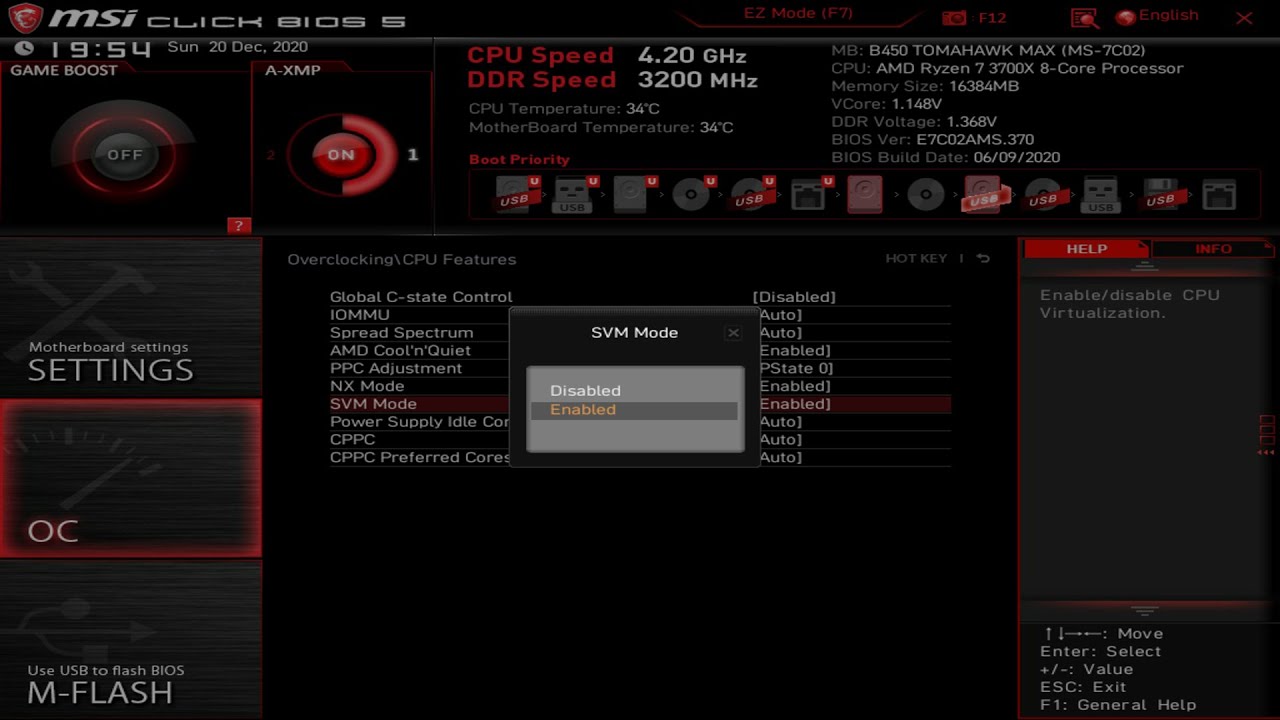

- Soporte de CPU: VT‑x (Intel) o AMD‑V (AMD) habilitado en BIOS/UEFI; recomendable EPT/RVI para mejor rendimiento.

- Sistema operativo Linux: Ubuntu, Debian, Fedora, CentOS/Alma/Rocky, Arch/Manjaro, MX‑Linux, etc. KVM está soportado desde kernel 2.6.20 en adelante.

- Recursos: memoria RAM y almacenamiento acordes al número de VMs; SSD o NVMe mejoran de forma notable las E/S.

Instalación paso a paso (validación de hardware y paquetes)

Antes de instalar, verifica que tu CPU admite virtualización. Si no aparece salida, activa VT‑x/AMD‑V en la BIOS/UEFI (ver cómo activar la virtualización desde la BIOS/UEFI).

egrep -c '(vmx|svm)' /proc/cpuinfo

También puedes usar lscpu para revisar las características de virtualización y confirmar VT‑x o AMD‑V:

LC_ALL=C lscpu

En Debian/Ubuntu, instala el comprobador y valida KVM con kvm‑ok. La salida debe indicar que /dev/kvm existe y que la aceleración puede usarse.

sudo apt update

sudo apt install -y cpu-checker

kvm-ok

Paquetes base en Debian/Ubuntu y derivadas: KVM, libvirt, bridge-utils y virt‑manager.

sudo apt install -y qemu-kvm libvirt-daemon-system libvirt-clients bridge-utils virt-manager

Activa y comprueba libvirtd; añade tu usuario a grupos libvirt y kvm. Reinicia sesión o el sistema para aplicar grupos.

systemctl status libvirtd

sudo usermod -aG libvirt "$USER"

sudo usermod -aG kvm "$USER"

En Arch/Manjaro, instala el set recomendado, incluyendo UEFI (OVMF), DNS para NAT y reglas de firewall basadas en nftables. En Manjaro acepta sustituir iptables por iptables-nft.

sudo pacman -S --needed virt-manager qemu-desktop libvirt edk2-ovmf dnsmasq iptables-nft

sudo pacman -S --asdeps swtpm # TPM virtual

sudo systemctl enable --now libvirtd.service

sudo usermod -a -G libvirt,libvirt-qemu,kvm $USER

systemctl soft-reboot

En MX‑Linux (Debian‑based), tras instalar los paquetes, verifica módulos y redes. Comprueba kvm_intel o kvm_amd con lsmod:

lsmod | grep -i kvm

Gestiona la red virtual por defecto (NAT con virbr0): actívala y configúrala en arranque.

virsh net-start default

virsh net-autostart default

Para acelerar la red huésped, carga vhost_net en el host. No es obligatorio, pero mejora el rendimiento con virtio-net.

sudo modprobe vhost_net

Si necesitas acceso L2 desde la red física, crea un bridge sobre tu NIC. La configuración depende de tu distro y gestor de red; puedes emplear NetworkManager, systemd‑networkd o ifupdown, ajustando IP/DHCP según tu segmento.

Gestión de máquinas virtuales con KVM y libvirt

- Crear VMs: con interfaz gráfica (virt‑manager) o CLI (virt‑install) en minutos; admite ISOs locales y fuentes HTTP/FTP/NFS.

- Almacenamiento y redes: administra pools, volúmenes, bridges y NAT con virsh/libvirt; define virtio‑blk/scsi y modelos de NIC virtio.

- Migración en vivo: mueve invitados entre hosts sin interrupciones para balanceo de carga o mantenimiento.

Administración y monitorización de máquinas virtuales

Herramientas para la administración de entornos virtualizados

El ecosistema libvirt aporta una caja de herramientas completa: virt‑manager (GUI), virsh (CLI), virt‑viewer (consola gráfica vía VNC/SPICE). Todas se apoyan en la API de libvirt y funcionan local o remotamente.

Soluciones de monitorización y optimización del rendimiento

Para métricas en tiempo real, usa virt‑top (similar a top) y complementa con colecciones de métricas del host (htop, iostat) y del invitado. Perfilar I/O, CPU y memoria ayuda a detectar cuellos de botella y ajustar asignaciones.

Automatización y orquestación de máquinas virtuales con KVM

Infra como código con Terraform (proveedor libvirt), cloud‑init para personalización de imágenes y Ansible para el ciclo de vida de VMs son aliados naturales. En clúster, integra migración en vivo y mantenimiento sin cortes.

Virtual Machine Manager (virt‑manager): uso rápido

virt‑manager proporciona una interfaz unificada para crear, configurar y supervisar invitados KVM/QEMU. Incluye snapshots, gestión de redes y acceso VNC/SPICE, además de detalles finos de CPU, memoria y dispositivos.

Pasos esenciales: abre virt‑manager y conecta a QEMU/KVM; pulsa «Nuevo» para iniciar el asistente; elige ISO o instalación por red, asigna RAM/CPU, define disco y red (NAT virbr0 por defecto o bridge); revisa y crea la VM. Si SPICE no rinde bien en tu entorno, usa VNC para la consola gráfica.

Eficiencia de costes al usar KVM en entornos cloud

Modelos de ahorro en infraestructura

- Licencias: el coste de software de virtualización cae a cero con KVM en comparación con suites propietarias.

- Hardware: mayor consolidación por host, aprovechando al máximo CPU, RAM y almacenamiento.

- Implementación: inversión inicial contenida y libertad para diseñar la pila a medida.

Optimización de recursos en la nube con KVM

- Asignación dinámica: ajusta vCPU, RAM y disco según demanda; pinning de CPU y hugepages cuando convenga.

- Consolidación: densidad alta de VMs por host reduce compras y costes de mantenimiento.

- Eficiencia energética: menos hosts y mejor utilización bajan el gasto eléctrico en CPDs y nubes privadas.

Escalabilidad y rendimiento en entornos KVM

Mejores prácticas para la escalabilidad

- Distribución equilibrada: reparte CPU, memoria y almacenamiento; evita oversubscription agresiva sin telemetría.

- Planificación de capacidad: mide tendencias y crece a tiempo; KVM permite ampliar recursos sin grandes sobresaltos.

Aumentando el rendimiento en alta carga

- CPU y memoria dedicadas: pinning de vCPU, NUMA awareness y reserva de memoria mejoran latencia.

- Aceleración por hardware: garantiza VT‑x/AMD‑V activas; habilita virtio en invitados para red y disco.

- Optimización de E/S: almacenamiento SSD/NVMe, colas multihilo y cachés ajustadas (writeback/none) para cargas intensivas.

Almacenamiento y redes optimizadas para KVM en el cloud

En red, reduce latencia con SR‑IOV, vhost_net y VLANs bien segmentadas. Para datos, combina volúmenes rápidos con caching de lectura/escritura y, si procede, Ceph o iSCSI en backends distribuidos.

Solución de problemas comunes en la virtualización con KVM

Problemas de rendimiento y su resolución

- CPU saturada: revisa con htop/virt‑top; ajusta vCPU, activa pinning o redistribuye con migración en vivo.

- Memoria insuficiente: sube RAM asignada, evalúa hugepages/ballooning y evita swapping del host.

- Disco lento: usa SSD/NVMe, controladores virtio‑scsi y caché adecuada; mide con iostat/fio.

Errores comunes en la configuración y cómo solucionarlos

- VMs que no arrancan: revisa logs de libvirt/QEMU en /var/log; valida rutas de discos y firmware OVMF/BIOS.

- Sin red: verifica bridges/NAT en libvirt (virbr0) y que la red «default» esté activa y en autostart.

- Problemas de almacenamiento: comprueba permisos SELinux/AppArmor, pools y volúmenes en virsh/virt‑manager.

Diagnóstico y solución de problemas de red

- Config de red virtual: valida que la VM esté en la red correcta y que el bridge del host tenga conectividad.

- Políticas de firewall: revisa iptables‑nft/firewalld; abre puertos necesarios y evita reglas solapadas.

- Mejora con virtio: usa NIC virtio y, si aplica, SR‑IOV para reducir overhead y latencia.

Futuro de la virtualización con KVM en la nube

Tendencias emergentes en la virtualización y KVM

- Gestión predictiva con IA: modelos que anticipan picos y ajustan recursos automáticamente.

- Convergencia con contenedores: entornos mixtos VM+containers con decisiones inteligentes de colocación.

- Detección proactiva: analítica en tiempo real para prevenir incidencias de rendimiento y seguridad.

El rol de KVM en la evolución del cloud hosting

KVM seguirá siendo pilar de nubes privadas y públicas gracias a su API estable (libvirt), integración con IA y ecosistema creciente. Automatización avanzada reducirá tareas manuales y optimizará costes.

Cómo KVM se adapta a las necesidades de los administradores

La plataforma evoluciona hacia escalado automático, seguridad adaptativa y monitorización predictiva, manteniendo el control fino que aprecia cualquier equipo de SRE/DevOps.

QEMU/KVM, libvirt y conexiones: claves prácticas

QEMU complementa KVM aportando dispositivos y soporte multi‑arquitectura; libvirt simplifica la gestión con una API unificada y estable. Conoce las URIs más útiles para conectar:

- qemu:///session (local no privilegiada): gestión por usuario, sin redes avanzadas.

- qemu:///system (local privilegiada): administración de todo el host, ideal para servidores.

- qemu+ssh://usuario@host/system (remota): controla hipervisores KVM externos de forma segura.

Para invitados, prioriza dispositivos virtio (red y disco). Evita emulaciones genéricas como Realtek 8139 o IDE salvo por compatibilidad, porque consumen más CPU y penalizan E/S.

Virtualización ligera, gráficos y firmware

Si precisas UEFI en tus VMs, instala edk2‑ovmf. Para compatibilidad con Windows 11 u otros escenarios, añade TPM virtual con swtpm. En la consola gráfica, prueba SPICE y, si no rinde bien, cambia a VNC desde virt‑manager.

Maximiza las ventajas de la virtualización con KVM con SysAdminOK

Como ruta formativa, es útil centrarse en metas claras. Aprender a instalar KVM/QEMU, libvirt y virt‑manager; trabajar con la conexión privilegiada a libvirt; e instalar una VM Linux con el asistente gráfico son hitos rápidos y efectivos.

Un pequeño ejercicio práctico puede incluir: validar que virt‑manager está usando qemu:///system, revisar la red «default» y el almacenamiento disponibles, y desplegar un invitado Linux con virtio para red y disco desde una ISO local.

Copias de seguridad y protección de datos

La estrategia de backup es irrenunciable. Hay soluciones que se integran con plataformas basadas en KVM como Proxmox, oVirt, Red Hat Virtualization, Oracle Linux Virtualization Manager o Huawei FusionCompute. Estas herramientas suelen ofrecer deduplicación, compresión, backups incrementales y recuperación granular (a nivel de archivo), además de trabajos programados y opciones en la nube y fuera de sitio. Confirma compatibilidad con tu stack (algunas no soportan «KVM nativo») y aprovecha periodos de prueba para validar rendimiento y RTO/RPO.

Virtual Machine Manager: instalación y flujo de trabajo

En la práctica, el flujo con virt‑manager es muy directo: actualiza tu sistema, instala el paquete, ejecuta la herramienta y conéctate a QEMU/KVM. A partir de ahí, el asistente guía en la elección de medio de instalación, recursos y red.

La gestión posterior es igual de sencilla: inicia/detén VMs, ajusta CPU/RAM, edita discos y redes, y crea snapshots antes de cambios delicados. Gracias a libvirt, puedes alternar sin fricción entre CLI (virsh/virt‑install) y GUI (virt‑manager) según te convenga.

Redes KVM: NAT por defecto y bridges

Por defecto, libvirt crea la red «default» con NAT y el bridge virbr0. Si necesitas que tus VMs sean accesibles directamente desde la LAN, configura un bridge sobre tu NIC física y asígnalo a las VMs. Segmenta por VLAN cuando separes entornos (dev, pre, prod) y documenta el direccionamiento.

Recuerda que puedes activar y poner en autostart la red por defecto fácilmente, y combinarlo con dnsmasq para DHCP/DNS en redes NAT controladas por libvirt.

Consolas, drivers y experiencia de usuario

En invitados Linux y Windows, instala drivers virtio para red y almacenamiento desde el inicio para exprimir el rendimiento. Si SPICE da problemas, cambia a VNC desde «Mostrar detalles» en virt‑manager; cada entorno puede comportarse distinto según la GPU/driver del host.

La conexión gráfica se integra de forma nativa con virt‑viewer y el visor embebido de virt‑manager, facilitando acceso a consola inmediata tras la creación de la VM.

Buenas prácticas de explotación

Establece políticas: nomenclatura coherente de VMs, pools de almacenamiento diferenciados por rendimiento, redes segmentadas, snapshots con caducidad y backups probados. Integra supervisión (alertas de CPU, memoria, I/O) y procesos de mantenimiento con ventanas de cambio y migración en vivo.

Para conexiones remotas seguras a hipervisores, usa qemu+ssh con claves y restringe accesos por grupo (libvirt/libvirt‑qemu) y roles. Controla permisos SELinux/AppArmor y evita ejecutar gestión privilegiada desde cuentas genéricas.

Todo lo anterior demuestra que, con KVM, libvirt y virt‑manager, puedes montar una plataforma sólida, segura y eficiente sin hipotecarte en licencias: desde el portátil del sysadmin hasta un clúster en el CPD, el stack responde, escala y se deja automatizar con elegancia.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.