- La estabilidad de una VM depende del host, el hipervisor y el propio invitado; con HA y buenas prácticas iguala a bare‑metal.

- Virtualiza lo escalable y replicable; reserva bare‑metal para latencias mínimas, GPU intensiva o hardware específico.

- La penalización típica: CPU ~5–8%, RAM ~7–13% y IOPS con mayor caída; el diseño del storage es clave.

- Prueba (sysbench, fio, iperf3), monitoriza (esxtop/vSphere) y afina (CPU/RAM, snapshots, Tools, red) para asegurar rendimiento.

¿Las máquinas virtuales son lo bastante estables para producción? Es una duda recurrente cuando toca decidir entre desplegar servicios en servidores físicos o en entornos virtualizados. La realidad es que la virtualización ha madurado muchísimo y hoy impulsa desde la nube pública hasta el VDI, pero el matiz está en el tipo de carga, los niveles de rendimiento requeridos y las garantías operativas que necesitas.

En los últimos años, los hipervisores, las extensiones de CPU (Intel VT-x/AMD‑V) y las prácticas de administración han reducido la brecha con el bare‑metal hasta niveles asumibles para gran parte de las aplicaciones. Aun así, conviene poner los pies en el suelo: añadir una capa introduce cierta sobrecarga y puede no ser óptimo para cargas extremas o con necesidades de latencia ultrabaja, y si necesitas activarlo consulta activar la virtualización desde la BIOS.

Qué es una máquina virtual y por qué importa su estabilidad

Una VM es, dicho simple, un “equipo lógico” encapsulado en software que se comporta como un ordenador completo: ejecuta un sistema operativo, corre aplicaciones, tiene almacenamiento y red. Todo ello se apoya en un hipervisor que abstrae el hardware del host y reparte recursos entre múltiples huéspedes de forma aislada.

Gracias a este enfoque, la nube y la multi‑tenencia funcionan: un mismo hardware físico sirve a muchos clientes sin interferencias relevantes (si el aislamiento y la gestión de recursos están bien configurados). En el día a día, esto se traduce en elasticidad, snapshots, migraciones en caliente y backups más simples.

Ojo con la terminología: virtualización no es emulación. La emulación simula una arquitectura distinta y tiene un coste de rendimiento mucho mayor. La virtualización, en cambio, aprovecha extensiones del procesador para ejecutar casi a velocidad nativa.

¿Son suficientemente estables para producción?

La evidencia práctica es clara: los VPS y las VMs sostienen gran parte de la producción en la nube. Han alcanzado niveles de fiabilidad muy altos gracias a hipervisores maduros (KVM, VMware, Hyper‑V, Xen), controladores paravirtualizados y orquestación avanzada.

Dicho esto, hay un principio que no cambia: cuantas más capas, más puntos potenciales de fallo. La fiabilidad total de una VM es la combinación de la fiabilidad del host (hardware + SO + configuración) y del hipervisor, sumada a la del propio SO invitado y sus aplicaciones. Un mal parche en el hipervisor puede tumbar VMs aunque el host siga vivo; por contra, con alta disponibilidad, puedes evacuar cargas a otro host ante un fallo físico. Por eso existen soluciones como Shielded VMs en Hyper‑V para aumentar el aislamiento y reducir el impacto de ciertas amenazas.

En entornos bien diseñados, la estabilidad puede igualar —e incluso superar— a la de un único servidor físico, gracias a clustering, HA, live migration y snapshots. La clave está en la arquitectura: redundancia real, buenas prácticas y supervisión.

Cuándo no conviene virtualizar (o conviene hacerlo con cautela)

Virtualizar “porque sí” no siempre suma. Hay casos donde la VM complica y no aporta:

- Dependencias de hardware/dongles o ASICs no soportados por el hipervisor o difíciles de pasar por passthrough. Algunos firewalls o soluciones biométricas requieren chips específicos.

- Rendimiento extremo o latencia mínima (HPC, trading de ultra baja latencia, renderizado crítico), donde cualquier sobrecarga penaliza. Hay hipervisores bare‑metal para misiones críticas, pero son casos muy específicos.

- Restricciones de licencia que prohíben virtualizar o invalidan soporte en VMs. Saltarse esto pasa factura cuando surgen incidencias.

- Plataformas no probadas en virtualización para producción. Mejor no estrenar tú el camino en cargas críticas.

- Riesgos de seguridad por acceso al host. Si alguien con privilegios compromete el anfitrión, puede afectar huéspedes.

- Dependencias fuertes de sincronización horaria. Las VMs deben tener NTP bien configurado en host e invitados para evitar comportamientos erráticos.

- Sistemas muy antiguos o degradados por años de parches, con soporte nulo y rendimiento errático.

- Virtualización anidada útil para laboratorios, pero menos eficiente y fiable en producción generalista.

Y si te mueves en portátil antiguo, añadir una VM resta batería y margen de CPU. La capa intermedia aporta portabilidad y backups sencillos, pero a costa de consumo y complejidad adicional en equipos limitados.

Casos de uso: físico vs virtualización con ejemplos reales

Seleccionar bien el sustrato marca la diferencia. Estas pautas condensan lo que mejor funciona en cada lado, con ejemplos concretos contrastados:

Mejor en servidor físico (bare‑metal)

- Bases de datos transaccionales de alto rendimiento (Oracle, SAP HANA, SQL Server Enterprise): I/O y latencia mandan. En hardware dedicado, SAP HANA sobre HPE Apollo con NVMe puede superar 3M IOPS en un nodo.

- Renderizado/IA y cómputo intensivo con GPU (Blender, AutoCAD, AI/ML): el overhead afecta a la GPU. Un NVIDIA DGX A100 en bare‑metal con TensorFlow rinde hasta ~30% más que en VM equivalente.

- Juegos/streaming en tiempo real (servidores Unreal, codificadores): la latencia es crítica. Un dedicado con AMD Ryzen 7950X maximiza respuesta.

Brilla en virtualización

- Servidores web y microservicios (Nginx, Apache, Kubernetes): escalado y replicación ágiles. Con VMware Tanzu puedes autoscalar en nubes públicas.

- Escritorios virtuales/VDI (Windows 365, Citrix): seguridad y control centralizado. Windows 365 sobre Hyper‑V saca partido al aprovisionamiento bajo demanda.

- Dev/QA y CI/CD (Jenkins, Docker, GitLab Runners): clonado rápido y costes contenidos. Jenkins en Proxmox habilita entornos efímeros automatizados.

Diferencias clave entre servidores físicos y virtualización

Compendio técnico de cómo se comparan ambos enfoques en los factores que más pesan al decidir:

| Factor | Servidor Físico (Bare‑Metal) | Entorno Virtualizado |

| Rendimiento bruto | Máximo, sin capa extra. | Ligera penalización por hipervisor. |

| Flexibilidad | Escalado ligado a hardware nuevo. | Escalado rápido por software. |

| Costes/licencias | Menos licencias si no hay hipervisor. | Hipervisores comerciales encarecen. |

| Gestión de recursos | Uso exclusivo de CPU/RAM/Disco. | Pooling/overcommit entre VMs. |

| Alta disponibilidad | Depende de RAID y redundancia física. | Live migration/HA nativas. Ver importar y exportar máquinas virtuales en Hyper‑V |

| Recuperación | Restauraciones más lentas si no hay réplica. | Snapshots/backups rápidos. |

| Mantenimiento | Posible downtime alto en updates. | VMs migran mientras actualizas host. |

| Aislamiento | Sin vecinos ruidosos. | Riesgo de Noisy Neighbor si se gestiona mal. |

Comparativa de rendimiento: bare‑metal vs VMs

Las pruebas sintéticas y de I/O muestran una brecha pequeña‑moderada entre físico y virtual, con variaciones por hipervisor:

| Prueba | Bare‑Metal | VM sobre KVM (Proxmox) | VM sobre VMware vSphere |

|---|---|---|---|

| CPU (Geekbench 6) | ~9200 puntos | ~8700 puntos (≈‑5%) | ~8500 puntos (≈‑7,5%) |

| RAM (ancho de banda) | ~30 GB/s | ~28 GB/s (≈‑7%) | ~26 GB/s (≈‑13%) |

| Disco (fio, IOPS 4K) | ~1,2M IOPS | ~1,0M IOPS (≈‑17%) | ~0,9M IOPS (≈‑25%) |

Lecturas rápidas: la CPU cae poco, la memoria algo más y el almacenamiento sufre más penalización (sobre todo en ciertas configuraciones de vSphere). Aun así, muchas apps van sobradas en VMs.

Pruebas de estrés: cómo medir si tu VM aguanta

Antes de decidir, conviene medir con pruebas reproducibles sobre el mismo hardware, en bare‑metal y en VM, para contrastar impacto real del hipervisor:

CPU

Con Sysbench puedes estresar el cálculo de primos: valora consistencia y picos.

Comando: sysbench cpu --cpu-max-prime=20000 run

RAM

- Herramientas: memtester, stress‑ng, RAMspeed, AIDA64.

- Objetivo: latencia y throughput de lectura/escritura.

Ejemplo: stress-ng --vm 2 --vm-bytes 75% -t 60s

Almacenamiento

Fio es el estándar de facto para generar patrones realistas de I/O:

Ejemplo: fio --name=randwrite --ioengine=libaio --rw=randwrite --bs=4k --numjobs=4 --size=1G --runtime=60s --group_reporting

Red

- Herramientas: iperf3, netperf, ping para latencia.

- Objetivo: ancho de banda sostenido, jitter y estabilidad.

Prueba rápida: iperf3 -c servidor-remoto -t 30

Ajustes de CPU y memoria que marcan la diferencia

La mayoría de cuellos de botella vienen de dimensionado pobre o sobrecompromiso:

- Sizing: asigna vCPU y RAM en función de la carga real. Evita dar “por si acaso” porque le quitas aire al host y a otras VMs.

- Sobrecompromiso CPU: ratios de 3:1 suelen ser seguros; a 5:1 ya se nota; a 6:1 o más, la cosa se pone fea.

- Memoria: deja RAM suficiente al host para que no swapee. El invitado saturado de RAM tirará de swap y se arrastrará.

- Ballooning: útil para recuperar memoria no usada, pero puede forzar swap en el invitado si aprieta demasiado.

- Power management de CPU: desactiva políticas agresivas de ahorro si ves latencias anómalas.

En ESXi, monitoriza con esxtop (c para CPU, m para memoria, n red, d disco) y vigila la carga media: 1.0 = CPU al 100%, 2.0 = sobrecarga clara. En Workstation/Hyper‑V, usa las herramientas del SO host e invitado para cazatops.

Almacenamiento: SSD, provisión thick y buenas prácticas

El almacenamiento es crítico: usa SSD siempre que puedas. Si no, HDD de 7.2K/10K RPM y, mejor aún, SAS. Evita 5.4K RPM para producción.

En producción, prioriza discos thick eager‑zeroed para escrituras iniciales más rápidas. Mantén espacio libre suficiente en los volúmenes de las VMs y del datastore.

Cuida la salud de controladoras y firmware (HBA), comprueba cables, monitoriza latencias y errores. Valora controladoras RAID de hardware para fiabilidad y rendimiento. Si necesitas migrar discos o formatos, mira cómo convertir discos virtuales entre formatos.

El cifrado introduce overhead; si no es imprescindible para ciertas VMs, evita cifrar su datastore o asume la penalización.

En vSphere, reparte cargas con DRS/Storage DRS y evita demasiadas VMs intensivas en el mismo LUN. En Workstation, no desconectes discos externos con VMs encendidas.

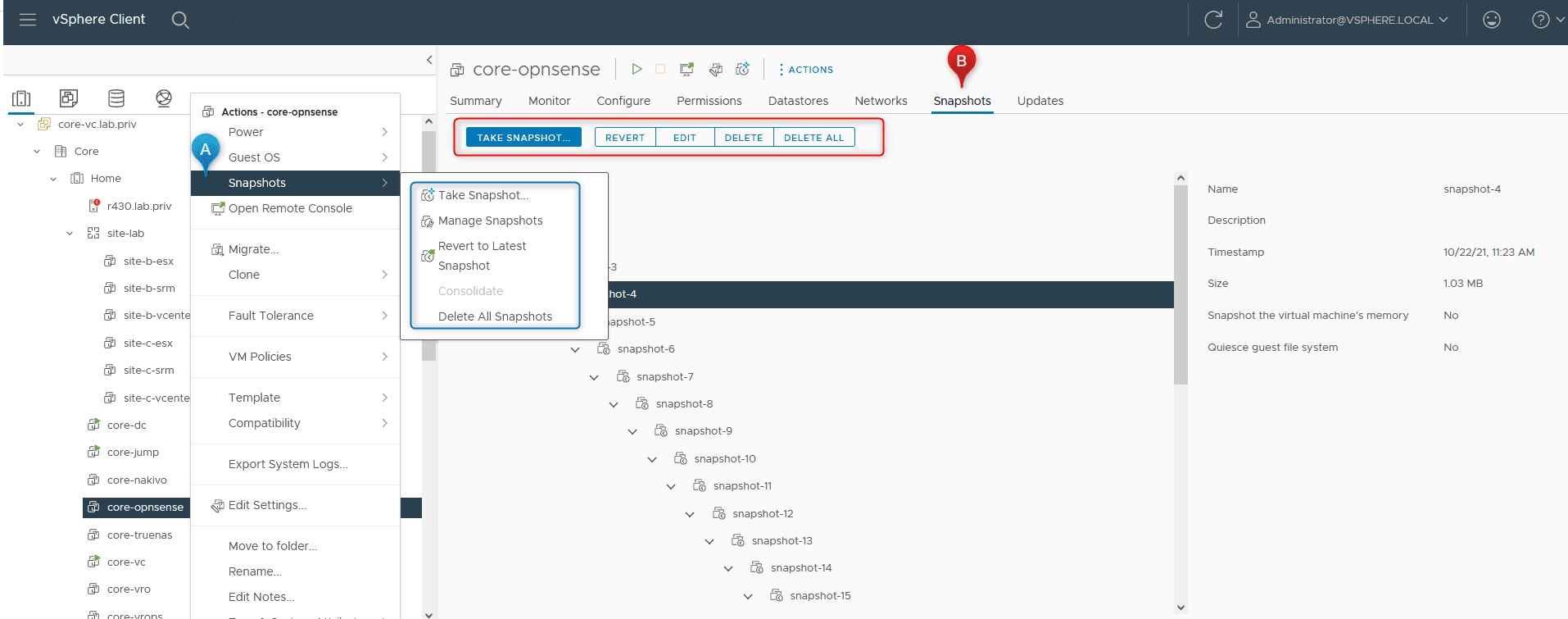

Instantáneas: útiles, pero no las dejes crecer

Cada snapshot añade VMDK delta y multiplica lecturas al tener que consultar padre + deltas. Cuantas más instantáneas y más grandes, peor I/O.

Úsalas de forma temporal (antes de parches o trabajos de backup) y consolídalas pronto. Evita VMDK divididos salvo necesidad extrema de compatibilidad con FS antiguos.

Comandos útiles en ESXi: vmware-cmd path_to_vmx_file removesnapshots o vim-cmd vmsvc/snapshot.removeall VMID (lista con vim-cmd vmsvc/getallvms).

En Workstation (Windows), puedes consolidar con vmware‑vdiskmanager y reconfigurar la VM para usar el nuevo VMDK monolítico.

VMware Tools: drivers y utilidades que suman

Instalar VMware Tools mejora gráficos, ratón y sincronización, y habilita contadores de rendimiento precisos. Comprueba su versión:

- Windows:

"C:\\Archivos de Programa\\VMware\\VMware Tools\\VMwareToolboxCmd.exe" -v - Linux:

vmware-toolbox-cmd -v - ESXi (logs VM):

grep toolbox /vmfs/volumes/datastore/vm_name/vmware.log

En vSphere Client, el estado y versión aparecen en la pestaña Resumen de la VM. No lo dejes pendiente: impacta en experiencia y telemetría.

Red y seguridad: separa planos y evita cuellos

Si usas almacenamiento por red (SAN/NAS), garantiza ancho de banda suficiente y segmentación, por ejemplo revisa tipos de redes en Hyper‑V, VirtualBox y VMware. En vSphere, separa redes de gestión, vMotion y almacenamiento.

Activa NIC Teaming (LAG) para sumar caudal y resiliencia. Cuando toque, sube a 5/10 GbE donde 1 GbE se queda corto.

El antivirus del host no debe escanear archivos VMDK; exclúyelos para evitar caídas de rendimiento. En despliegues grandes, considera soluciones con vShield en lugar de AV en cada invitado, bien configuradas.

Particularidad en Windows: Hyper‑V y Workstation

Desde Workstation 15.5, VMware puede correr con Hyper‑V instalado, pero rinde peor porque VMM de VMware pasa a ULM y usa las APIs WHP de Microsoft, una capa extra.

Si prima el rendimiento de VMs VMware en Windows, desinstala Hyper‑V y VBS. Así VMM accede directamente a VT‑x/AMD‑V en modo privilegiado y recuperas velocidad.

Monitorización: mira el host, no solo el invitado

Un invitado no ve el scheduling del hipervisor, por lo que sus métricas pueden engañar. En vSphere, usa los contadores a nivel de host/VM:

- Supervisión > Rendimiento: Overview/Advanced para CPU, memoria, red y storage en tiempo real y por periodos.

- Utilización: distribución de CPU y memoria de la VM e invitado.

Para Windows invitados, con VMware Tools instaladas, Perfmon puede mostrar contadores específicos de VM. Complementa con esxtop para diagnóstico rápido en consola.

Coste, mantenimiento y eficiencia operativa

La virtualización suele reducir capex y opex al consolidar hardware, bajar consumo y simplificar backups y recuperación. Con un panel web o cliente puedes iniciar, detener, clonar o snapshotear en segundos.

Eso sí, la inversión inicial puede ser relevante para pymes (hosts, almacenamiento compartido, licencias), aunque hay rutas open‑source (Proxmox, XCP-ng) y opciones cloud para empezar poco a poco.

El mantenimiento es menor si hay monitorización y backups bien orquestados, pero el host que alberga muchas VMs se convierte en punto crítico. Evítalo con clústeres, HA y planes de recuperación probados.

La respuesta práctica es que sí, las máquinas virtuales son lo bastante estables para producción en la inmensa mayoría de escenarios habituales (servicios web, microservicios, VDI, entornos de desarrollo y prueba, bases de datos de carga media). Para cargas de latencia ultrabaja o GPU al límite, el bare‑metal sigue mandando; para el resto, la flexibilidad, la alta disponibilidad y la facilidad de recuperación de la virtualización compensan la ligera penalización de rendimiento.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.