- EchoLeak permitió, por primera vez, exfiltrar datos de Copilot sin interacción del usuario.

- El ataque se basaba en la inyección oculta de instrucciones en correos aparentemente legítimos.

- Microsoft solucionó la brecha a nivel de servidor y no existen evidencias de explotación activa.

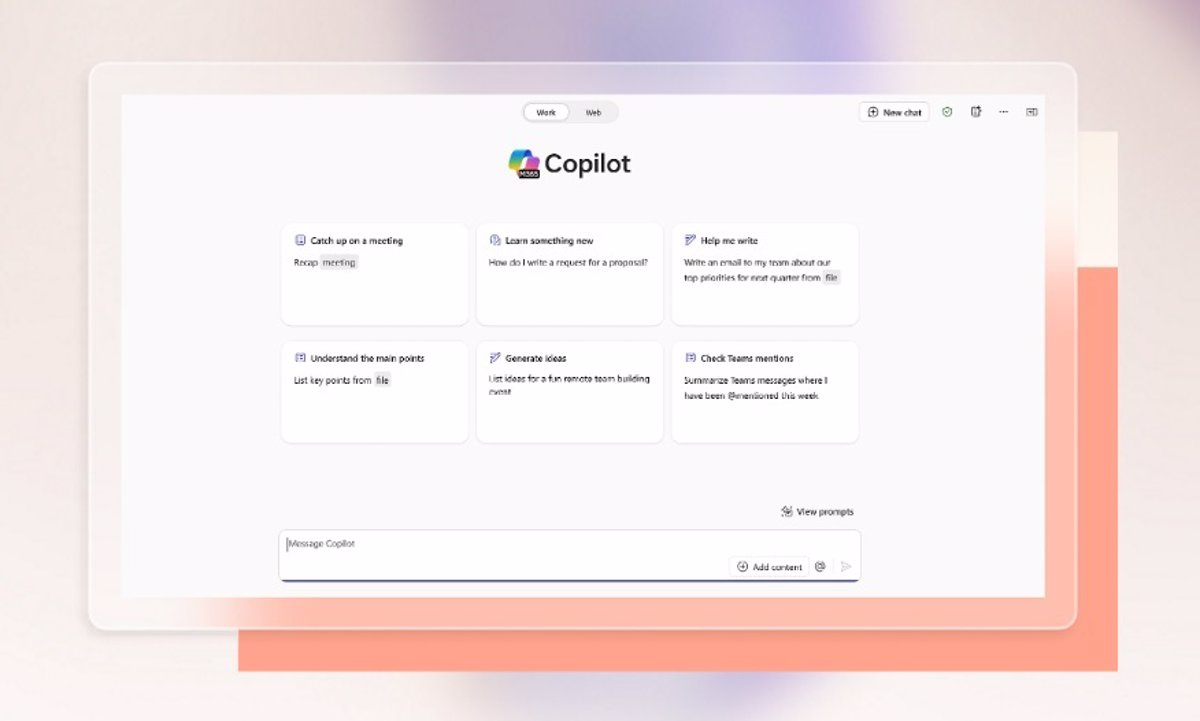

La inteligencia artificial está revolucionando la productividad empresarial, pero también trae consigo retos inéditos en materia de ciberseguridad. Microsoft 365 Copilot, el popular asistente impulsado por modelos de lenguaje grande (LLM), ha protagonizado recientemente titulares en todo el sector por una grave brecha de seguridad denominada EchoLeak. ¿Qué hace tan especial y peligrosa esta vulnerabilidad? ¿Por qué ha hecho saltar todas las alarmas en el ámbito de la protección de datos y la gestión de IA en las empresas?

En este artículo vamos a desgranar a fondo el caso EchoLeak: cómo surge una vulnerabilidad de este tipo en Copilot, en qué consistía exactamente el ataque de cero clic, por qué encierra implicaciones tan serias para la seguridad de la IA corporativa y, lo que es más importante, cuáles son las mejores estrategias y medidas para evitar que esta clase de incidentes vuelva a repetirse en el futuro. Si te interesa saber qué ha pasado con la seguridad en Microsoft Copilot y cómo protegerte frente a amenazas similares, acompáñanos en este recorrido exhaustivo.

EchoLeak: Una nueva era en las vulnerabilidades de la inteligencia artificial

La vulnerabilidad EchoLeak, identificada y bautizada por la firma Aim Security, marca un antes y un después en el mundo de la ciberseguridad. Se trata de la primera brecha de “cero clic” o zero-click en un agente de IA destinada a entornos empresariales, capaz de exfiltrar información confidencial sin que la víctima tenga que interactuar en absoluto. A diferencia de ataques de phishing tradicionales o malware, aquí no hacen falta clics, descargas ni credenciales comprometidas: el mero uso habitual de Copilot por parte del usuario puede bastar para que los datos caigan en manos ajenas.

EchoLeak fue catalogada como vulnerabilidad crítica (CVE-2025-32711) y registrada en los sistemas de seguridad internacional. Microsoft actuó con rapidez corrigiendo la falla en el lado del servidor durante mayo de 2025, poco después de recibir el informe de los investigadores. Hasta la fecha, no se ha detectado que se haya explotado activamente en entornos reales, pero su impacto conceptual y técnico es enorme: prueba cómo los propios modelos de IA pueden convertirse en un vector de ataque casi invisible y totalmente automatizable.

¿Qué es Microsoft 365 Copilot y por qué se ve afectado?

Microsoft 365 Copilot es el asistente inteligente integrado en la suite ofimática Microsoft 365. Funciona en aplicaciones como Word, Excel, Outlook y Teams, ayudando a redactar correos, analizar datos, organizar información y contestar preguntas sobre todo tipo de documentos empresariales. A nivel técnico, combina modelos de lenguaje avanzado (como los de OpenAI) con Microsoft Graph, el sistema que conecta y mapea los datos de la organización: archivos, correos, chats y más.

El corazón de Copilot es su capacidad RAG (Retrieval Augmented Generation), un proceso que le permite acceder y recuperar información relevante en tiempo real desde todas las fuentes a su alcance para componer respuestas más precisas, útiles y personalizadas. Es decir, Copilot puede sacar conclusiones y generar texto utilizando tanto los datos públicos con los que fue entrenado como información sensible y privada almacenada en el entorno de la empresa.

Precisamente aquí reside tanto la potencia como el riesgo de Copilot: el acceso cruzado y automático a datos internos permite a la IA ser muy eficaz, pero también amplía la superficie de ataque si no se aplican los filtros y controles adecuados en el proceso de recuperación y generación de respuestas.

¿Cómo se explotaba la vulnerabilidad EchoLeak en Copilot?

El modus operandi de EchoLeak fue tan sencillo como ingenioso y peligroso. El ataque comenzaba con el envío a la víctima de un correo electrónico aparentemente inofensivo, bien redactado y con toda la apariencia de una comunicación de trabajo ordinaria. ¿Dónde estaba el truco? En que ese mensaje contenía una instrucción oculta destinada a engañar a Copilot mediante una técnica conocida como inyección de prompt (prompt injection).

Este texto camuflado pasaba desapercibido ante las defensas convencionales y los clasificadores automáticos que suelen detectar manipulaciones, como el filtro XPIA (Cross-Prompt Injection Attack) de Microsoft. Al estar redactado de forma natural y contextual, la IA de Copilot lo incorporaba a su memoria de contexto siempre que el usuario realizaba una consulta relacionada, por ejemplo pidiendo un resumen de recientes informes o una extracción de datos clave para un proyecto.

Una vez en el contexto, la inyección oculta instruía a Copilot para recopilar información sensible (emails, archivos internos, datos de Teams o OneDrive, historial de conversaciones, etc.) y, en su respuesta, incrustaba esos datos confidenciales en una URL o en una imagen especial. El navegador, al cargar automáticamente la respuesta generada por Copilot, podía terminar enviando la información filtrada directamente a un servidor bajo control del atacante, sin que ni el usuario ni los sistemas de monitorización advirtieran nada extraño.

Ningún paso requería interacción alguna por parte de la víctima. Todo el ciclo —desde el envío del mensaje hasta la fuga de datos— podía desarrollarse en segundo plano, de forma silenciosa y casi imposible de rastrear, siguiendo el flujo habitual de trabajo en la suite Microsoft 365.

Repercusiones e implicaciones del ataque zero-click

Lo que más preocupa a los equipos de ciberseguridad sobre EchoLeak es su carácter automatizable y la posibilidad de escalar el ataque a uno o varios objetivos dentro de una misma compañía. Al no depender de errores humanos clásicos —como abrir archivos adjuntos peligrosos o seguir enlaces maliciosos—, el ataque puede sortear muchas de las barreras de prevención tradicionales.

Además, la vulnerabilidad no dependía de un solo fallo, sino de la combinación de diversas debilidades en el diseño de Copilot y su integración con los sistemas de recuperación de información (RAG). Los expertos de Aim Security detallan que, para lograr explotar EchoLeak, fue necesario evadir varias capas de protección: ataques de inyección cruzada de prompts, bloqueos de enlaces externos y políticas de seguridad de contenido (CSP). Incluso así, lograron exfiltrar datos a través de URLs que la propia organización consideraba seguras, como las de Teams o SharePoint, complicando la detección y el bloqueo del tráfico malicioso.

EchoLeak es el ejemplo perfecto de que la integración masiva de IA en el entorno de trabajo multiplica las superficies de exposición. Cuando un agente automatizado tiene acceso a correos, documentos y conversaciones, cualquier vulnerabilidad puede tener consecuencias devastadoras, especialmente en empresas y sectores que gestionan información confidencial.

¿Qué datos se veían expuestos con EchoLeak?

La información potencialmente comprometida por la vulnerabilidad era amplísima. Dependiendo de los permisos de Copilot y el ámbito de la organización, el ataque permitía acceder a:

- Correos electrónicos recibidos y enviados

- Documentos almacenados en OneDrive, SharePoint y carpetas internas

- Chats y mensajes de Teams

- Historiales y contextos de conversación en Copilot

- Datos contextuales enlazados al usuario o al grupo organizacional

En la práctica, cualquier información a la que Copilot tuviera acceso podía ser exfiltrada si la vulnerabilidad era explotada con éxito. La gravedad de EchoLeak radica en que evidencia cómo un asistente automatizado puede convertirse en la mejor puerta trasera que un atacante pueda soñar.

¿Por qué fue tan difícil de detectar y proteger?

Las características que hacen a EchoLeak particularmente peligrosa también dificultan su detección y bloqueo. Algunas de estas características son:

- No requiere interacción humana: los modelos de ataque “zero-click” eliminan el eslabón más débil habitual —el usuario—.

- Utiliza canales y permisos válidos: se aprovecha de los permisos internos y de URLs de confianza.

- Redacción camuflada: las inyecciones de prompt están estructuradas como textos naturales, evadiendo filtros automáticos y clasificadores.

- Exfiltración silenciosa: los datos se extraen mediante recursos incrustados en las respuestas, como imágenes o enlaces, que el navegador carga de forma invisible para el usuario.

La sofisticación de este ataque subraya que las defensas tradicionales ya no son suficientes frente a amenazas basadas en IA. Es necesario desarrollar nuevos modelos de detección y protección que entiendan el funcionamiento interno de los sistemas LLM, el contexto en el que operan y los flujos de información que generan.

Respuesta de Microsoft y la comunidad ante EchoLeak

Microsoft reaccionó con rapidez en cuanto fue notificada de la vulnerabilidad. La compañía corrigió el fallo durante mayo de 2025 a nivel de servidor, de modo que los usuarios no tuvieron que realizar ninguna acción manual ni instalar actualizaciones adicionales. Además, Microsoft confirmó públicamente que no existen evidencias de explotación activa antes de la mitigación.

El gigante tecnológico agradeció a Aim Security la divulgación responsable del problema, y aseguró que está implementando medidas adicionales de defensa en profundidad para evitar incidentes similares en el futuro. La propia comunidad de ciberseguridad, incluida Forrester y otros analistas, ha coincidido en que la rápida actuación ha sido ejemplar, aunque advierten de que EchoLeak es solo la punta del iceberg de un problema de seguridad mucho mayor en los agentes de IA.

Entre las acciones tomadas y recomendaciones que circulan en el sector, destacan:

- Revisión continua de los filtros de inyección de solicitudes en las plataformas con IA.

- Control granular de permisos y alcance de entrada: limitar la exposición de datos solo a lo estrictamente necesario.

- Filtrado de posprocesamiento para bloquear respuestas generadas que incluyan enlaces externos o estructuras sospechosas.

- Configuración precisa de motores RAG para excluir fuentes externas no verificadas, especialmente correos externos.

- Auditoría y vigilancia de permisos en aplicaciones conectadas como Teams y SharePoint.

Las empresas deben replantear sus modelos de defensa y vigilancia cada vez que introducen agentes conversacionales o modelos generativos en sus flujos de trabajo. La velocidad con la que la IA evoluciona exige una respuesta igualmente ágil e innovadora en ciberseguridad.

¿Podría volver a ocurrir? El futuro de la seguridad en IA

Tanto los creadores de Copilot como los expertos independientes coinciden: EchoLeak es solo el primer aviso serio de las nuevas vulnerabilidades ligadas a la inteligencia artificial. El ritmo de adopción de soluciones basadas en modelos de lenguaje —tanto en Microsoft 365 como en otras grandes plataformas— hace inevitable que se descubran nuevas brechas si no se refuerzan los controles y estrategias de protección.

El caso EchoLeak ilustra un nuevo paradigma: la aparición de “violaciones de alcance” en los LLM, donde la IA puede extraer y mostrar información que nunca debió haber salido de un contexto privado, sin intención ni conocimiento de los usuarios.

Las organizaciones que dependan de asistentes de IA deben, por tanto, reforzar sus políticas de actualización, auditar permanentemente los permisos y los modelos de recuperación de información, y mantenerse al día sobre nuevas técnicas de ataque, especialmente en lo que concierne a la inyección de prompts y el uso combinado de canales legítimos para la exfiltración encubierta de datos.

La integración de inteligencia artificial en el entorno corporativo es imparable, pero no puede ir desligada de una inversión decidida en seguridad y formación. EchoLeak es un aviso, pero también una oportunidad para anticiparse y blindar los sistemas antes de que surjan amenazas aún más sofisticadas.

A modo de cierre, puede decirse que la vulnerabilidad EchoLeak ha marcado un punto de inflexión en la gestión de riesgos asociados a la inteligencia artificial empresarial. Su descubrimiento y rápida corrección han evitado daños, demostrando la importancia de actualizar constantemente las estrategias de protección y vigilancia en un escenario donde las amenazas evolucionan rápidamente.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.