- V3.2‑Exp estrena DSA: atención dispersa de grano fino para contexto largo.

- Rendimiento comparable a V3.1‑Terminus y costes de API 50% menores.

- Disponible en App, Web y API; licencia MIT y kernels abiertos.

- Soporte day‑0 en vLLM y despliegue sencillo con SGLang y Hugging Face.

En un momento en el que la IA generativa no da tregua, DeepSeek ha movido ficha con un lanzamiento que apunta directamente a la eficiencia y al contexto largo. DeepSeek‑V3.2‑Exp es un modelo experimental que busca validar en producción un cambio de calado: una nueva atención dispersa que promete acelerar el entrenamiento y la inferencia sin empeorar la calidad de salida.

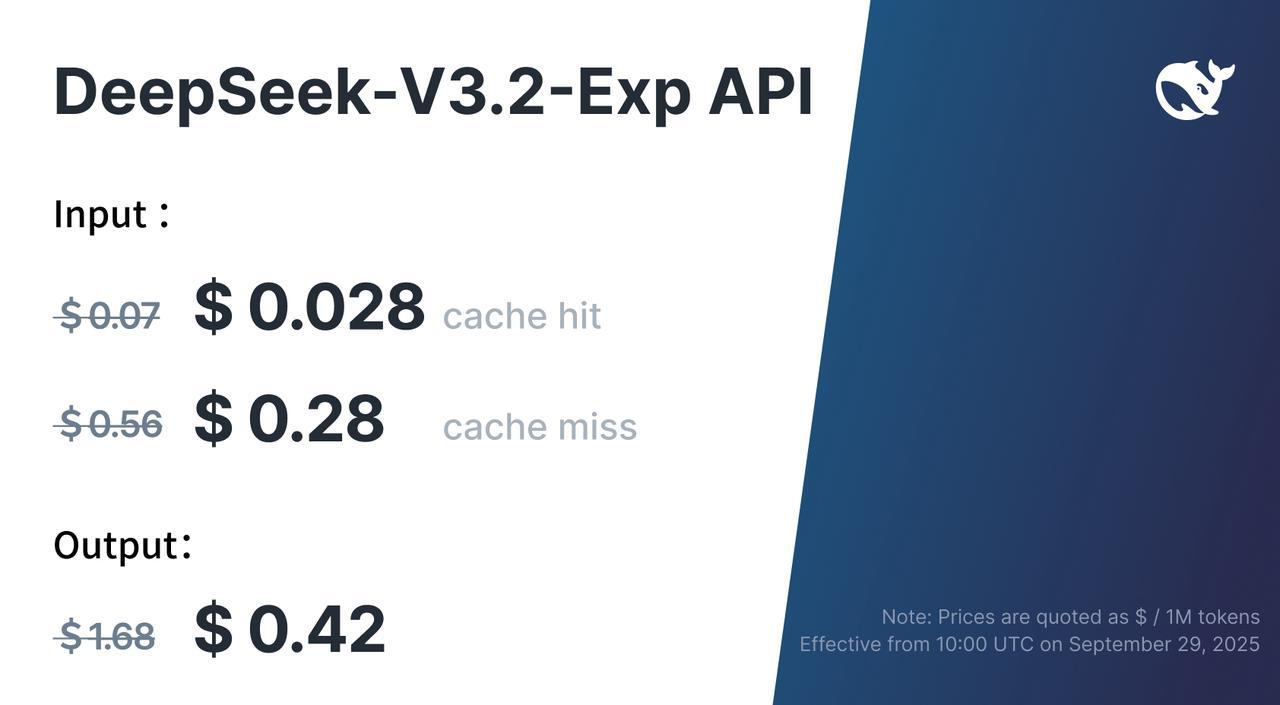

El nuevo modelo no parte de cero; se apoya en V3.1‑Terminus, pero introduce un mecanismo clave llamado DeepSeek Sparse Attention (DSA). Con DSA, DeepSeek afirma recortar costes de cómputo y, de paso, bajar los precios de su API en más del 50% con efecto inmediato, mientras mantiene un rendimiento equiparable al de su predecesor en múltiples tareas.

Qué es DeepSeek‑V3.2‑Exp y por qué importa

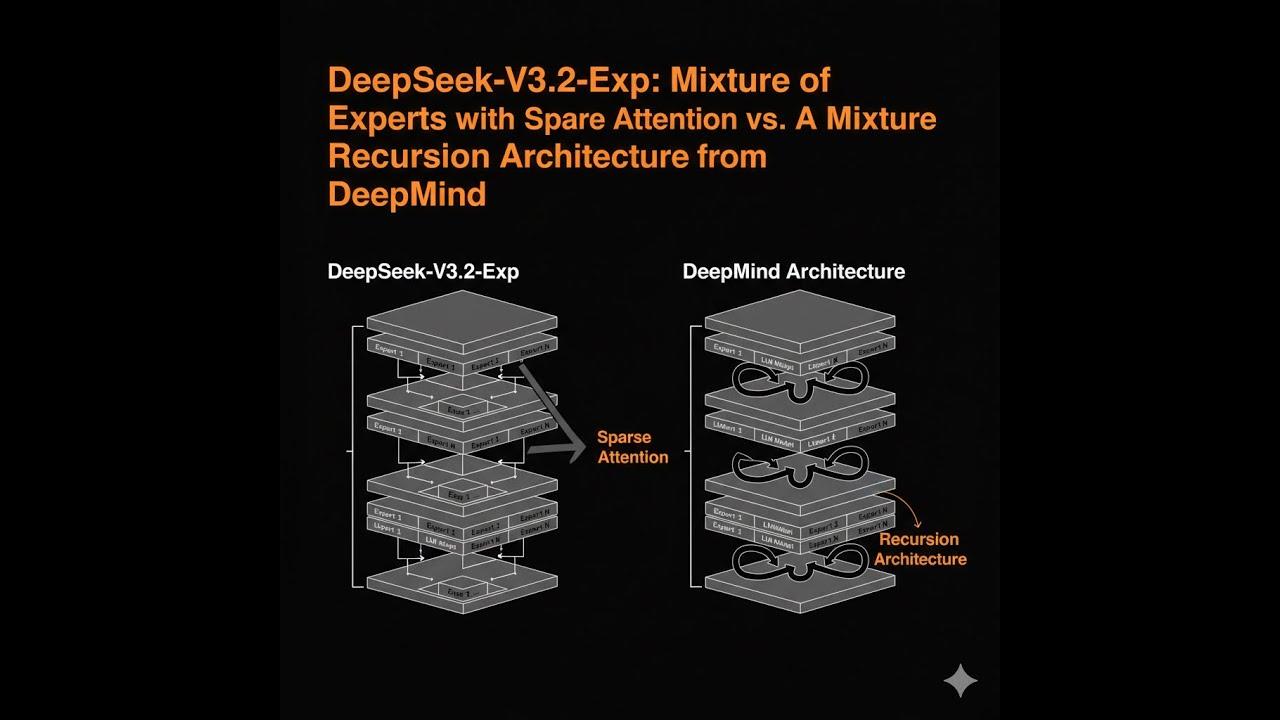

DeepSeek define V3.2‑Exp como un paso intermedio hacia su próxima arquitectura, un escalón diseñado para probar y demostrar optimizaciones concretas de eficiencia en escenarios de contexto largo. Según la compañía, el objetivo es acelerar tanto el entrenamiento como la inferencia al manejar secuencias extensas de texto, donde los transformadores tradicionales suelen disparar el coste.

La clave está en que este lanzamiento es experimental, pero no por ello anecdótico: llega a la app, la web y la API de DeepSeek desde el primer día, abriendo la puerta a que desarrolladores, equipos de datos e investigadores lo pongan a prueba en casos reales con volúmenes de contexto elevados.

En lo técnico, V3.2‑Exp hereda las bases de V3.1‑Terminus para mantener la calidad y facilitar una comparación justa. DeepSeek indica que alineó intencionadamente las configuraciones de entrenamiento con Terminus para medir el impacto real de DSA, y los benchmarks internos muestran resultados a la par en búsqueda, programación y matemáticas.

Más allá de las cifras, el contexto de mercado importa: el anuncio en X destaca que ya está disponible y que la rebaja de precios de la API supera el 50%. El mensaje es claro: si la eficiencia mejora, el coste baja, y eso presiona a rivales en China y fuera, como Qwen de Alibaba u opciones estadounidenses.

Qué introduce DeepSeek Sparse Attention (DSA)

DSA es un mecanismo de atención dispersa de grano fino enfocado en largas ventanas de contexto. En lugar de atender por igual a todos los tokens, prioriza los fragmentos realmente relevantes y reduce trabajo innecesario, manteniendo la calidad de salida prácticamente idéntica.

Para conseguirlo, DeepSeek incorpora un módulo denominado indexador Lightning, cuya función es asignar prioridad a zonas específicas de la ventana de contexto. Este paso es previo a la atención y actúa como filtro inteligente que separa lo esencial de lo accesorio.

Tras esa primera criba, el modelo aplica un proceso de selección de tokens de grano fino. En la práctica, significa que no todos los tokens entran a competir por atención: solo aquellos señalados como más informativos pasan a la ventana de atención dispersa, con lo que se reduce el consumo de memoria y cómputo.

Un efecto colateral positivo es que el sistema puede considerar grandes proporciones de contexto y sostener varias líneas de razonamiento al mismo tiempo, sin saturarse. Esto resulta especialmente útil en flujos largos, análisis de documentos complejos o conversaciones extensas con múltiples hilos.

Cómo funciona: indexador Lightning y selección de tokens

La tubería conceptual que describe DeepSeek se puede simplificar en varias fases encadenadas, cada una con un rol específico para maximizar la eficiencia bajo contextos largos. La optimización se apoya en escoger mejor, no en procesar más.

- Priorización rápida: el indexador Lightning recorre la ventana y destaca fragmentos candidatos con alta relevancia semántica o estructural.

- Refinamiento fino: se ejecuta la selección de tokens de grano fino, que concreta qué tokens pasan realmente al foco de atención dispersa.

- Atención eficiente: la DSA aplica atención solo sobre el subconjunto seleccionado, ahorrando cómputo y memoria frente a la atención densa tradicional.

- Salida comparable: la calidad del modelo se mantiene en la práctica, según las comparativas internas con V3.1‑Terminus.

DeepSeek subraya que esta estrategia no es un truco puntual: la intención es validar y asentar mejoras de eficiencia para su futura arquitectura. En otras palabras, V3.2‑Exp es un campo de pruebas real, pero ya utilizable en producción.

Además, la compañía señala que el enfoque permite al modelo autovalidar ciertos parámetros durante el entrenamiento en escenarios de contexto largo, ajustando dinámicamente el esfuerzo computacional a lo que realmente aporta información.

Rendimiento, benchmarks y coste: 50% menos en la API

Una de las conclusiones más llamativas es que el rendimiento de V3.2‑Exp se sitúa al nivel de V3.1‑Terminus en dominios clave: como agente de búsqueda, en tareas de codificación y en problemas matemáticos. Mantener resultados similares con menos cómputo es lo que habilita la bajada de precios.

DeepSeek anunció que los precios de la API caen más del 50% de forma inmediata gracias a la eficiencia obtenida con DSA. Esta decisión no solo facilita el acceso a la tecnología, sino que encarece la comparación para competidores que deban justificar costes de uso superiores.

En términos de experiencia práctica, la mejora se nota especialmente en escenarios de contexto largo: análisis de datos extensos, procesamiento de documentos legales o técnicos, back‑office con historiales prolongados, y cualquier pipeline que dependa de secuencias de texto muy largas.

La hipótesis de DeepSeek es nítida: si el modelo puede atender de forma selectiva a lo relevante, la organización puede manejar más trabajo con la misma infraestructura, o la misma carga con menos coste, sin perder fiabilidad en la salida.

Disponibilidad, apertura del código y licencia

V3.2‑Exp está disponible en la aplicación, la versión web y la API de DeepSeek. El modelo se publica en abierto para que cualquiera pueda evaluarlo, y se acompaña de una licencia MIT para el repositorio y los pesos, lo que favorece la investigación y la adopción comercial.

Esta apertura contrasta con enfoques más cerrados, y democratiza el acceso a capacidades avanzadas. También refuerza el papel de China en la carrera de la IA al facilitar que universidades, startups y empresas locales e internacionales aprovechen y modifiquen el stack.

La compañía recalca el carácter experimental del lanzamiento: sirve de adelanto de lo que puede venir en su arquitectura de próxima generación. Aun así, su publicación estable en los tres canales principales indica un nivel de madurez suficiente para el uso real.

Enlaces de referencia: repositorio y documentación técnica en GitHub, modelo en Hugging Face y contacto de soporte en service@deepseek.com. Todo el paquete busca facilitar la adopción por parte de la comunidad.

Guía rápida para ejecutarlo en local

DeepSeek brinda una demo de inferencia actualizada con el objetivo de acelerar el arranque y permitir que la comunidad entienda la arquitectura. El flujo con Hugging Face y conversión de pesos es directo y contempla el paralelismo de modelo según tus GPUs.

cd inference

export EXPERTS=256

python convert.py --hf-ckpt-path ${HF_CKPT_PATH} --save-path ${SAVE_PATH} --n-experts ${EXPERTS} --model-parallel ${MP}

export CONFIG=config_671B_v3.2.json

torchrun --nproc-per-node ${MP} generate.py --ckpt-path ${SAVE_PATH} --config ${CONFIG} --interactive

Para quienes prefieran servir el modelo con SGLang, hay imágenes Docker listas para distintas arquitecturas. Las etiquetas cubren GPU NVIDIA, ROCm y NPUs, incluyendo variantes específicas.

# H200

docker pull lmsysorg/sglang:dsv32

# MI350 (ROCm)

docker pull lmsysorg/sglang:dsv32-rocm

# NPUs

docker pull lmsysorg/sglang:dsv32-a2

docker pull lmsysorg/sglang:dsv32-a3

# Lanzar servidor

python -m sglang.launch_server --model deepseek-ai/DeepSeek-V3.2-Exp --tp 8 --dp 8 --page-size 64

Si usas vLLM, el proyecto anuncia soporte day‑0 para V3.2‑Exp. Revisa sus recetas oficiales para detalles al día sobre configuración, paginación de KV y parámetros de rendimiento.

En todos los casos, es recomendable ajustar MP al número de GPUs disponibles y monitorizar el consumo real de memoria. Así se obtiene un equilibrio óptimo entre latencia, throughput y coste por petición.

Kernels abiertos y soporte en el ecosistema

DeepSeek ha liberado múltiples piezas que facilitan la investigación y el rendimiento en producción. Para quienes priorizan la legibilidad y el diseño con fines de investigación, recomienda TileLang como punto de partida.

En rendimiento puro con CUDA, los indexer logit kernels (incluidas variantes paginadas) están disponibles en DeepGEMM. Por su parte, los kernels de atención dispersa se han publicado en FlashMLA, orientados a exprimir al máximo la eficiencia en GPUs modernas.

Este enfoque modular permite combinar componentes según la necesidad: legibilidad para prototipado y docencia, o kernels de alto rendimiento para inferencia exigente bajo cargas reales. Es justo lo que uno necesita para migrar de pruebas a producción sin rehacer todo el pipeline.

Además, la publicación de estos kernels con énfasis en el largo contexto complementa el impulso de DSA, cerrando el círculo entre investigación aplicada, benchmark y despliegue real.

Impacto estratégico y lo que viene

Que un modelo experimental llegue a App, Web y API con rebaja inmediata de precios es una declaración de intenciones. DeepSeek no solo explora una línea de investigación; la aterriza en producto y traslada el ahorro al usuario final.

El movimiento añade presión a competidores del ecosistema chino, como Qwen de Alibaba, y a homólogos estadounidenses. Si el rendimiento se mantiene al nivel de alternativas más caras, el factor precio puede inclinar balanzas en sectores sensibles al coste.

Otra derivada es el efecto código abierto: licencias permisivas, kernels públicos y soporte amplio aceleran la adopción y facilitan auditoría, aprendizaje y contribuciones. Es un contraste frente a modelos cerrados, y abre puertas para que pymes y laboratorios universitarios se suban al carro.

A nivel de narrativa, es interesante cómo DeepSeek encuadra V3.2‑Exp como un vistazo al futuro: se validan mecanismos de atención dispersa de grano fino y se coteja su impacto manteniendo constante el resto de factores. Este rigor comparativo le da credibilidad a los resultados.

También es relevante el ángulo de múltiples líneas de pensamiento simultáneas. Poder sostener varias cadenas de razonamiento sin disparar el coste abre oportunidades en agentes complejos, razonamiento de varios pasos y sistemas que combinan búsqueda, síntesis y verificación.

Referencias, citación y contacto

Para quienes quieran profundizar, DeepSeek enlaza al modelo en Hugging Face y a un informe técnico en GitHub. Además, comparte un bloque de citación en formato BibTeX y un correo de contacto para soporte y dudas.

@misc{deepseekai2024deepseekv32,

title={DeepSeek-V3.2-Exp: Boosting Long-Context Efficiency with DeepSeek Sparse Attention},

author={DeepSeek-AI},

year={2025}

}

El canal de X de la compañía resumió el anuncio: presentación de DeepSeek‑V3.2‑Exp, disponibilidad en App, Web y API, con una bajada de precios de la API superior al 50%. El foco vuelve a estar en el largo contexto y la eficiencia de extremo a extremo.

En paralelo, medios tecnológicos recogieron el lanzamiento situándolo como un movimiento relevante tras el impacto de V3 y R1, y apuntando a que, si consolida su promesa, elevará la competencia en calidad‑precio frente a grandes actores del sector.

Para cerrar el círculo, conviene recordar el marco temporal reciente: desde el despegue de ChatGPT en 2022 hasta hoy, la IA generativa ha evolucionado a un ritmo inusitado. V3.2‑Exp encaja en esa tendencia: más contexto, menos coste y una arquitectura que aprende de sus propios experimentos.

V3.2‑Exp se posiciona como una opción a considerar para proyectos que necesitan contextos extensos, rapidez y control de costes. Su planteamiento de atención dispersa de grano fino, el soporte del ecosistema (vLLM, SGLang, kernels abiertos) y la licencia MIT hacen que resulte especialmente atractivo tanto para investigación aplicada como para despliegues empresariales donde cada milisegundo y cada euro cuentan.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.