- La órbita ofrece energía solar 24/7 y refrigeración por vacío para reducir consumo y agua.

- El reto de un gigavatio orbital exige bajar costes de lanzamiento y resolver mantenimiento y radiación.

- Alternativas en tierra: centros submarinos, IA más eficiente y campus junto a renovables 24/7.

- La expansión requiere alianzas con utilities, BESS, microrredes y nuevos marcos regulatorios.

La revolución de la inteligencia artificial ha traído avances que hace nada parecían ciencia ficción, pero también un peaje energético colosal. Los centros de datos que entrenan y ejecutan modelos generan una demanda eléctrica y de refrigeración que crece sin parar, poniendo contra las cuerdas redes y territorios. En ese contexto ha cobrado fuerza una idea que hace pocos años sonaba extravagante: llevar la computación a la órbita para aprovechar energía solar continua y un entorno ultrafrío.

No es una ocurrencia aislada. Desde trabajos académicos a propuestas industriales, pasando por pilotos de nueva generación, el sector explora alternativas con un objetivo común: aliviar el estrés energético y reducir el impacto ambiental de la IA. Mientras algunos miran al espacio, otros desplazan el hardware al fondo del mar o rediseñan software y chips para consumir muchísimo menos.

Por qué mirar al espacio para la computación de la IA

El espacio ofrece atributos únicos: nada de nubes, ni noches, ni atmósfera que atenúe la radiación. Eso se traduce en solar 24/7 con una disponibilidad y estabilidad imposibles en tierra. Además, en vacío y temperaturas extremas, el calor se disipa mediante radiadores con mayor eficacia que con sistemas tradicionales, reduciendo drásticamente la dependencia de miles de millones de litros de agua que hoy se usan para enfriar servidores.

Otra ventaja es el impacto en superficie. Reubicar capacidad de cómputo en órbita elimina la presión sobre suelos, acuíferos y comunidades cercanas a grandes campus. Para ciudades-estado o países de territorio limitado, como Singapur, resulta especialmente atractivo liberar espacio crítico sin renunciar a la expansión de la infraestructura digital.

En términos de sostenibilidad, un centro de datos orbital puede aspirar a ser neutro en carbono si su energía, refrigeración y operaciones están diseñadas para minimizar emisiones. Esa promesa ha acelerado el debate, justo cuando la IA amenaza con disparar el consumo eléctrico del sector muy por encima del ya abultado 3% global asociado a los centros de datos.

Más allá de lo energético, el espacio invita a repensar la arquitectura de sistemas. Con radiación y eventos solares extremos, latencias y mantenimiento distintos, es probable que veamos topologías y protocolos específicos para entornos orbitales, así como nuevas cadenas logísticas y de servicio.

La propuesta académica desde Singapur

Investigadores de la Universidad Tecnológica de Nanyang han puesto números y metodología a esta visión en Nature Electronics. Su trabajo plantea trasladar centros de datos a la órbita baja como vía para autoabastecerse con energía solar continua y aprovechar el entorno para refrigerar de forma natural. La idea, además, abre una salida a países con escasez de suelo, donde levantar nuevos campus supone tensiones urbanísticas, hídricas o logísticas.

El equipo defiende que el espacio puede convertirse en una fuente de recursos para el progreso si se adopta con rigor: más IA, menos emisiones y menor presión sobre recursos finitos de la Tierra. Dicho de otra forma, computación escalable sin estrangular el planeta. Eso sí, reconocen los grandes retos: basura espacial, riesgos de lanzamiento, mantenimiento remoto y una regulación que todavía no está al día.

La visión de la industria: de Bezos a la órbita

Desde el lado empresarial, Jeff Bezos ha situado el debate en la agenda: prevé centros de datos a escala de gigavatio orbitando la Tierra en un horizonte de entre diez y veinte años. Su tesis es que, con energía solar ininterrumpida y sin meteorología adversa, esos clústeres de entrenamiento de IA podrían ser no solo más eficientes, sino más competitivos en coste frente a instalaciones terrestres a medida que maduren las tecnologías de lanzamiento y producción orbital.

El fundador de Amazon hace un paralelismo con el ciclo de las puntocom: puede haber excesos y burbujas de mercado, pero el vector tecnológico subyacente seguirá adelante. De ahí su llamamiento a mantener un optimismo prudente respecto al impacto social positivo de la IA, distinguiendo ruido financiero de avances reales.

El reto ingenieril y económico de un gigavatio

Construir un centro de datos orbital de 1 GW es una empresa titánica. Estimaciones técnicas apuntan a que harían falta entre 2,4 y 3,3 millones de m² de paneles solares, con un peso solo en material fotovoltaico de entre 9.000 y 11.250 toneladas métricas. Llevar esa masa al espacio, con la tecnología actual, exigiría más de 150 lanzamientos y un presupuesto que oscilaría en el rango de 13.700 a 25.000 millones de dólares.

A esa logística se suman la complejidad del mantenimiento, la gestión de actualizaciones de hardware y software, y riesgos inherentes de cada lanzamiento. Al mismo tiempo, surgen preguntas sobre protocolos de seguridad, redundancias y planes de contingencia ante fallos, cuyo diseño debe ser extremadamente robusto para evitar interrupciones catastróficas.

También hay que considerar la dinámica orbital y la cohabitación con constelaciones comerciales y proyectos de comunicaciones espaciales. Más satélites implican mayor riesgo de colisiones y fragmentación, por lo que el diseño de estaciones de cómputo espaciales tendrá que integrar capas avanzadas de mitigación de basura espacial, maniobrabilidad y coordinación internacional.

Pilotos y startups: Starcloud y el apoyo de NVIDIA

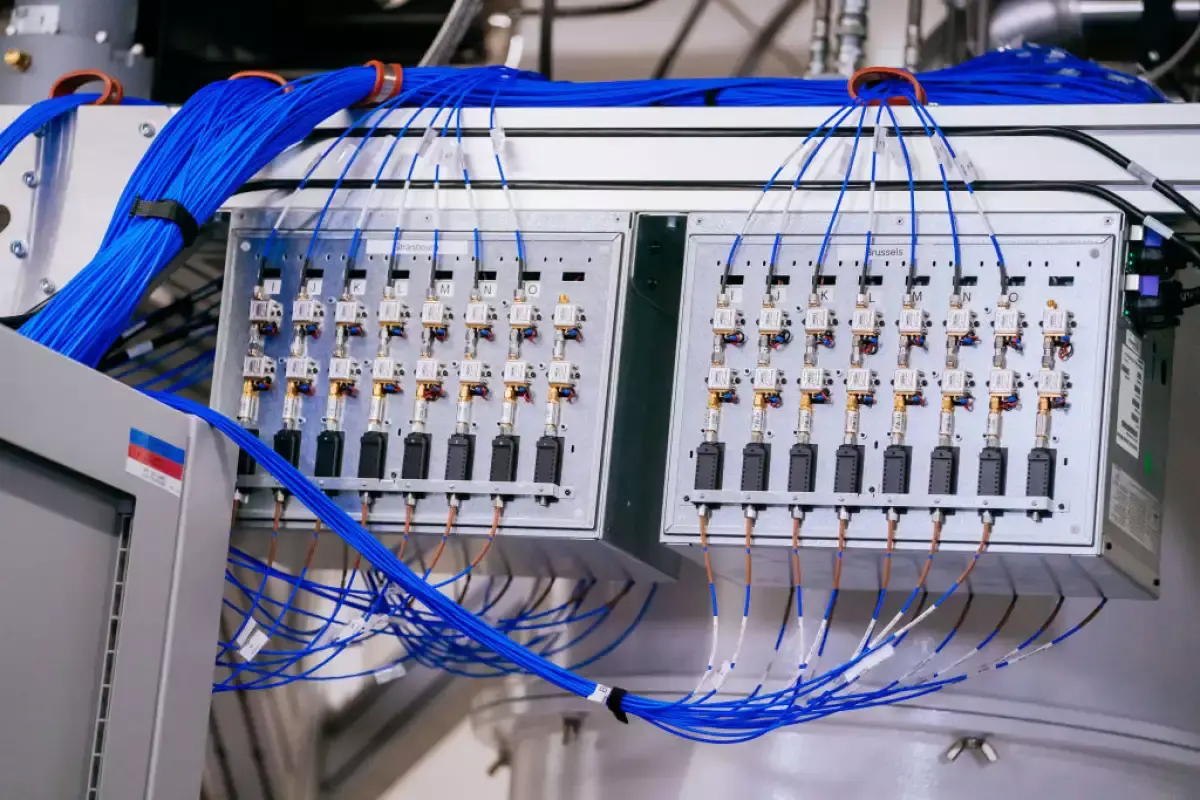

Mientras la visión a gran escala toma forma, llegan los primeros pasos. Starcloud, con apoyo directo de NVIDIA, prepara el lanzamiento de Starcloud‑1, un satélite que integrará una GPU NVIDIA H100 como experimento de centro de datos en órbita. El plan se apoya en dos pilares: emplazamiento en órbitas con sol casi constante para maximizar la producción fotovoltaica y radiadores que expulsan el calor al vacío, reduciendo drásticamente la necesidad de agua.

Para que el modelo escale, el coste por kilogramo en órbita debe caer en picado. La reutilización de cohetes promete abaratar lanzamientos, pero aún es necesario un salto adicional. Por otra parte, la radiación espacial plantea un desafío nada menor: los chips convencionales no están preparados para un entorno con eventos solares extremos, y la protección implica blindajes que añaden peso y, por tanto, coste.

Riesgos adicionales: basura espacial, mantenimiento y regulación

El ritmo de despliegue de constelaciones de comunicación y observación multiplica los objetos en órbita y eleva el riesgo de incidentes. En ese escenario, cualquier infraestructura de cómputo deberá ser autosuficiente, maniobrable y monitorizada de forma permanente. A ello se suma la necesidad de marcos regulatorios que armonicen licencias, espectro, seguridad y responsabilidad ante accidentes.

Mantener servidores a cientos de kilómetros sobre nuestras cabezas obliga, además, a repensar el ciclo de vida del hardware. Sustituciones, parches y ampliaciones deben planificarse con mucha antelación o resolverse con robótica. Y aunque la latencia no es crítica para entrenamientos masivos, sí puede serlo para algunos servicios interactivos, lo que empuja hacia un modelo híbrido con distintas layers de cómputo.

Alternativas de enfriamiento y ubicación en la Tierra

La carrera por la eficiencia también se libra bajo el agua. Frente a Shanghái, China ha comenzado a desplegar cápsulas sumergibles con el primer centro de datos comercial submarino del mundo, desarrollado por Highlander junto a empresas estatales. Las corrientes oceánicas mantienen los servidores en temperatura óptima, eliminando la refrigeración por aire o evaporativa y recortando hasta un 90% el consumo energético asociado al frío.

Este sistema obtendrá más del 95% de su electricidad de parques eólicos marinos cercanos, reforzando su perfil renovable. No obstante, construir un centro submarino ha implicado desafíos nada triviales: desde proteger equipos de la corrosión salina con revestimientos con escamas de vidrio hasta diseñar accesos para mantenimiento mediante un ascensor que conecta el módulo a superficie.

Los retos no acaban ahí. Tender conectividad fiable desde el fondo del mar a tierra firme es complejo, y estas instalaciones podrían ser vulnerables a ataques a través de ondas sonoras que viajan por el agua. Microsoft ya ensayó cápsulas de menor escala en Escocia en 2018 con resultados prometedores, aunque no llegó a comercializarlas.

Al tiempo que China avanza con centros submarinos, en Estados Unidos y Europa se exploran soluciones intermedias en superficie: ubicar campus en climas fríos, en barcos o junto a grandes polos renovables, con diseños que minimizan pérdidas por transmisión y mejoran la huella de carbono.

Europa, China y EEUU mueven ficha

Más allá de los pilotos, varios países trabajan ya en constelaciones de computación. China ha puesto en marcha la Constelación de Computación Tres Cuerpos para validar un superordenador de IA en órbita. En Europa, el programa ASCEND estudia viabilidad, pero sus números dependen de que megacohetes como Starship reduzcan radicalmente el coste de lanzamiento. En EEUU, incluso se ha vinculado a líderes del sector con movimientos para acelerar el acceso a lanzadores y capacidades orbitales.

A escala nacional, regiones como España están preparando su infraestructura para absorber la demanda de IA en los próximos años, reforzando redes y agilizando autorizaciones para nuevos campus. La foto global es nítida: la capacidad de cómputo seguirá creciendo y habrá que repartirla entre tierra, mar y espacio con criterios de coste, sostenibilidad y resiliencia.

Hacer la IA más frugal

No todo pasa por mover servidores: también se trata de consumir menos. Modelos como DeepSeek ilustran cómo el afinado de algoritmos y arquitecturas puede recortar casi a la mitad la energía respecto a soluciones de referencia, manteniendo un rendimiento competitivo. En paralelo, líneas como redes de picos (spiking) —como SpikingBrain 1.0— imitan el comportamiento del cerebro para activar cómputo únicamente ante estímulos, reduciendo datos y ciclos de procesamiento.

Si esa tendencia se consolida, el crecimiento del consumo energético de la IA podría desacoplarse del tamaño de los modelos. En otras palabras, más capacidad no tendría por qué significar una curva eléctrica desbocada, siempre que hardware y software evolucionen en clave de eficiencia.

Cómo optimizar los centros de datos actuales: el caso Google

La gran tecnología también mueve ficha en tierra. Google fue pionera en neutralidad de carbono en 2007 y alcanzó en 2017 un consumo anual 100% renovable. Ahora persigue un objetivo más ambicioso: operar con energía libre de carbono 24/7, garantizada hora a hora. Para ello combina pronósticos, almacenamiento, gestión de demanda y contratos de compra a largo plazo que han impulsado nueva capacidad renovable en varios continentes.

En eficiencia, la compañía asegura que sus centros consumen un 50% menos que la media del sector, apoyándose en su estrategia de las cuatro M: modelos más eficientes, máquinas especializadas, mecanización de procesos y mapeo inteligente de ubicaciones con mejor acceso a energía limpia. Además, planea campus junto a parques eólicos y solares —en colaboración con Intersect Power y TPG Rise Climate— por valor de 20.000 millones de dólares, con finalización prevista a medio plazo.

El despliegue no está exento de retos. Zonas como Data Center Alley, en Virginia, sufren limitaciones de espacio, presión sobre redes y calidad del aire. De ahí que la planificación territorial y energética sea crucial, equilibrando latencia, mano de obra, agua disponible y capacidad eléctrica.

Como apuesta de fondo, Google también explora pequeños reactores modulares (SMR) con socios como Kairos Power para aportar unos 500 MW libres de emisiones a partir de 2030. Este tipo de soluciones despachables pueden sostener cargas nocturnas o suministrar en regiones con menor recurso renovable, reforzando la resiliencia del suministro.

Redes al límite: planificación energética y alianzas

En EMEA y otras regiones, la narrativa de que nos quedaremos sin energía es exagerada, pero sí existe una tormenta perfecta: modernización lenta de redes, colas de conexión de 3 a 5 años, retirada de plantas fósiles y entrada de renovables intermitentes, todo a la vez. La solución pasa por colaborar con las utilities desde el diseño del sitio, cofinanciar refuerzos y planificar la operación con flexibilidad de carga.

El sector se está organizando para ello. El EPRI ha lanzado DCFlex, una iniciativa para probar flexibilidad real en centros de datos y mejorar la fiabilidad de la red. Participan, entre otros, Compass Datacenters, Constellation Energy, Duke Energy, ERCOT, Google, Meta, New York Power Authority, NRG, NVIDIA, PG&E, PJM, Portland General Electric, QTS, Southern Company y Vistra, con el objetivo de crear arquitecturas de referencia y aprendizajes compartidos.

En ubicaciones con capacidad limitada, muchos operadores ya adoptan estrategias BYOP (Bring Your Own Power). Si existe conexión pero se exige respuesta obligatoria a la demanda, los sistemas de almacenamiento con baterías de ion‑litio (BESS) permiten recortar picos, participar en mercados y reducir dependencia de diésel. Donde no hay capacidad disponible, entran en juego turbinas de gas natural como generación firme o celdas de combustible con menores emisiones, combinadas con renovables in situ y almacenamiento.

Surge además un modelo de parques industriales energéticos de 300 a 600 MW que integran renovables, generación de base y microrredes, con posibilidad de operar aislados o conectados a red. Este enfoque puede evitar colas de interconexión y ofrecer energía como servicio a campus de gran tamaño.

La selección del emplazamiento vuelve a ser clave: disponibilidad de energía y agua, espacio, permisos, latencia y mano de obra. En áreas densas, el escrutinio social por ruido de generadores, emisiones o uso del agua obliga a diseñar con sostenibilidad y aceptación pública como requisitos de partida.

Mientras tanto, sobre la órbita pesan condiciones claras para despegar de verdad: abaratar lanzamientos con cohetes reutilizables de nueva generación, estandarizar módulos orbitales, asegurar cadenas logísticas y cerrar la brecha regulatoria. Si esas piezas encajan, la promesa de computación espacial a gran escala pasará de hipótesis a infraestructura crítica del siglo XXI.

La IA empuja hacia nuevas fronteras: centros en órbita con solar perpetua, cápsulas submarinas que ahorran casi todo el frío, software y chips más frugales, y alianzas con utilities para exprimir redes al máximo sin romperlas. Entre lo visionario y lo pragmático, el camino que se está trazando busca que el crecimiento digital no choque con los límites del planeta, sino que se apoye en energía limpia, eficiencia y diseño inteligente.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.