- La IA maliciosa amplifica fraudes, suplantaciones y malware con texto, voz y vídeo falsos.

- Ejemplos históricos (Brain, LoveLetter, Zeus, WannaCry) explican la evolución hacia ataques asistidos por IA.

- Expertos ven límites actuales al malware “hecho por IA”, pero recomiendan defensa proactiva y formación.

La irrupción de la inteligencia artificial ha disparado la productividad y la creatividad, pero también ha abierto la puerta a usos tramposos que no conviene subestimar. Cuando hablamos de “IA maliciosa” nos referimos a modelos, herramientas y técnicas de IA empleadas para engañar, defraudar o atacar a personas, empresas e infraestructuras, ya sea fabricando contenido falso, automatizando fraudes o potenciando el malware.

Este fenómeno no nace de cero: la historia del cibercrimen lleva décadas evolucionando y la IA simplemente le ha dado un turbo. Hoy cualquiera puede toparse con deepfakes muy creíbles, estafas telefónicas con voces clonadas o campañas de phishing redactadas sin errores gracias a modelos generativos. En este artículo te contamos, con lenguaje llano y ejemplos concretos, qué es la IA maliciosa, cómo se usa, por qué preocupa a expertos y fuerzas de seguridad, y qué medidas prácticas puedes aplicar para reducir riesgos.

Qué entendemos por IA maliciosa

En pocas palabras, es el empleo de sistemas de IA para fines dañinos o ilícitos. Incluye desde generar textos, imágenes, vídeos y audios falsos hasta asistir la creación o evasión de malware, pasando por automatizar estafas, manipular a gran escala o envenenar datos que entrenan a otros algoritmos.

Conviene distinguir conceptos. La IA “estrecha” (la que usamos a diario) resuelve tareas muy concretas; la hipotética AGI (inteligencia general) no existe aún. Dentro de la IA estrecha, la IA generativa destaca por crear contenido nuevo (texto, imágenes, audio, vídeo). Modelos de lenguaje, generadores de imágenes y sintetizadores de voz permiten resultados sorprendentemente realistas, lo que complica separar lo verdadero de lo manipulado.

Fábricas de falsedades: texto, vídeo y voz a la carta

Los ciberdelincuentes han abrazado con rapidez las mismas herramientas que usan periodistas, diseñadores o programadores. Entre las tácticas más frecuentes se encuentran:

- Generadores de texto: modelos avanzados pueden redactar artículos, correos y mensajes que imitan estilos profesionales. Resultado: fake news pulidas, guiones de phishing o bulos coherentes y persuasivos.

- Edición y creación de vídeo: software especializado (por ejemplo, plataformas de “deepfake”) permite superponer rostros en clips auténticos, fabricando escenas donde alguien parece decir o hacer cosas que jamás hizo.

- Clonación de voz: herramientas de síntesis generan “deepvoices”, imitaciones de voz muy logradas a partir de pocos segundos de audio, útiles para timos telefónicos y suplantaciones.

Un caso ilustrativo: una víctima recibió la llamada de un “familiar” que pedía dinero por una urgencia. La voz sonaba idéntica a la de su pariente porque había sido clonada con IA. Convencida por el tono afectivo y el apuro, transfirió una suma considerable a una cuenta controlada por delincuentes.

Este tipo de engaños se ha multiplicado y ya no son anécdota. Las suplantaciones por voz (vishing) y los deepfakes han disparado su impacto económico y emocional, con autoridades alertando sobre chantajes con imágenes manipuladas y anuncios fraudulentos que usan la imagen de figuras públicas para dotar de falsa legitimidad a inversiones trampa.

De Brain a la era de la IA: una breve historia del malware

Para entender por qué la IA es un acelerador, conviene repasar el camino del software malicioso. En 1986 apareció Brain, primer virus para IBM PC, ocultándose en el sector de arranque de disquetes; sus autores lo crearon como “aviso” antipiratería, pero se propagó globalmente.

Poco después, en 1988, llegó el gusano Morris, que explotó fallos en sistemas UNIX y puso en evidencia la fragilidad de la internet incipiente. El salto masivo de la infección por correo electrónico vino con LoveLetter (2000), el famoso “I Love You” que sobrescribía archivos y se reenviaba a contactos, causando pérdidas de miles de millones.

Con la profesionalización del cibercrimen, Zeus (2007) perfeccionó el robo de credenciales bancarias mediante inyección en navegador y control remoto de equipos; su código filtrado impulsó decenas de variantes. Stuxnet (2010) llevó el malware a la geopolítica, saboteando sistemas industriales SCADA y marcando un antes y un después en ataques a infraestructuras críticas.

En 2017, WannaCry combinó ransomware y gusano para aprovechar vulnerabilidades SMB en Windows, cifrando archivos a escala planetaria y paralizando servicios esenciales. Y en móviles, Joker se infiltró en apps Android para suscribir a víctimas a servicios premium sin permiso, demostrando que el fraude en la palma de la mano es un negocio muy rentable. En macOS, XCSSET en macOS mostró cómo también pueden surgir amenazas específicas por plataforma.

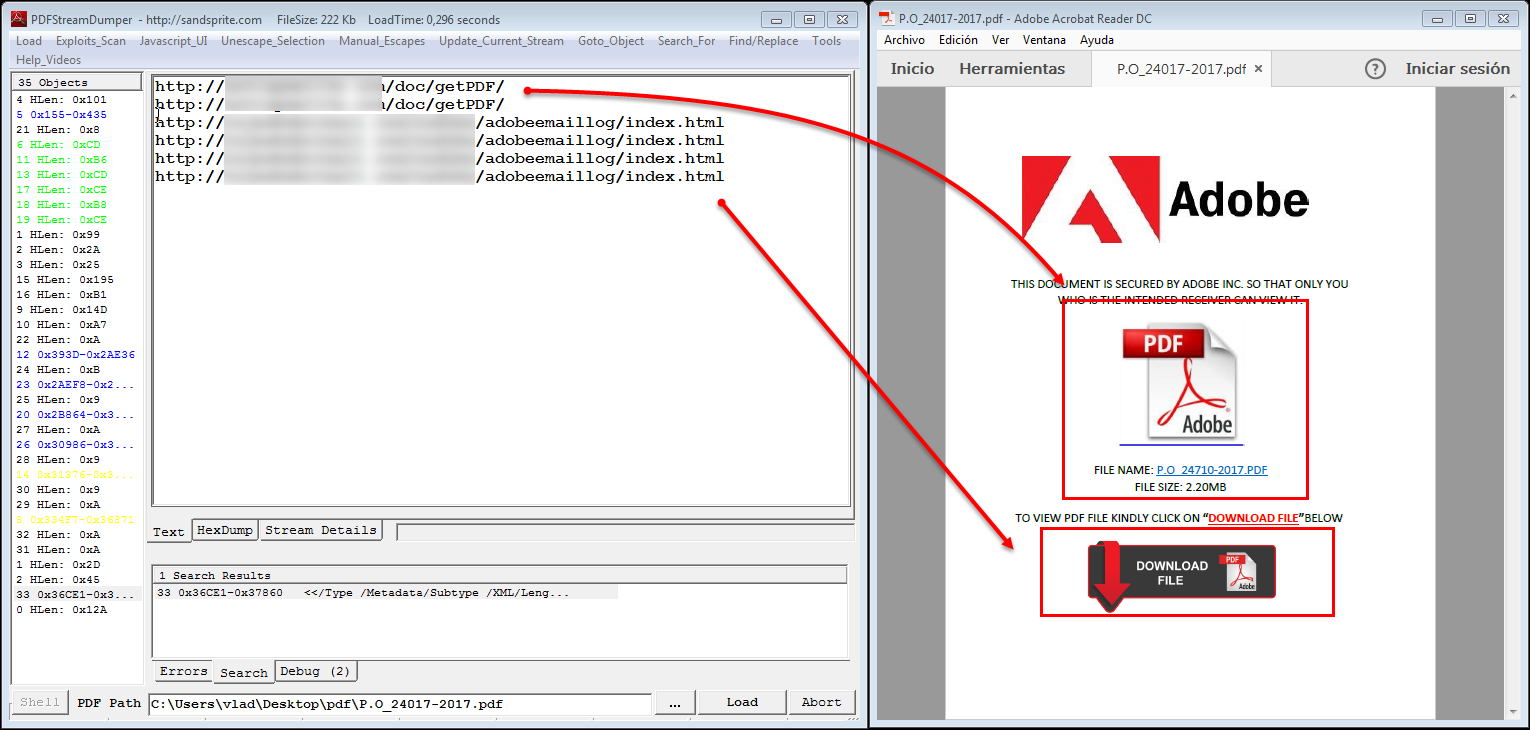

Ya en el presente, investigaciones han descrito pruebas de concepto como PromptLock, calificado como ransomware “impulsado por IA”, orientado a automatizar fases clave (reconocimiento, filtración de datos, cifrado). No se han visto campañas reales a gran escala con esta familia, pero muestra la dirección del riesgo: más velocidad, adaptación y escala.

Fraudes potenciados por IA: del teléfono al anuncio en redes

Las estafas de suplantación por voz con IA se han vuelto más verosímiles que nunca. En llamadas con histrionismo y urgencias fingidas, los timadores explotan el shock emocional para forzar decisiones impulsivas. A veces, mantienen a la víctima al teléfono mientras “prueban” su historia, complicando que esta verifique la realidad por otros medios.

También han proliferado deepfakes usados para chantaje (pagar o publicamos) y anuncios falsos con rostros reconocibles que recomiendan inversiones milagrosas. Que un anuncio aparezca en una plataforma popular no garantiza su legitimidad; los delincuentes compran publicidad y afinan la segmentación como cualquier marketer hábil.

¿Cómo reducir el riesgo en estos escenarios? Mantener la calma y escuchar “los fallos” de una voz sintética ayuda (entonación rara, cortes extraños), aunque cada vez fallan menos. Establecer una contraseña familiar es útil: si alguien dice ser tu hijo en apuros, que diga la palabra secreta acordada; si no la conoce, cuelga y verifica por otro canal.

Ante chantajes con material manipulado, ni pagar ni negociar: documenta, guarda evidencias y denuncia. Y cuando veas un anuncio de inversión “demasiado bueno para ser cierto”, verifica reputación en organismos de consumo o asociaciones de usuarios, busca reseñas y comprueba el dominio real de la supuesta empresa.

¿Puede la IA escribir malware imparable? Lo que dicen los expertos

Se han presentado proyectos experimentales para mostrar cómo la IA podría apoyar a un atacante. BlackMamba, por ejemplo, es un keylogger polimórfico que recurrió a un modelo generativo para crear partes del código en tiempo de ejecución. Otro, EyeSpy, valoraba qué aplicaciones de un sistema podrían contener datos sensibles y elegía un método de ataque; Morris II demostró cómo instrucciones maliciosas podrían “convencer” a aplicaciones con IA para exfiltrar datos o propagarse.

Sin embargo, profesionales de red teaming y analistas de inteligencia de amenazas coinciden en que estas pruebas no suponen una revolución inmediata. Los conceptos ya existían (ofuscación, polimorfismo, metaprogramación) y los motores heurísticos y de comportamiento usados por defensas actuales pueden detectarlos. Además, el código generado por modelos se apoya en datos de entrenamiento y, hoy por hoy, suele carecer de la sofisticación de un experto con experiencia real.

Esto no significa que podamos relajarnos. Si los modelos mejoran y se integran a gran escala en la cadena de desarrollo criminal, veremos campañas más veloces y baratas. Pero por ahora, lo más probable sería un exceso de “malware mediocre” fácilmente detectable. Como ocurre en desarrollo de software legítimo, la IA incrementa productividad, no sustituye el criterio experto.

Otros riesgos de la IA en ciberseguridad que conviene tener en el radar

Más allá del fraude, hay amenazas estructurales. La IA abarata ataques de fuerza bruta, denegación de servicio y campañas de ingeniería social al permitir automatizar análisis de objetivos, pulir mensajes y probar variantes hasta dar con la que mejor convierte.

Surgen también riesgos de privacidad: usuarios y empleados comparten información sensible con asistentes de IA sin entender cómo se almacena o revisa. Los modelos pueden filtrar datos por fallos de implementación, errores humanos o accesos indebidos. Y en manos de gobiernos o empresas poco escrupulosas, perfilado y vigilancia pueden escalar.

En entornos industriales y sanitarios, la seguridad física es un factor. Un sistema de IA que coordina robots, vehículos o equipamiento crítico, si se manipula o sufre datos contaminados, podría tomar decisiones peligrosas. La protección ya no es solo informática: también es de seguridad operacional.

También preocupa el robo de modelos de IA (por intrusión, ingeniería social o fuga interna) para reutilizarlos con fines maliciosos, así como el envenenamiento de datos, que introduce muestras corruptas en el entrenamiento de otro sistema con objeto de degradar su rendimiento, sesgar sus respuestas o abrirle una puerta trasera estadística. Además, la existencia de botnets sigue siendo un vector crítico en ataques distribuidos y DDoS.

Por último, la suplantación de identidad audiovisual ha saltado del cine a la vida cotidiana. Imitar voces de celebridades o rejuvenecer caras era cosa de grandes estudios; hoy cualquiera puede hacerlo con apps gratuitas y unos segundos de audio, con un impacto evidente en fraudes, desinformación y reputación.

Buenas prácticas para defenderte de la IA maliciosa

No existen balas de plata, pero sí capas de defensa que marcan diferencias. Empieza por auditar cualquier sistema de IA que uses (propio o de terceros): reputación, ubicación del tratamiento de datos, controles de acceso y capacidad de excluir tus datos del reentrenamiento.

En el plano personal y corporativo, limita qué información sensible compartes en prompts. Evita nombres de pacientes, secretos comerciales o credenciales. Asume que las conversaciones pueden ser revisadas por equipos de calidad o verse comprometidas si un atacante entra por otra vía.

Refuerza la seguridad de datos: cifrado robusto en reposo y en tránsito, segmentación de redes, contraseñas únicas con gestor, autenticación multifactor y principio de mínimo privilegio. Complementa con cortafuegos, IDS/IPS y soluciones EDR/XDR.

Mantén software, sistemas y marcos de IA siempre actualizados con parches al día. La higiene digital básica (inventario, eliminación de servicios innecesarios, copias de seguridad probadas) sigue siendo el antídoto más rentable.

Para modelos propios, considera el entrenamiento adversarial y técnicas de robustez que preparan al sistema frente a entradas maliciosas. Complementa con gestión de vulnerabilidades continua, pruebas de penetración y ejercicios rojos que incluyan escenarios con IA.

La formación importa: capacita a tu equipo para reconocer phishing “bien escrito”, políticas de uso de IA y protocolos de respuesta. Ensaya incidentes con runbooks claros que incluyan aislar endpoints, revocar credenciales, notificar a autoridades y comunicar a partes interesadas.

IA sin restricciones y el caso WormGPT: por qué pone nerviosas a las empresas

Han surgido plataformas presentadas como “libres de filtros” que no bloquean la generación de contenido dañino. Una de las más citadas ha sido WormGPT: sus promotores la vincularon a “investigación de seguridad”, pero la ausencia de límites facilita su uso delictivo, desde redactar trampas de ingeniería social hasta bosquejar componentes de programas maliciosos.

¿Por qué preocupa? Porque baja la barrera de entrada para actores con poca pericia y aumenta la personalización de ataques (por ejemplo, correos BEC que parecen escritos por el director financiero de tu empresa). Además, acelera iteraciones: más versiones, pruebas y mejoras en poco tiempo.

Respuestas recomendadas en el entorno corporativo: políticas claras de uso de IA, control de salidas hacia herramientas públicas, monitorización avanzada de anomalías y protección de correo y archivos, MFA en todo acceso sensible, VPN y microsegmentación, auditorías y simulaciones periódicas, y actualización continua de controles conforme evoluciona la amenaza.

Cuando la IA juega a favor: detección, respuesta y eficiencia

No todo son malas noticias. La IA potencia la ciberdefensa detectando anomalías en tiempo real, cazando amenazas desconocidas y acelerando la respuesta a incidentes las 24/7.

Modelos predictivos ayudan a pasar de lo reactivo a lo proactivo: priorizan riesgos, anticipan patrones de ataque y optimizan el trabajo del SOC. En correo, filtros basados en IA mejoran la detección de phishing; en web, bloquean dominios maliciosos con más precisión.

Para la identificación de bots, la IA aprende patrones de tráfico y comportamiento, mitigando abusos de credenciales o scraping masivo. En redes, detecta exfiltraciones y movimientos laterales con señales sutiles que un humano pasaría por alto.

Además, reduce falsos positivos (menos fatiga de alertas) y permite a equipos pequeños cubrir más superficie con menos coste. En control de acceso, añade señales biométricas y contextuales para frenar suplantaciones sin fricción excesiva.

Además, la IA acelera la investigación forense y automatiza enriquecimiento de indicadores, lo que permite cerrar ventanas de exposición con mayor rapidez.

Consejos prácticos para usuarios y familias ante estafas con IA

Si recibes una llamada de un “ser querido” pidiendo dinero, respira hondo y verifica. Haz preguntas que solo esa persona sabría, acuerda previamente una contraseña familiar y cuelga para llamar por tu cuenta a su número habitual.

Cuando te llegue un “chollo” por redes o email, invierte cinco minutos en comprobar la entidad: reputación en organismos de consumo, sitio web real, dominio y dirección física. Desconfía de urgencias, faltas de transparencia y promesas desmesuradas.

Para contenido sospechoso (vídeo/imagen), busca sombras raras, manos deformadas o gestos que no encajan. Hay herramientas comerciales que analizan audio y vídeo para detectar manipulación, pero tu sentido crítico sigue siendo la primera barrera.

Y por favor, no compartas información sensible con asistentes de IA si no es imprescindible. Si trabajas con datos personales o corporativos, revisa la configuración de privacidad y consulta la política de tu empresa.

Conviene recordar que la IA maliciosa no es una tecnología nueva, sino un nuevo contexto para amenazas de siempre. Las mismas prácticas de higiene digital, formación continua y defensa en profundidad siguen funcionando, ahora con la ayuda de herramientas de IA que también juegan del lado del bien. Con cabeza fría, políticas claras y tecnología adecuada, se puede convivir con la IA de forma segura y responsable.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.