- La base de una buena optimización en C/C++ es combinar sensatamente

-march, niveles-Oy algunas opciones seguras como-pipe. - Técnicas avanzadas como LTO, PGO, OpenMP o Graphite pueden dar grandes mejoras, pero aumentan la complejidad de compilación y depuración.

- Las flags de hardening (FORTIFY, stack protector, PIE, relro/now) refuerzan la seguridad a cambio de cierta pérdida de rendimiento.

- CMake y los distintos generadores permiten mantener un código portable entre GCC, Clang, MSVC y diferentes plataformas sin tocar el código fuente.

Cuando empiezas a jugar con las opciones de compilación en C y C++ es fácil caer en la tentación de activar todas las flags “molonas” que ves por internet. Pero la realidad es que una mala combinación de parámetros puede hacer tu sistema inestable, romper compilaciones o, peor todavía, generar binarios que fallan de formas muy sutiles o que requieren extraer información; en esos casos puede ser útil extraer texto oculto en binarios para investigar.

El objetivo de esta guía es que entiendas, de forma práctica y sin rodeos, cómo optimizar binarios en C/C++ con GCC y Clang usando las opciones correctas: desde las clásicas -O2, -march y -pipe, hasta técnicas avanzadas como LTO, PGO, OpenMP, Graphite o hardening de seguridad. Verás también cómo encaja todo esto con CMake, MinGW/MSYS2, Visual Studio, Xcode o Ninja para montar un entorno portátil y mantenible.

Qué son CFLAGS, CXXFLAGS y cómo usarlos sin liarla

En casi todos los sistemas tipo Unix (Linux, BSD, etc.) se utilizan las variables CFLAGS y CXXFLAGS para pasar opciones al compilador de C y C++. No forman parte de ningún estándar formal, pero son tan habituales que cualquier sistema de build bien escrito (Make, Autotools, CMake, Meson…) las respeta.

En distribuciones como Gentoo estas variables se definen de forma global en /etc/portage/make.conf, y a partir de ahí se heredan a todos los paquetes que se compilan con Portage. En otros sistemas las puedes exportar en la shell o ponerlas en un Makefile, un script de CMake o similares.

Es bastante común definir CXXFLAGS reutilizando el contenido de CFLAGS y, si hace falta, añadir alguna opción específica para C++. Por ejemplo: CXXFLAGS="${CFLAGS} -fno-exceptions". Lo importante es no meter ahí flags de forma indiscriminada, porque se aplicarán a todo lo que compiles.

Conviene tener claro que las opciones agresivas en CFLAGS/CXXFLAGS pueden romper compilaciones, introducir bugs muy difíciles de depurar o incluso ralentizar los binarios. Los niveles altos de optimización no siempre dan más rendimiento, y algunas transformaciones pueden explotar supuestos que tu código no cumple.

Optimización básica: -march, -mtune y niveles -O

La base de cualquier ajuste sensato pasa por tres piezas: seleccionar la arquitectura de CPU, elegir el nivel de optimización y, a veces, activar pequeñas mejoras inofensivas como -pipe. Casi todo lo demás debería venir después y con cabeza.

Elegir arquitectura: -march, -mtune y compañía

La opción -march=<cpu> le indica a GCC/Clang para qué familia concreta de procesador va a generar código. Permite usar instrucciones específicas (SSE, AVX, AVX2, AVX-512, etc.) y ajustar detalles del ABI. Si te pasas de listo y eliges una CPU demasiado moderna, el binario simplemente no arrancará en máquinas antiguas.

Para saber qué soporta tu procesador, en Linux puedes consultar /proc/cpuinfo o usar comandos del propio compilador del estilo gcc -Q -O2 --help=target. En x86-64 moderno se han estandarizado perfiles genéricos como x86-64-v2, x86-64-v3 y x86-64-v4, que agrupan conjuntos de instrucciones crecientes y están soportados desde GCC 11.

Además de -march, existe -mtune=<cpu> para “afinar” la planificación del código hacia un modelo concreto sin usar instrucciones nuevas. En arquitecturas no x86 también aparecen -mcpu y -mtune como opciones relevantes (ARM, PowerPC, SPARC…). En x86, -mcpu está de hecho obsoleto.

Un truco bastante usado es -march=native, que hace que el compilador detecte la CPU de la máquina local y active automáticamente las extensiones apropiadas. Esto viene de cine en entornos donde solo vas a ejecutar los binarios en la misma máquina donde los compilas, pero es una trampa mortal si generas paquetes para otras CPUs.

En procesadores recientes de Intel y AMD, GCC incorpora nombres específicos para cada familia, como -march=rocketlake, -march=sapphirerapids, -march=znver2 o -march=znver3. Estas opciones agrupan las instrucciones avanzadas (AVX2, AVX-512, FMA, etc.) de cada generación y permiten exprimir bastante el hardware cuando sabes dónde vas a desplegar.

Niveles de optimización -O: cuándo usar cada uno

La opción -O controla el nivel global de optimización aplicado al código. Cada escalón activa un conjunto de transformaciones más amplio, con impacto tanto en tiempo de compilación como en consumo de memoria y facilidad de depuración.

-O0: sin optimizar. Es la opción por defecto si no indicas nada. Compila rápido y genera código muy fácil de depurar, pero lento y grande. Ideal para desarrollo inicial y para investigar bugs complicados.-O1: primer nivel de optimización. Aplica mejoras relativamente baratas que suelen dar un salto decente en rendimiento sin hacer la compilación demasiado pesada.-O2: es el nivel recomendado para uso general en la mayoría de proyectos. Equilibra bien rendimiento, tiempo de compilación y estabilidad, y por eso es el valor que muchas distribuciones usan por defecto.-O3: activa todas las optimizaciones de-O2más transformaciones adicionales agresivas, como desenrollado de bucles muy fuerte o vectorización más intensa. En algunos códigos numéricos puede ir de lujo, pero también es más propenso a destapar UB en el código o a inflar el tamaño del ejecutable.-Os: intenta reducir el tamaño del binario priorizando el espacio sobre la velocidad. Es útil en entornos con almacenamiento o caché muy limitados.-Oz(GCC 12+): lleva el ahorro de tamaño al extremo, aceptando bajadas notables de rendimiento. Útil para binarios muy pequeños o escenarios muy específicos.-Ofast: es como un-O3sin respeto estricto a los estándares de C/C++. Permite romper algunas garantías del lenguaje para sacar rendimiento extra, especialmente en cálculos de coma flotante. Hay que usarlo sabiendo perfectamente qué se hace.-Og: pensado para depurar. Aplica solo las optimizaciones que no interfieren demasiado con el debugger y deja el código en un punto medio entre-O0y-O1.

Niveles por encima de -O3 como -O4 o -O9 son puro humo: el compilador los acepta pero internamente los trata como -O3. No hay magia oculta ahí, solo postureo.

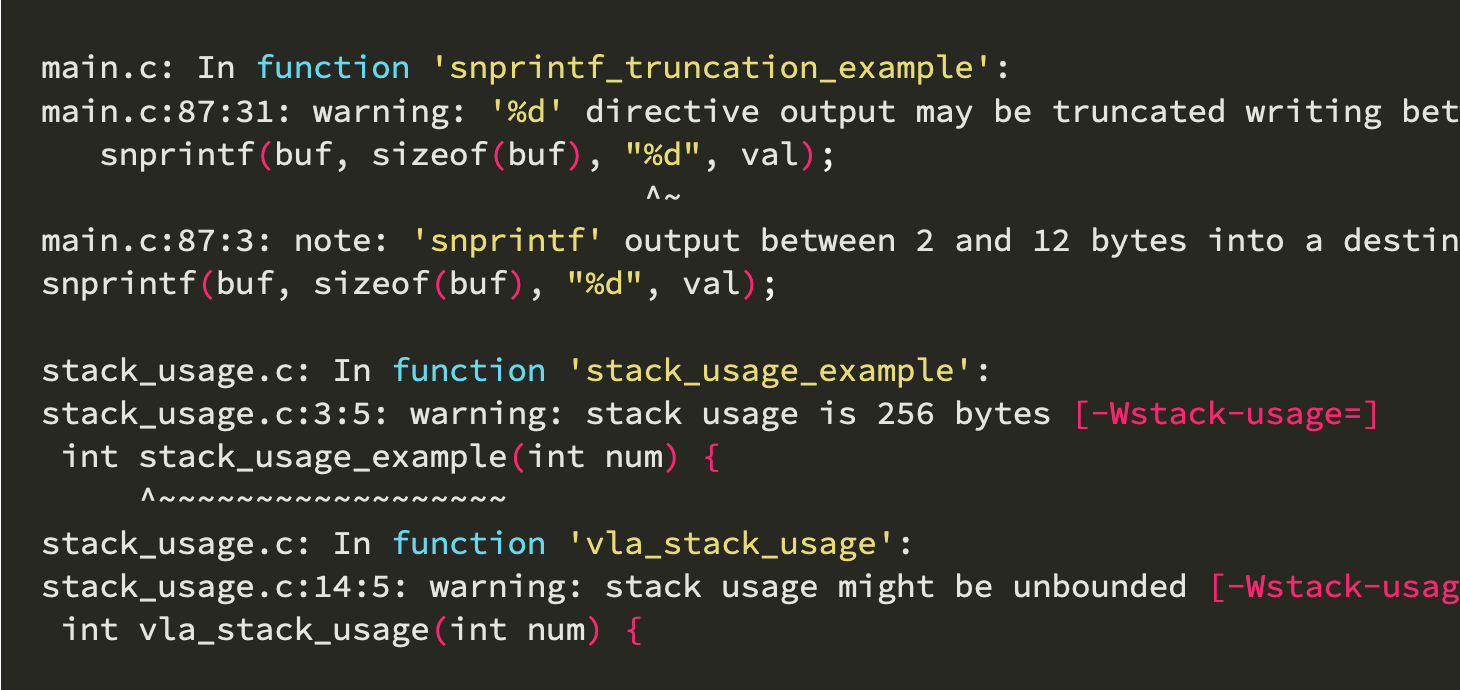

Si empiezas a ver compilaciones que fallan misteriosamente, cuelgues raros o resultados distintos según el optimizador, un buen paso de diagnóstico es bajar temporalmente a -O1 o incluso -O0 -g2 -ggdb para obtener binarios fácilmente depurables y reportar el bug con información útil.

-pipe y otras opciones básicas

La flag -pipe le indica al compilador que use tuberías en memoria en lugar de ficheros temporales en disco entre fases de compilación (preproceso, compilación, ensamblado). Normalmente hace el proceso algo más rápido, aunque consume más RAM. En máquinas con muy poca memoria puede acabar provocando que el sistema mate al compilador, así que úsalo con mesura en esos casos.

Otras opciones tradicionales como -fomit-frame-pointer permiten liberar el registro del puntero de pila para general más código, pero dificultan la depuración con backtraces limpios. En arquitecturas modernas x86-64 el compilador ya gestiona esto bastante bien y a menudo ni siquiera hace falta ponerla a mano.

Extensiones SIMD, Graphite y vectorización de bucles

Los compiladores modernos para x86-64 activan automáticamente muchas instrucciones SIMD en función de la CPU elegida con -march. Aun así, verás por ahí flags como -msse2, -mavx2 o similares que se pueden añadir de forma explícita.

En general, si estás usando un -march adecuado no necesitas activar manualmente -msse, -msse2, -msse3, -mmmx o -m3dnow, porque ya vienen implícitas. Solo tiene sentido forzarlas en CPUs muy particulares donde GCC/Clang no las activen por defecto.

Para bucles complejos, GCC incluye el conjunto de optimizaciones Graphite, que se apoyan en la librería ISL. Mediante flags como -ftree-loop-linear, -floop-strip-mine y -floop-block el compilador analiza bucles y puede reestructurarlos para mejorar la localidad de datos y la paralelización; en casos concretos, ver ejemplos de C a bajo nivel ayuda a adaptar el código para estas transformaciones.

Estas transformaciones pueden dar buenos resultados en código numérico pesado, pero no son inocuas: pueden disparar el consumo de RAM al compilar y provocar fallos en proyectos grandes que no estaban escritos pensando en ellas. Por eso se recomienda activarlas solo en piezas de código concretas o proyectos donde se haya probado que funcionan bien.

Paralelismo: OpenMP, -fopenmp y -ftree-parallelize-loops

Si tu código utiliza OpenMP, tanto GCC como Clang ofrecen soporte bastante sólido mediante la opción -fopenmp. Esto permite paralelizar secciones de código, sobre todo bucles, mediante directivas en el propio código fuente, y que el compilador genere el trabajo en varios hilos.

Además de -fopenmp, GCC incluye la opción -ftree-parallelize-loops=N, donde N suele establecerse al número de núcleos disponibles (por ejemplo usando $(nproc) en scripts de build). Esto intenta paralelizar bucles automáticamente sin necesidad de añadir directivas manuales, aunque el éxito depende mucho de la forma en que esté escrito el código.

Hay que tener en cuenta que activar OpenMP globalmente en todo un sistema puede ser muy problemático. Hay proyectos que no están preparados para ello, otros que usan sus propios modelos de concurrencia y algunos que directamente fallan al compilar cuando ven -fopenmp. Lo sensato es habilitarlo por proyecto o incluso por módulo, no en las CFLAGS globales del sistema.

Optimización en tiempo de enlace: LTO

La Link Time Optimization (LTO) permite que el compilador no se quede limitado a un único archivo fuente a la hora de optimizar, sino que vea el programa entero en la fase de enlace y aplique optimizaciones globales sobre todos los objetos implicados.

En GCC se activa con -flto, y se puede indicar un número de hilos, por ejemplo -flto=4, o dejar que detecte el número de núcleos con -flto=auto. Si además se usa -fuse-linker-plugin junto con el enlazador gold y el plugin LTO instalado en los binutils, el compilador puede extraer información LTO incluso de librerías estáticas que participen en el enlace.

LTO suele generar ejecutables algo más pequeños y, en muchos casos, más rápidos, porque elimina código muerto y puede inlining entre módulos. A cambio, el tiempo de compilación y el consumo de memoria se disparan, especialmente en proyectos grandes con miles de ficheros objeto.

En entornos como Gentoo, donde se recompila todo el sistema desde fuentes, aplicar LTO de forma global sigue considerándose algo delicado: hay muchos paquetes que todavía no se llevan bien con LTO y requieren desactivarla de forma selectiva. Por eso suele recomendarse activarla solo en proyectos concretos o en compilaciones de GCC/Clang donde realmente se note el beneficio.

PGO: Profile Guided Optimization

La optimización guiada por perfiles (PGO) consiste en compilar el programa una primera vez con instrumentación, ejecutarlo con cargas de trabajo representativas para recopilar estadísticas de ejecución y, después, recompilarlo utilizando esos perfiles para guiar el optimizador.

En GCC el flujo típico es: primero compilar con -fprofile-generate, ejecutar el programa (o sus tests) para generar datos de perfil, y luego recompilar con -fprofile-use apuntando al directorio donde se han almacenado los ficheros de perfil. Con opciones adicionales como -fprofile-correction o desactivando ciertos avisos (-Wno-error=coverage-mismatch) se pueden evitar errores frecuentes derivados de cambios en el código entre una fase y otra; además suele ser útil monitorizar rendimiento con eBPF y perf para obtener perfiles precisos.

Bien aplicada, PGO puede proporcionar mejoras de rendimiento muy superiores a las de simplemente subir el nivel de -O, porque toma decisiones basadas en datos reales de ejecución, no en modelos genéricos. El problema es que es un proceso pesado: hay que repetirlo en cada actualización relevante del código, y depende mucho de que el escenario de prueba sea representativo del uso real.

Algunos proyectos (incluido el propio GCC en ciertas distribuciones) ofrecen ya flags o scripts específicos para activar PGO de forma automatizada, pero en general sigue siendo una técnica para usuarios avanzados que estén dispuestos a invertir tiempo en el proceso.

Hardening: seguridad a base de flags

Más allá de la velocidad, muchos entornos ponen el foco en endurecer los binarios frente a vulnerabilidades, incluso a costa de perder algo de rendimiento. GCC y los enlazadores actuales ofrecen un buen abanico de opciones de hardening que se pueden activar desde CFLAGS/CXXFLAGS y LDFLAGS.

Algunas de las más habituales son:

-D_FORTIFY_SOURCE=2o=3: añade comprobaciones adicionales en ciertas funciones de la libc para detectar desbordamientos de búfer en tiempo de ejecución.-D_GLIBCXX_ASSERTIONS: activa comprobaciones de límites en contenedores y cadenas de C++ de la STL, detectando accesos fuera de rango.-fstack-protector-strong: inserta canarios en la pila para detectar escrituras que la corrompan.-fstack-clash-protection: mitiga ataques basados en choques entre pila y otras regiones de memoria.-fcf-protection: añade protecciones de flujo de control (por ejemplo, contra ataques tipo ROP) en arquitecturas que lo soportan.-fpiejunto con-Wl,-pie: genera ejecutables posicionables, necesarios para un ASLR efectivo.-Wl,-z,relroy-Wl,-z,now: endurecen la tabla de relocaciones y desactivan el binding perezoso de símbolos, dificultando ciertos vectores de ataque.

Perfiles «hardened» de algunas distribuciones ya traen muchas de estas opciones activadas por defecto. Activarlas a mano sin entender el impacto puede llevarte a binarios notablemente más lentos, sobre todo en aplicaciones grandes o muy intensivas en memoria, pero en servidores expuestos o escritorios sensibles suele ser un precio razonable.

Elegir compilador y entorno: GCC, Clang, MSVC, MinGW, Xcode…

En la práctica, muchas veces no solo eliges flags, sino qué compilador y qué toolchain completo vas a usar en cada plataforma. GCC y Clang suelen estar muy parejos en rendimiento, y las diferencias son más visibles en diagnósticos, tiempos de compilación o compatibilidad con determinadas extensiones.

En Windows tienes varias rutas: Visual Studio (MSVC) con sus toolsets v143, v142, etc.; o bien MinGW-w64 a través de MSYS2 que te da GCC y Clang nativos de Windows junto con las librerías Win32 necesarias. MSYS2 se gestiona con pacman y ofrece entornos MinGW64 (basado en MSVCRT clásica) y UCRT64 (con Universal CRT, más moderno).

En macOS el camino estándar es Xcode con clang/clang++, donde el concepto clave es el Base SDK (la versión del sistema para la que se compila) y el Deployment Target (la versión mínima de macOS en la que quieres que tu app funcione). Ajustar correctamente ese par evita el clásico desastre de compilar solo para la última versión del sistema y que tus binarios no arranquen en versiones un poco más antiguas.

En Linux lo normal es tirar de GCC y Make o Ninja, quizá con CMake como metagenerador. Además, distribuciones como Ubuntu permiten instalar múltiples versiones de GCC y seleccionarlas con update-alternatives, de manera parecida a como en macOS usas xcode-select para cambiar de Xcode.

Si necesitas entornos de depuración cómodos sobre proyectos generados con Make o Ninja (que son monoconfiguración), Eclipse CDT y Visual Studio Code son dos opciones muy apañadas: CMake puede producir los archivos de proyecto que necesitan o integrarse directamente con ellos para configurar, compilar y depurar.

Portabilidad y CMake: mismo código, distintos toolchains

Lograr que un proyecto en C/C++ compile sin tocar código en Windows, Linux y macOS exige combinar bien CMake, los generadores disponibles y los distintos compiladores. La idea es que el archivo CMakeLists.txt describa el proyecto de forma abstracta y CMake genere el tipo de proyecto adecuado en cada plataforma.

En Windows puedes invocar CMake con -G "Visual Studio 17 2022" para producir una solución con msbuild, o con -G "Ninja" para tener builds más rápidos desde consola. Además, mediante -T v143, v142, etc., seleccionas el Platform Toolset (versión del compilador MSVC) y con -A x64, Win32 o arm64 eliges la arquitectura.

Con MinGW/MSYS2 lo normal es usar -G "MinGW Makefiles" o -G "Ninja" y, a través de las variables CMAKE_C_COMPILER y CMAKE_CXX_COMPILER, escoger si quieres GCC o Clang. En este caso las configuraciones (Debug, Release, etc.) se controlan vía -DCMAKE_BUILD_TYPE, ya que Make y Ninja son monoconfiguración.

En macOS, -G Xcode te da un proyecto perfecto para depurar en el IDE, y puedes controlar el SDK y el Deployment Target con variables como CMAKE_OSX_DEPLOYMENT_TARGET. Si solo quieres Make o Ninja, usas los mismos generadores que en Linux.

La gracia de todo esto es que, bien montado, puedes mantener una sola base de código y un conjunto coherente de flags (a veces ajustados por plataforma) y compilar en cualquiera de los entornos sin tener que andar toqueteando el código fuente cada dos por tres. Eso sí, conviene no olvidar la máxima: primero que funcione bien, luego ya apretamos el acelerador de la optimización.

Con todo lo visto, la idea general es quedarse con una combinación moderada pero efectiva (algo del estilo -O2 -march=<cpu adecuada> -pipe más algún hardening razonable) y reservar las balas gordas —LTO, PGO, Graphite, OpenMP agresivo— para aquellos proyectos o módulos donde realmente están medidas las mejoras y se aceptan los costes de mantenimiento y depuración que traen bajo el brazo.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.