- AMD lanza la serie Instinct MI350, que incorpora los modelos MI350X y MI355X, con una mejora de hasta 35 veces en inferencia respecto a la generación anterior.

- Las nuevas GPU están fabricadas en 3 nm, cuentan con 185.000 millones de transistores y 288 GB de memoria HBM3E, y presentan un rendimiento y eficiencia energética sobresalientes.

- Supermicro y grandes socios tecnológicos como Meta, Microsoft, OpenAI y Oracle ya adoptan estas soluciones para entrenar y escalar modelos avanzados de IA.

- La infraestructura basada en MI350 y el software ROCm 7 aportan flexibilidad, escalabilidad y reducción drástica en el coste y consumo energético de centros de datos IA.

AMD ha dado un paso decidido en su estrategia para competir en el terreno de la inteligencia artificial con el lanzamiento de la familia de aceleradores AMD Instinct MI350. Esta nueva serie, presentada en el evento Advancing AI 2025, llega con la promesa de convertirse en uno de los referentes en rendimiento, eficiencia y escalabilidad para tareas de IA generativa y computación de alto rendimiento. Gracias a una combinación de hardware avanzado y ecosistema de software abierto, AMD refuerza su posición frente a otros grandes fabricantes y consigue captar la atención de gigantes tecnológicos como Meta, Microsoft, OpenAI u Oracle.

La serie MI350 supone un avance generacional considerable: mejora hasta 4 veces el rendimiento respecto a la familia anterior y logra hasta 35 veces más eficiencia en procesos de inferencia. Este salto radical tiene el objetivo de cubrir la creciente demanda de potencia en centros de datos y aplicaciones de IA, que requieren procesar y entrenar modelos cada vez más complejos.

Novedades técnicas de la serie AMD Instinct MI350

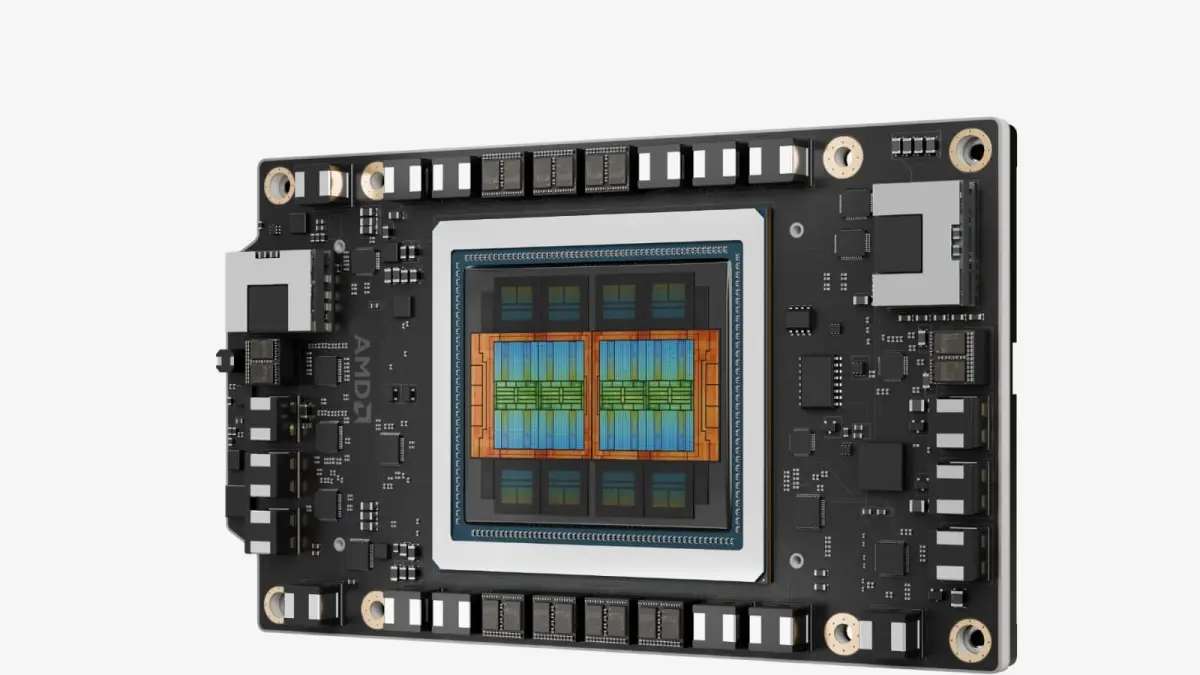

El corazón de la serie está formado por los modelos MI350X y MI355X, ambos fabricados con el proceso de 3 nanómetros de TSMC. Integran 185 mil millones de transistores, lo que permite una densidad y eficiencia energética destacables. Cada GPU está equipada con 288 GB de memoria HBM3E (apoyada por Micron y Samsung), capaz de alcanzar un ancho de banda de hasta 8 TB/s.

En cuanto a arquitectura, las nuevas tarjetas basan su diseño en 256 unidades de cómputo y 16.384 núcleos, distribuidos en ocho zonas con XCDs independientes. Además, aprovechan la tecnología Infinity Fabric de cuarta generación para interconexión y una caché Infinity de 256 MB, optimizando la transferencia de datos en cargas de trabajo intensivas de IA.

Otro aspecto diferenciador es la compatibilidad con tipos de datos avanzados como FP4 y FP6, ideales para la inferencia de modelos de gran tamaño. La serie cubre distintas necesidades de refrigeración, ya que está disponible en versiones con disipación por aire y por líquido, permitiendo su despliegue en diferentes configuraciones de rack. Un solo rack puede incorporar hasta 64 GPU en refrigeración por aire o hasta 128 GPU si se opta por refrigeración líquida directa, alcanzando unos impresionantes 2,6 exaFLOPS de rendimiento FP4/FP6 en el conjunto.

Comparativas con la competencia y eficiencia energética

AMD ha presentado datos que sitúan a la MI355X por delante de las tarjetas B200 de Nvidia en rendimiento, llegando a ser hasta 2,2 veces más rápida en determinados escenarios. En pruebas de inferencia con modelos de IA como Llama 3.1 405B, la empresa afirma que la MI355X multiplica por 35 su rendimiento respecto a la serie MI300 anterior y supera a la competencia tanto en velocidad de cálculo como en capacidad de memoria, con un 40% más de tokens generados por dólar invertido.

La eficiencia energética también es un punto fuerte de esta generación. Según AMD, la serie MI350 ha conseguido mejorar la eficiencia en consumo hasta 38 veces desde la generación base de hace cinco años, superando los objetivos previstos, y se marca el reto de multiplicarla por 20 antes de 2030 a nivel de rack. Esto podría permitir, en unos años, que un modelo que hoy requiere cientos de racks para su entrenamiento pueda ser manejado con una fracción de esos recursos.

Infraestructura, ecosistema y colaboraciones con grandes socios

La integración en plataformas de centros de datos es otro de los pilares de AMD. Fabricantes como Supermicro ya ofrecen soluciones de servidores optimizadas con las GPU MI350, disponibles en versiones refrigeradas por aire o líquido y preparadas para escalar hasta cientos de GPU por rack. Estas plataformas utilizan CPUs AMD EPYC y tecnología de interconexión Pollara para maximizar el rendimiento, la escalabilidad y la eficiencia general del sistema, facilitando el despliegue en nube y empresas que requieren IA a gran escala.

Grandes compañías tecnológicas ya han apostado por la tecnología de AMD para distintos fines. Meta ha implementado la anterior generación (MI300X) para inferencia de sus modelos Llama y planea dar el salto a la serie MI350 en cuanto esté disponible, destacando la capacidad de computación y la memoria. El rendimiento en IA en sistemas Windows también se ve potenciado por avances como estos. Microsoft Azure utiliza los aceleradores de AMD para ejecutar modelos de IA tanto propietarios como abiertos en producción, y Oracle Cloud Infrastructure desplegará clústeres masivos equipados con MI355X para alcanzar una escala zettascale. Por su parte, OpenAI y Cohere han destacado la eficiencia y el rendimiento que les aportan las soluciones de AMD.

En el terreno del software, la versión renovada de ROCm 7 impulsa el rendimiento de la IA y facilita la compatibilidad con los principales frameworks y modelos actuales como Llama o DeepSeek. Además, la compañía ha puesto en marcha AMD Developer Cloud, una plataforma de nube optimizada para desarrolladores e investigación en IA.

Preparando el futuro: hoja de ruta y nuevas generaciones

AMD no se queda ahí y ya ha avanzado el desarrollo de la próxima generación de aceleradores, la serie Instinct MI400, basada en memorias HBM4 y una arquitectura aún más ambiciosa. Esta línea llegará junto con infraestructura “Helios”, procesadores EPYC Venice (Zen 6) y nuevas tarjetas de red Pensando Vulcano, con el objetivo de multiplicar por diez el rendimiento de los sistemas de inferencia.

Con todas estas novedades, AMD parece decidida a democratizar el acceso a la inteligencia artificial y a posicionarse como uno de los actores principales en el ecosistema abierto de IA, tanto desde el punto de vista del hardware como del software y el apoyo a la comunidad tecnológica.

Los aceleradores Instinct MI350 estarán disponibles para los socios de la firma durante el tercer trimestre de 2025, y su adopción en centros de datos y servicios de nube se espera que marque un antes y un después en la forma en la que se abordan los retos de la inteligencia artificial avanzada. La combinación de rendimiento bruto, eficiencia y flexibilidad en la infraestructura, junto al soporte de grandes empresas del sector, apunta a que el impacto de esta tecnología será considerable en los próximos años.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.