- Linux sostiene la mayor parte de la infraestructura digital global y es clave para la soberanía tecnológica y la seguridad en internet.

- El modelo de software libre y el ecosistema GNU/Linux impulsan la innovación, la colaboración y la independencia frente al software propietario.

- Las tendencias técnicas actuales (64 bits, Rust, sistemas inmutables y archivos autocorrectores) refuerzan la estabilidad y fiabilidad de Linux.

- En el escritorio, GNU/Linux crece con escritorios modernos y una comunidad activa que lo consolida como opción cada vez más atractiva.

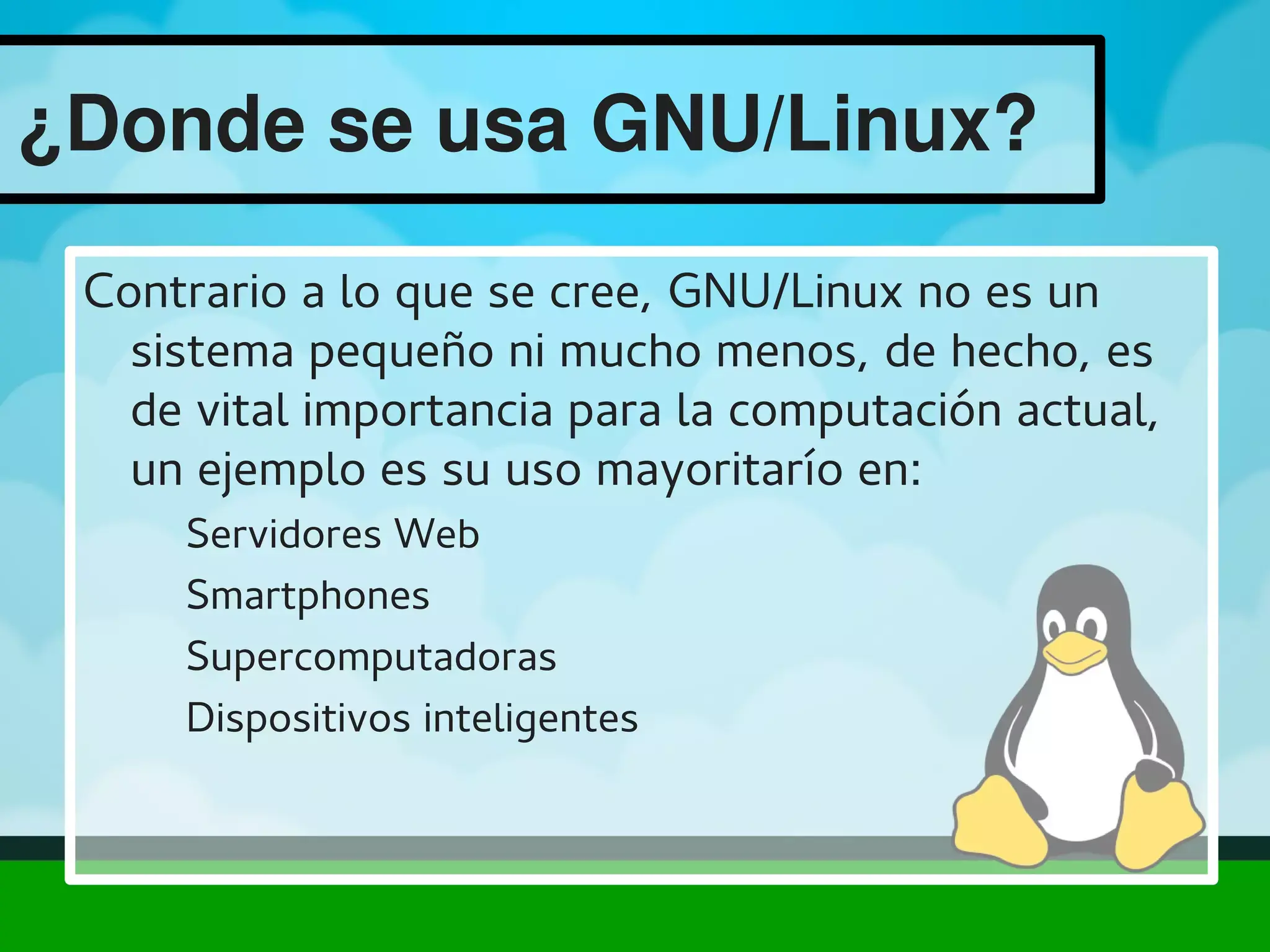

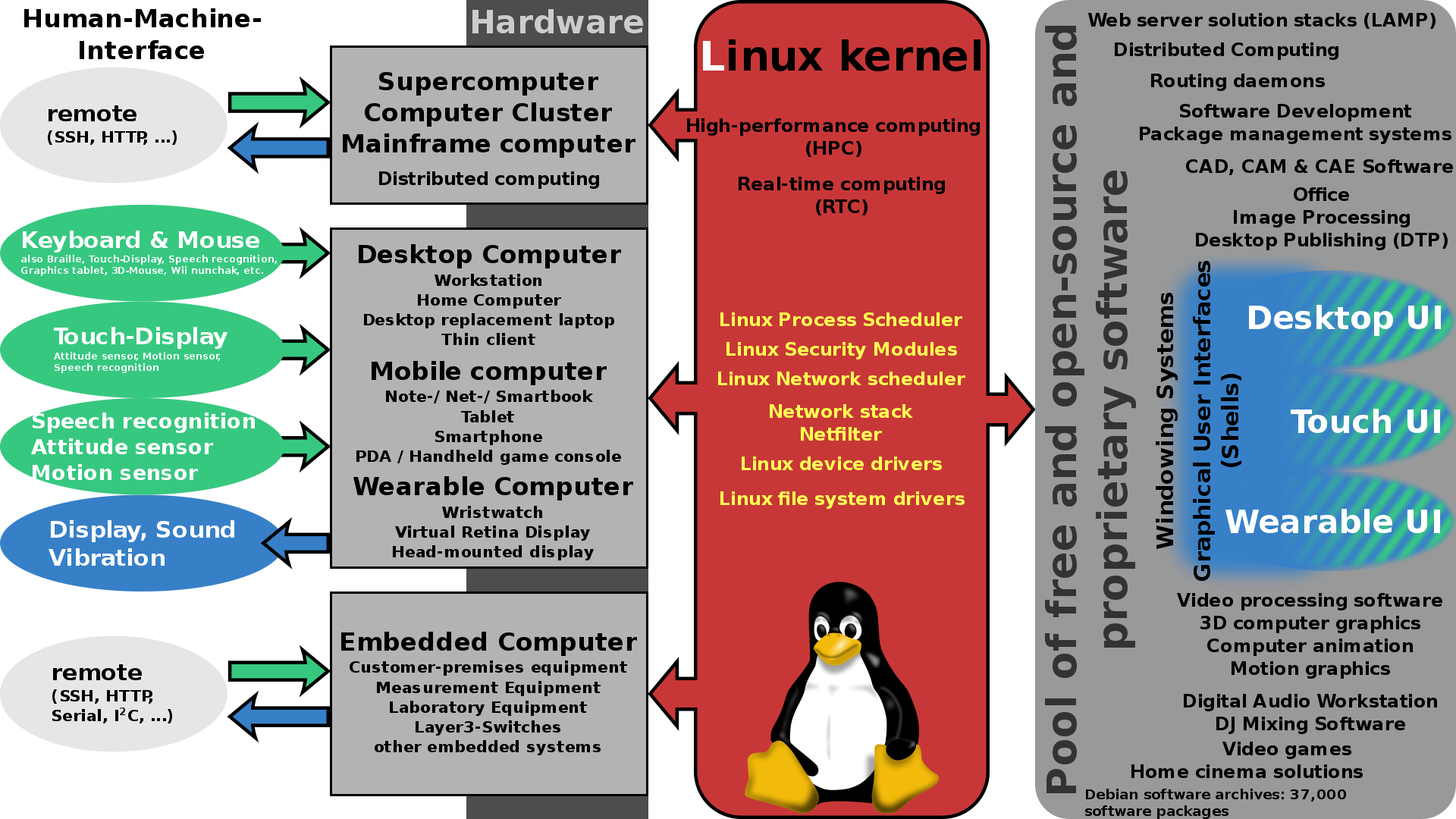

Linux se ha convertido en el gran protagonista silencioso de la era digital: está en servidores, móviles, superordenadores, televisores, coches conectados, dispositivos IoT y en buena parte de la infraestructura crítica del planeta. Aun así, mucha gente sigue pensando en él solo como “ese sistema raro” para frikis del ordenador. Nada más lejos de la realidad: cada vez que miras el tiempo en el móvil, ves una serie en streaming o mandas un correo, lo más probable es que haya uno o varios equipos con Linux trabajando en la sombra para que todo funcione.

La avalancha de noticias y artículos sobre Linux en los últimos años refleja un cambio profundo en cómo gobiernos, empresas, desarrolladores y usuarios ven el software libre y el código abierto. Se habla de seguridad en internet, de independencia tecnológica en Europa, de escándalos globales como el de los archivos de Jeffrey Epstein y de cómo se gestionan los datos y la privacidad; se habla de procesadores abiertos, de pequeñas placas de 35 dólares que se usan en colegios, de fallos críticos en librerías como OpenSSL y de cómo la comunidad responde a ellos. Y, por debajo de todo eso, siempre aparece Linux como pieza clave.

Linux como columna vertebral de la infraestructura digital

En la actualidad, cerca del 80% de los servidores del mundo funcionan con alguna distribución Linux, lo que convierte a este sistema operativo en el auténtico “sistema nervioso” de internet. Grandes plataformas de correo, redes sociales, servicios de streaming, comercio electrónico y nubes públicas se apoyan en Linux por su estabilidad, escalabilidad y flexibilidad. Para los administradores de sistemas, es la opción de referencia cuando se busca un entorno robusto que pueda crecer sin perder el control y gestionar redes mediante el uso de iproute2.

Esta omnipresencia convierte a Linux en una pieza estratégica para la soberanía tecnológica. Gobiernos y organismos públicos son cada vez más conscientes de que depender exclusivamente de software propietario, controlado por unas pocas multinacionales, supone un riesgo. Por eso se cita a menudo a expertos y gurús del software libre, como Richard Stallman, que llevan años insistiendo en que los Estados deberían migrar a soluciones libres para proteger la democracia, garantizar la transparencia y evitar sometimientos tecnológicos difíciles de revertir.

El interés por Linux no se limita a los despachos y centros de datos: también llega a los entornos más exigentes, como la Estación Espacial Internacional, donde los astronautas han utilizado portátiles con Debian para trabajar en un entorno en el que la estabilidad y la seguridad no son negociables. Si en la ISS confían en Linux, no es por romanticismo, sino porque ofrece el nivel de control y fiabilidad que se necesita cuando un error de software puede tener consecuencias serias.

Incluso en el terreno aparentemente ajeno a la tecnología dura, como los grandes casos judiciales o los escándalos mediáticos, Linux aparece por detrás, porque la gestión de enormes volúmenes de datos, su análisis y su custodia se apoya en servidores y sistemas que, en muchísimos casos, corren sobre este sistema operativo. El mundo digital y el mundo legal se cruzan cada vez más, y la infraestructura abierta se vuelve clave para garantizar trazabilidad y auditoría independiente.

Noticias sobre vulnerabilidades y brechas de seguridad en internet ponen de relieve tanto los riesgos como las fortalezas del modelo abierto. Centros como el SANS Internet Storm Center han llegado a calificar ciertos incidentes de “muy, muy, muy graves y escalofriantes”, como el caso de un programador que borró una línea de código esencial para generar claves de cifrado. Sin embargo, la capacidad de la comunidad para detectar, revisar y arreglar problemas en proyectos como OpenSSL y amenazas como amenazas como Voidlink, apoyados por entidades como la Linux Foundation, es una demostración práctica de por qué el código abierto es crítico en la seguridad global.

Software libre, código abierto y el papel de GNU/Linux

Para entender la relevancia actual de Linux, hay que remontarse al nacimiento del movimiento del software libre, liderado por Richard Stallman desde los años 80 con el proyecto GNU. Su objetivo era construir un sistema operativo completamente libre, en el que los usuarios pudieran ejecutar, estudiar, modificar y redistribuir el software sin ataduras. Cuando Linus Torvalds lanzó el kernel Linux en 1991, ambas piezas encajaron: el núcleo de Torvalds y las herramientas de GNU formaron el sistema completo que hoy conocemos como GNU/Linux.

Esta unión marcó el inicio de una nueva era basada en la colaboración entre usuarios y desarrolladores. Frente al modelo cerrado, donde el código es un secreto de empresa, GNU/Linux ofrecía la posibilidad de que cualquier persona con los conocimientos adecuados pudiera proponer mejoras, corregir errores o adaptar el sistema a sus necesidades. Anualmente se ha ido doblando el número de equipos personales y servidores que recurren a aplicaciones libres y no propietarias, lo que ha ido cambiando la balanza en muchas organizaciones.

El ecosistema de software libre ha demostrado ser un terreno fértil para la innovación. Surgen proyectos que compiten de tú a tú con soluciones comerciales, no solo por precio (que también), sino por flexibilidad, seguridad y velocidad de evolución. El hecho de que grandes empresas tecnológicas, bancos, operadores y administraciones públicas contribuyan hoy al kernel y al software libre en general demuestra que el modelo ha dejado de ser marginal para convertirse en un componente central de la economía digital.

No hay que olvidar que Linux no es solo un sistema operativo, sino también una comunidad vibrante formada por usuarios domésticos, desarrolladores individuales, pequeñas empresas y gigantes tecnológicos que participan en organismos como la Linux Foundation o la Linux Foundation Europe. Esa mezcla de actores, a veces con intereses muy distintos, genera tensiones, pero también una diversidad de aportaciones que resulta difícil replicar en modelos puramente cerrados.

Dentro de esta comunidad coexisten perfiles muy diferentes, desde el adolescente que empieza instalando una distro en su portátil antiguo hasta el ingeniero de una gran multinacional. Historias personales, como la de jóvenes que se iniciaron hace años con distribuciones libres y que hoy trabajan en grandes proyectos de programación, muestran cómo GNU/Linux actúa como puerta de entrada a una carrera profesional, pero también a una manera distinta de entender la tecnología: más compartida, más transparente y más enfocada al bien común.

Europa, independencia tecnológica y arquitecturas abiertas

En los últimos años, Europa ha puesto el foco en la necesidad de lograr una mayor autonomía tecnológica, y aquí Linux y el código abierto juegan un papel protagonista. El Viejo Continente aspira a dejar de depender tanto de arquitecturas y soluciones controladas por terceros países, apostando por procesadores y plataformas basadas en estándares abiertos que permitan auditar y adaptar la tecnología a sus propias necesidades estratégicas.

Diseñar procesadores y sistemas bajo arquitecturas abiertas no solo aumenta la independencia, sino que impulsa la competitividad y la capacidad de innovación. Proyectos relacionados con RISC-V y otras iniciativas de hardware abierto se combinan con sistemas operativos libres como Linux para crear una pila tecnológica sobre la que las empresas europeas puedan construir sin miedo a bloqueos, cambios de licencia o decisiones unilaterales de proveedores propietarios.

Las administraciones públicas de regiones como Andalucía o Extremadura ya demostraron hace años que se puede apostar de forma decidida por el software libre, migrando numerosos equipos de la administración a distribuciones basadas en Linux. En paralelo, asociaciones como Hispalinux han presionado para que las leyes sobre administración electrónica no discriminen a la ciudadanía según el software que utilicen, reclamando que los estándares abiertos estén plenamente reconocidos en la legislación.

En este contexto, los debates parlamentarios sobre proyectos de ley que afectan a la informática pública han ido incorporando referencias explícitas al uso de estándares abiertos. Algunos borradores han integrado todas las normas, incluyendo las abiertas, precisamente para no cerrar la puerta a GNU/Linux y otras soluciones libres. El objetivo es que un ciudadano no se vea obligado a usar un programa propietario concreto para relacionarse con la administración, lo que supondría una forma velada de exclusión digital.

También se han visto conflictos entre diferentes plataformas de software libre dentro del propio ecosistema español. Expertos como Alan Robertson, del Linux Technology Center, han llegado a sugerir que, para generar economías de escala, sería recomendable reducir el número de distribuciones a dos o tres en un país, aunque esa propuesta choque con la tradicional diversidad del mundo Linux. El equilibrio entre variedad y estandarización sigue siendo un tema caliente en cualquier discusión sobre adopción masiva.

Linux en educación, hardware asequible y dispositivos de bajo coste

Uno de los campos donde más se nota la importancia social de Linux es la educación. Existen miniordenadores de muy bajo coste, pensados en origen para mercados emergentes, que han acabado conquistando aulas de todo el mundo. Gracias a su bajo precio, su sencillez de uso y su orientación pedagógica, permiten que profesorado y alumnado aprendan programación, robótica o electrónica sin necesidad de grandes inversiones.

Placas diminutas que cuestan alrededor de 35 dólares han demostrado que se puede ofrecer un 50% más de potencia que modelos anteriores manteniendo la compatibilidad. Esto abre la puerta a proyectos creativos de todo tipo: servidores caseros, pequeños laboratorios de ciencias, estaciones meteorológicas escolares, reproductores multimedia personalizados o dispositivos IoT totalmente adaptados al currículo educativo. Linux es el sistema ideal para estas máquinas, porque su flexibilidad permite meter mano a todos los niveles.

Además, muchas de estas soluciones usan distribuciones específicamente pensadas para principiantes, con escritorios y herramientas diseñadas para que alguien sin experiencia previa pueda empezar a trastear sin miedo. Existen sistemas operativos gratuitos basados en código abierto que se esfuerzan cada vez más por ofrecer interfaces claras, asistentes de instalación sencillos y documentación amigable. La idea es derribar la etiqueta de que Linux es complicado y solo apto para gente muy técnica.

En paralelo, han surgido portátiles y dispositivos con Linux orientados a la enseñanza en países en desarrollo, donde el bajo coste, el enfoque educativo y la facilidad de uso son claves. Estos equipos permiten que miles de estudiantes accedan a herramientas digitales por primera vez, con un impacto directo en sus oportunidades de formación. Al no depender de licencias de software caras, los proyectos educativos pueden escalar con menos barreras económicas.

El ecosistema también ha dado pasos específicos en el terreno móvil. Proyectos como Ubuntu para teléfonos y otros sistemas basados en Linux han intentado llevar la filosofía del software libre a los smartphones y a los dispositivos conectados. Aunque no han logrado desbancar a Android e iOS, sí han demostrado que es posible imaginar otros modelos, donde el usuario tenga más control sobre el sistema y las aplicaciones, y no esté sometido a tiendas y políticas cerradas.

Tendencias técnicas: 64 bits, Rust, escritorios y sistemas inmutables

Debajo del ruido mediático, el mundo Linux está viviendo una especie de “demolición controlada” de sus cimientos, para reconstruirlos de forma más sólida y preparada para las próximas décadas. Esta transformación no es estridente, pero sí profunda: se están abandonando arquitecturas antiguas, se adoptan nuevos lenguajes de programación y se replantea cómo se organizan los sistemas de escritorio y los sistemas de archivos. Todo ello afecta de lleno al trabajo diario de desarrolladores, administradores y usuarios avanzados.

Uno de los cambios más visibles es el adiós definitivo a la arquitectura de 32 bits. Durante muchos años fue el caballo de batalla de la informática, omnipresente en ordenadores de sobremesa, portátiles veteranos y dispositivos de bajo consumo. Incluso proyectos como Firefox defendían mantener el soporte a 32 bits para alargar la vida del hardware y evitar una obsolescencia prematura. Sin embargo, la realidad es que la mayor parte del hardware actual ya es de 64 bits, y seguir arrastrando compatibilidad con plataformas antiguas supone un lastre.

El abandono progresivo de los 32 bits es, más que una cuestión práctica, una declaración de intenciones. La comunidad de desarrollo ya no está dispuesta a frenar el avance por mantener sistemas que se han quedado atrás. Al centrar esfuerzos en 64 bits, se simplifica el mantenimiento, se mejora el rendimiento y se abren puertas a optimizaciones difíciles de implementar si hay que soportar arquitecturas muy heterogéneas. El mensaje es claro: el futuro del ecosistema pasa por los 64 bits, sin matices.

Otro movimiento clave es la entrada de Rust en el corazón del ecosistema Linux. Este lenguaje de programación, diseñado para ofrecer la rapidez de C y C++ pero con una gestión de memoria mucho más segura, está ganando peso en proyectos críticos. Un ejemplo muy potente es el de Ubuntu, que ha puesto en marcha la reescritura de sus utilidades GNU Core —comandos básicos como ls, cp o mv— en Rust, con la vista puesta en una gran transición en futuras versiones como la 25.10.

Las ventajas de Rust son especialmente evidentes en términos de rendimiento y seguridad. Se han observado mejoras de hasta un 58% en velocidad respecto a las versiones originales en C, y al mismo tiempo se reducen drásticamente los errores típicos de gestión de memoria: desbordamientos de búfer, referencias colgantes, escrituras fuera de rango… fallos que han estado detrás de muchísimas vulnerabilidades críticas durante décadas. Rust fuerza a resolver este tipo de problemas en tiempo de compilación, sin penalizar el desempeño.

En el ámbito del escritorio, también se están produciendo movimientos que cambian las reglas del juego. Tradicionalmente, la secuencia era clara: primero se elegía la distribución (Fedora, Ubuntu, Arch, etc.) y luego el entorno gráfico (GNOME, KDE Plasma…). El proyecto KDE ha decidido darle la vuelta al planteamiento y trabaja en su propio sistema operativo, conocido como KDE Linux, pensado para ofrecer la máxima integración posible entre el escritorio y el resto de la plataforma.

KDE Linux se apoya en Arch Linux y, si te interesa, instalar Arch Linux sin depender de la terminal es una guía práctica útil para entender la base técnica en la que se apoya este tipo de proyectos. KDE Linux se apoya en Arch Linux y adopta el concepto de sistema inmutable. Podemos imaginarlo como un núcleo del sistema encapsulado en una “caja de cristal blindada” que las aplicaciones no pueden romper. Para ello, se apoya en tecnologías como el sistema de archivos Btrfs y la distribución de aplicaciones mediante contenedores aislados con formatos como Flatpak y Snap. Desde el punto de vista del usuario, esto reduce los riesgos de que una instalación o una actualización dañen el sistema base.

Aunque KDE Linux sigue siendo experimental, que un proyecto tan consolidado se lance a estas aventuras indica que se está cocinando un cambio de fondo. El objetivo es lograr sistemas más estables, más fáciles de mantener y con una experiencia pulida de serie, sin la sensación de tener que “montarlo todo a mano” tras la instalación. La línea entre las distribuciones tradicionales y los nuevos enfoques inmutables se irá difuminando, y el usuario medio saldrá ganando con entornos más predecibles.

Sistemas de archivos, autocorrección y alta disponibilidad

En el terreno de los sistemas de archivos, Linux también se está moviendo hacia modelos más resilientes. XFS, ampliamente utilizado en entornos de producción donde la fiabilidad es vital, ha sido durante mucho tiempo sinónimo de robustez, pero con una limitación importante: cuando se detectaba una corrupción de datos, lo habitual era tener que parar el sistema para ejecutar herramientas de reparación. En servidores críticos, ese tiempo de inactividad se traduce en pérdidas de dinero y de confianza.

Tras un largo periodo de pruebas en escenarios reales, las próximas versiones LTS del kernel habilitarán por defecto la verificación y reparación en línea para XFS. Esto significa que el sistema será capaz de detectar inconsistencias y corregirlas mientras sigue funcionando, sin necesidad de apagar servicios ni desmontar volúmenes. Es como arreglar un coche en marcha sin detenerlo en el taller, lo que para muchas empresas es un cambio radical en la forma de gestionar su infraestructura.

Esta capacidad acerca a XFS a la filosofía de sistemas de archivos “autocorrectores” que ya ofrecían otros como ZFS o Btrfs, muy populares en entornos más orientados al usuario o a almacenamiento especializado. Sin embargo, XFS sigue siendo una pieza clave en muchos centros de datos, por lo que su mejora repercute directamente en la percepción de Linux como plataforma fiable para cargas de trabajo críticas.

Para los administradores de sistemas, estas novedades suponen menos trasnochar por mantenimientos programados, menos ventanas de caída de servicio y una mayor tranquilidad a la hora de actualizar o ampliar infraestructuras, además de facilitar la posibilidad de automatizar copias de seguridad con rsync y cron. Unido a otros avances del kernel, refuerza la idea de que Linux no solo es potente y flexible, sino que está cada vez más orientado a la automatización y a la resiliencia, algo esencial en un mundo donde los servicios se esperan “siempre encendidos”.

En un contexto donde se registran cifras tan preocupantes como una media de 13 vulnerabilidades diarias a nivel global, la combinación de sistemas de archivos más inteligentes, lenguajes más seguros como Rust y procesos de desarrollo abiertos y auditables se convierte en un pilar para mantener a raya los riesgos; de la misma forma, la adopción de soluciones de aislamiento mejora la seguridad, por ejemplo usar Firejail en Linux para contener aplicaciones potencialmente peligrosas. No hay seguridad perfecta, pero sí se puede levantar un ecosistema donde los errores se detecten antes, se corrijan más rápido y se compartan las lecciones aprendidas.

Linux en el escritorio: cuota modesta, influencia enorme

El viejo chiste de que “este sí será el año de Linux en el escritorio” sigue sin cumplirse al pie de la letra, pero la realidad es que GNU/Linux no deja de ganar terreno como sistema de uso personal. En 2024, la cuota de mercado en equipos de escritorio ha alcanzado en torno al 4%, una cifra todavía modesta en comparación con otros sistemas, pero que marca un hito histórico y, sobre todo, una tendencia de crecimiento lento pero constante.

Más allá de la cuota, 2024 ha sido un año de consolidación y mejora importante en la experiencia de usuario. Los dos entornos de escritorio más populares, GNOME y KDE Plasma, han lanzado versiones muy potentes: GNOME 46 y KDE Plasma 6. Ambas apuestan por una integración más profunda con Wayland como servidor gráfico por defecto, ofreciendo sesiones más fluidas, seguras y modernas, con mejor soporte para pantallas de alta resolución y configuraciones complejas.

GNOME 46 se centra en la eficiencia, el rendimiento y la accesibilidad. Incorpora de forma predeterminada Wayland, pule la interfaz con un diseño más actual, ajusta las opciones de configuración para que la personalización sea más directa y mejora herramientas clave como la búsqueda de aplicaciones y la gestión del sistema. La experiencia general es la de un escritorio menos recargado, más coherente y con especial atención a que todo funcione fino desde el primer arranque.

KDE Plasma 6, por su parte, da un salto de calidad al migrar a Qt 6 y reforzar la sesión Wayland. Entre sus novedades destacan el soporte para HDR, que permite aprovechar al máximo pantallas modernas con mayor contraste y gama de colores, y una serie de ajustes en la interfaz y en los paneles de configuración que simplifican la vida al usuario. Aplicaciones emblema del ecosistema KDE, como el gestor de archivos Dolphin, la herramienta de capturas Spectacle o el editor de texto Kate, han recibido mejoras que se notan en el día a día.

A esto se suman las nuevas versiones de distribuciones consolidadas como Fedora o Ubuntu, incluyendo las esperadas ediciones LTS de la distro de Canonical, muy valoradas por quienes buscan estabilidad a largo plazo. La combinación de escritorios pulidos, gestores de audio y vídeo modernos como PipeWire, y una integración cada vez mejor de los drivers gráficos y de hardware hace que el “Linux de escritorio” ya no sea un territorio hostil para quien viene de otros sistemas.

Es importante subrayar que el escritorio GNU/Linux es, probablemente, el ecosistema más rico en variedad del mercado. Además de GNOME y KDE Plasma, existen numerosos entornos ligeros y gestores de ventanas minimalistas que permiten adaptar por completo la experiencia a gustos y necesidades: desde configuraciones ultraligeras para equipos muy antiguos hasta entornos recargados de efectos visuales para quienes disfrutan afinando cada detalle. Si te interesa elegir una opción ligera, consulta qué entorno de escritorio ligero elegir.

Comunidades, conferencias y cultura del desarrollo abierto

El crecimiento de Linux no se entiende sin su tejido comunitario y sin los eventos que lo alimentan. Conferencias internacionales sobre software libre reúnen cada año a expertos de decenas de países, que comparten avances, casos de éxito y problemas reales en producción. Foros como la Conferencia Mundial de Software Libre celebrada en ciudades como Málaga son puntos de encuentro donde administraciones públicas, empresas y activistas debaten sobre el futuro del código abierto.

En paralelo, figuras clave del movimiento, como Richard Stallman, siguen recorriendo universidades y centros culturales para hablar de “sociedad digital libre”, llenando paraninfos con cientos de jóvenes que quieren entender qué hay detrás de términos como libertad de software, copyleft o neutralidad tecnológica. Estas charlas ayudan a trasladar el debate desde lo puramente técnico a cuestiones éticas, políticas y sociales.

Otros protagonistas de la escena, como Jon “Maddog” Hall, responsable de Linux International, o líderes de proyectos concretos, aportan una visión más pegada al terreno empresarial y a la adopción en gran escala. Sus entrevistas suelen girar en torno a cómo convencer a directivos y responsables de TI de que apostar por Linux y el código abierto no es solo una cuestión ideológica, sino una decisión racional en términos de coste, seguridad y capacidad de adaptación.

El propio Linus Torvalds, aunque sigue al frente del desarrollo del kernel desde 1991, es consciente de que el proyecto necesita resiliencia organizativa. Por eso existe un protocolo de emergencia y una estructura de mantenedores que permite que el flujo de trabajo continúe aunque él no pueda liderarlo en algún momento. Linux ya no depende de una sola persona, sino de una red de contribuyentes respaldada por fundaciones, empresas y comunidades distribuidas por todo el mundo.

A veces, las noticias se centran en el lado más humano de estos líderes: por ejemplo, cuando se ha comentado que el propio Torvalds ha decidido dejar en segundo plano algunos proyectos profesionales para trabajar su manera de relacionarse con otros desarrolladores, o cuando se analizan las disculpas públicas de ejecutivos como Satya Nadella por declaraciones polémicas en otros ámbitos, como la brecha salarial entre hombres y mujeres. Todo ello demuestra que el ecosistema tecnológico también está atravesado por debates sobre cultura laboral, diversidad e inclusión.

Mirando todo este panorama, desde los servidores que sostienen internet hasta los miniordenadores de 35 dólares en las aulas, pasando por los escritorios modernos, las arquitecturas abiertas y las nuevas herramientas como Rust, se entiende por qué Linux se ha colado en casi todas nuestras interacciones tecnológicas. Puede que el famoso “año de Linux en el escritorio” nunca llegue tal y como algunos lo imaginaron, pero lo que sí es cierto es que GNU/Linux se ha convertido en la opción más inteligente en muchos ámbitos: estable, seguro, adaptable y respaldado por una comunidad global que no ha perdido las ganas de innovar.

Redactor apasionado del mundo de los bytes y la tecnología en general. Me encanta compartir mis conocimientos a través de la escritura, y eso es lo que haré en este blog, mostrarte todo lo más interesante sobre gadgets, software, hardware, tendencias tecnológicas, y más. Mi objetivo es ayudarte a navegar por el mundo digital de forma sencilla y entretenida.