- Inimapa ng GPU passthrough (vDGA/VMDirectPath I/O) sa VMware ang isang buong pisikal na GPU sa isang VM upang makamit ang halos katutubong pagganap.

- Ang paggamit nito ay nangangailangan ng mahigpit na mga kinakailangan ng hardware (VT‑d/AMD‑V, IOMMU, MMIO 64‑bit) at EFI/UEFI firmware sa virtual machine.

- Ang pag-enable sa vDGA ay nagreresulta sa pagkawala ng mga pangunahing feature ng vSphere tulad ng vMotion, DRS, at mga snapshot sa VM gamit ang GPU sa passthrough mode.

- Kung ikukumpara sa vGPU at iba pang mga solusyon, inuuna ng vDGA ang nakalaang pagganap kaysa sa kakayahang umangkop at ang kakayahang ibahagi ang GPU sa pagitan ng maraming VM.

Pagkonekta ng isang pisikal na GPU nang direkta sa isang virtual machine sa VMware Isa ito sa mga pagbabagong nakakagawa ng malaking pagkakaiba kapag gumagamit ng mabibigat na graphics load. IA o 3D rendering. Ang paglipat mula sa isang emulated graphics card patungo sa isang direktang access sa pamamagitan ng passthrough (vDGA / VMDirectPath I/O) ay maaaring magpalapit sa performance ng VM sa isang pisikal na makina, ngunit kapalit nito ay nagdaragdag ito ng ilang mga kinakailangan at limitasyon na dapat maging napakalinaw bago magsimula.

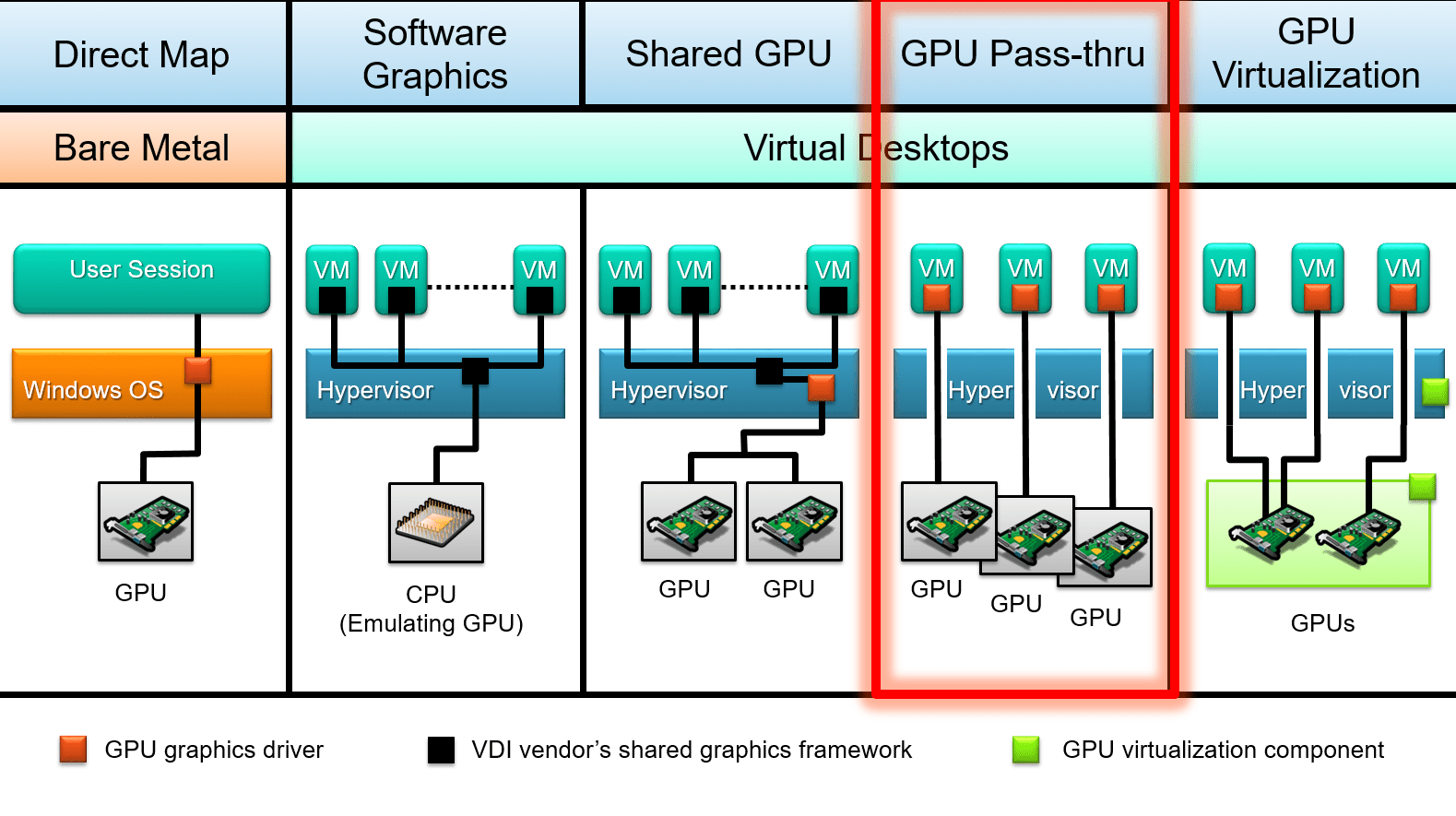

Bukod pa rito, sa kasalukuyang ecosystem, maraming paraan ng paggamit ng GPU sa mga virtualized na kapaligiran ang umiiral: Dedicated passthrough, shared vGPU, at mga teknolohiyang tulad ng BitFusion o GPU partitioningAng pag-unawa sa ginagawa ng bawat isa, sa anong mga pagkakataon ito naaangkop, at kung paano ito kino-configure sa vSphere/ESXi (at kung paano ito nauugnay sa mga katulad na teknolohiya tulad ng Hyper-V DDA) ay susi upang hindi mapunta sa isang dead end sa hardware o sa napiling bersyon ng hypervisor.

Ano ang GPU passthrough (vDGA / VMDirectPath I/O) sa VMware

GPU passthrough sa VMware, na kilala rin bilang vDGA o VMDirectPath I/OIto ay isang paraan ng operasyon kung saan ang isang pisikal na graphics card na naka-install sa ESXi host ay direktang itinatalaga sa isang virtual machine. Sa halip na gumamit ng graphics adapter na ginagaya ng hypervisor, nakikita ng guest operating system ang GPU na parang nakasaksak ito sa isang pisikal na motherboard.

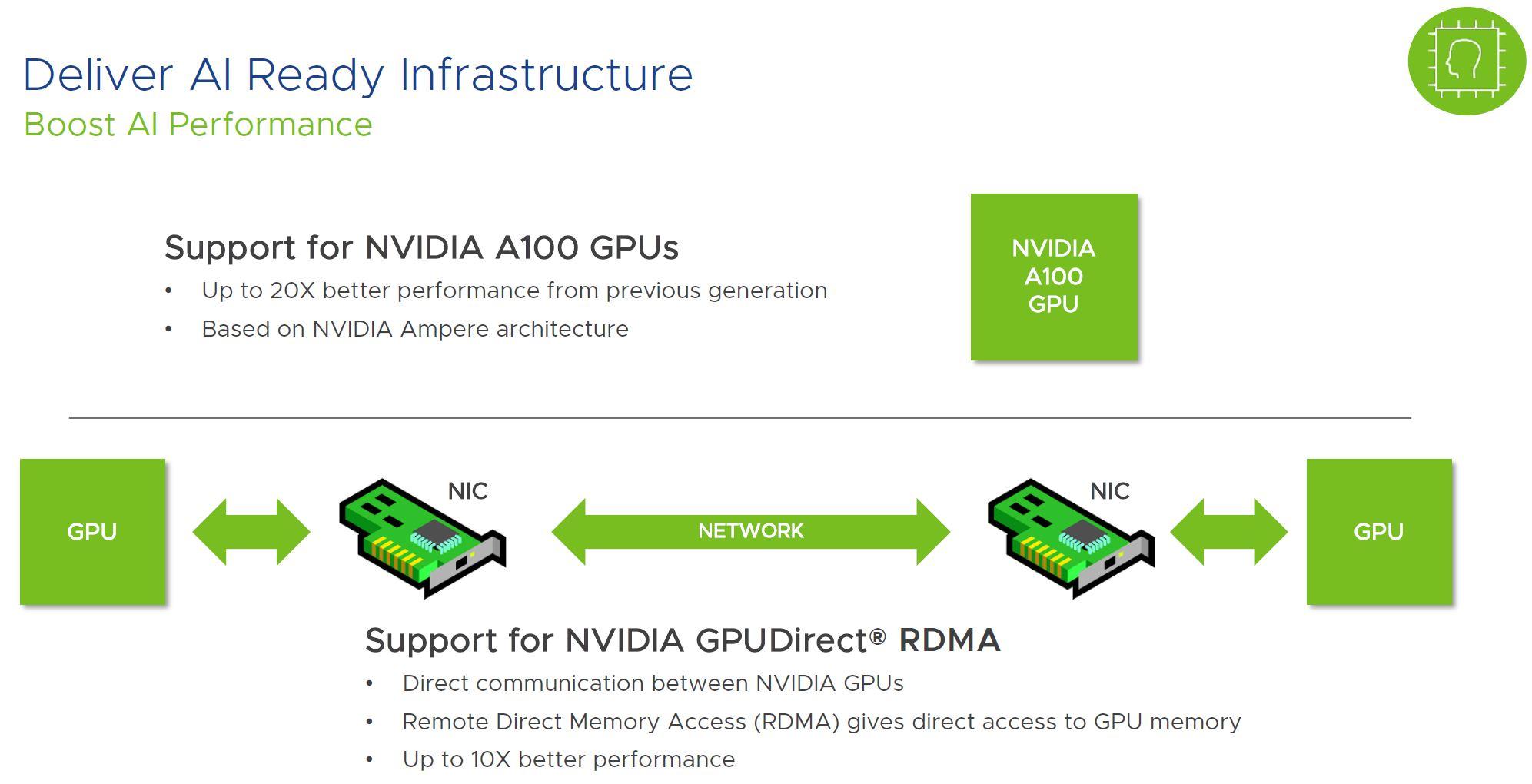

Ang shortcut na ito ay nagbibigay-daan sa VM na samantalahin lahat ng lakas ng graphics chip, ang video memory nito at mga advanced na tampok tulad ng CUDA, OpenCL, Direct3D, at OpenGL nang native, na may napakakaunting dagdag na overhead mula sa hypervisor. Sa mga pagsubok sa laboratoryo ng VMware, ang pagbaba ng performance na humigit-kumulang 4-5% ay karaniwang naiuulat kumpara sa pagpapatakbo ng parehong GPU sa bare metal.

Sa pagsasagawa, ang paggamit ng GPU passthrough ay nangangahulugan na Ang card na iyon ay ganap na nakatuon sa iisang virtual machine.Walang detalyadong alokasyon ng mapagkukunan sa pagitan ng maraming VM, ni walang third-party software layer na nilo-load sa ESXi upang ibahagi ang graphics card, hindi tulad ng nangyayari sa mga solusyon ng vGPU tulad ng NVIDIA GRID.

Mahalagang maiba ang pamamaraang ito mula sa iba pang mga paraan ng paggamit ng mga GPU sa virtualization, tulad ng NVIDIA vGPU (ibinahaging vGPU), RemoteFX/partitioning sa mga solusyong uri ng Hyper-V o BitFusion, na naglalayong ipamahagi ang isang GPU o isang pool ng mga GPU sa maraming makina na may iba't ibang pamamaraan ng virtualization o remote redirection.

Kapag pinag-uusapan natin ang vDGA sa mundo ng VMware, mahalagang inilalarawan natin ito direktang pagtatalaga ng PCIe device ng GPU sa VM gamit ang VMDirectPath I/O, kasama ang lahat ng mabuti (pagganap) at masama (mga paghihigpit sa mobility at mataas na availability) na kaakibat nito.

Mga Bentahe ng Paggamit ng GPU Passthrough sa vSphere

Ang pangunahing dahilan ng paglipat sa vDGA ay dahil Ang pagganap ng graphics at computing ay halos kapareho ng sa isang pisikal na computer.Sa pamamagitan ng pag-aalis ng malaking bahagi ng virtualization layer para sa PCIe device na iyon, nawawala ang mga karaniwang bottleneck ng emulate GPU at mas maayos na makakapagtrabaho ang VM sa mga laro, 3D application, o AI engine.

Ito ay lalong kapansin-pansin sa mga sitwasyon kung saan ang mga integrated GPU o ang default na emulate virtual graphics card ay hindi sapat: Mas mahusay na disenyo ng grapiko, CAD, 3D modeling at rendering, pag-edit ng video, animation, at pagbuo ng laroMahalaga rin ito sa pagsasanay ng mga modelo ng machine learning at mga workload ng AI na lubos na umaasa sa CUDA o mga katumbas nito.

Isa pang malinaw na bentahe ay ang mas flexible na paggamit ng hardware sa antas ng data center. Sa halip na magkaroon ng pisikal na workstation bawat user o bawat proyektoPosibleng maglaan ng isang malaking ESXi host sa ilang VM, bawat isa ay may sariling GPU sa passthrough, at makipagsabayan sa mga iskedyul o peak demand.

Sa ilang partikular na kapaligiran, lalo na kung ang mga server na may mga libreng PCIe slot ay magagamit na, ang gastos bawat gumagamit o bawat proyekto Maaaring mas mababa ito kaysa sa pagpapanatili ng isang fleet ng malalakas na pisikal na workstation, lalo na kung ang graphics card ay hindi kinakailangan 24 oras sa isang araw at maaaring muling i-configure ayon sa mga panahon ng matinding trabaho.

Panghuli, mayroon ding hindi direktang benepisyo sa mga tuntunin ng seguridad at operasyon: sa pamamagitan ng pagpapanatili ng mga workload ng graphics sa loob ng mga nakahiwalay na virtual machineKung may magkamali (isang exploit, isang problematikong driver, isang masamang configuration) mas madaling pigilan ang epekto, bumalik sa isang nakaraang snapshot o mag-restore mula sa isang backup, hangga't ang mga limitasyon ng passthrough, na ating titingnan mamaya, ay iginagalang.

GPU passthrough kumpara sa vGPU at iba pang alternatibo

Sa loob ng VMware ecosystem, mayroong ilang mga paraan upang magamit ang isang graphics card, at hindi lahat ng mga ito ay nangangailangan ng paglalaan nito nang buo sa isang VM. Ang pinakakilala ay: vDGA / VMDirectPath I/O, vGPU (NVIDIA GRID o iba pa) at mga solusyon sa remote access/computing tulad ng BitFusion.

Sa direktang passthrough mode (vDGA), ang GPU ay inilalaan eksklusibo sa isang virtual machineAng mga compute core at VRAM ay hindi pinagsasaluhan sa pagitan ng maraming VM, at ang papel ng hypervisor ay halos wala nang iba pa maliban sa pagruruta ng PCIe device papunta sa guest. Ito ang pinakamadaling opsyon na maunawaan at ang pinakakamukha ng isang pisikal na server na may nakalaang graphics card.

Sa pamamaraang vGPU, ang espesyalisadong software (halimbawa NVIDIA GRID vGPU sa VMware vSpherePinangangasiwaan nito ang virtualization ng GPU sa antas ng controller at inilalantad ang mga virtual na instance ng GPU na maaaring italaga sa maraming VM nang sabay-sabay. Ang bawat guest machine ay nakakakita ng isang "hiwa" ng GPU na may garantisadong o ibinahaging mga mapagkukunan.

Pinapayagan ng mga vGPU ang maraming virtual desktop o server na magbahagi ng iisang graphics card, na lubhang kapaki-pakinabang sa VDI, magaan at pinabilis na kapaligiran sa opisina, mga front-line graphic workstation sa tingian o hospitalityo mga senaryo kung saan ang pinakamataas na paggamit ng graphics ay hindi pantay sa mga gumagamit. Bilang kapalit, mayroong ilang overhead, at ang parehong pinakamataas na pagganap ay hindi nakakamit tulad ng sa isang buong pisikal na GPU na nakatuon sa isang VM.

Mayroon ding mga solusyon tulad ng BitFusion Flexdirect at mga katulad na teknolohiyana nagpapahintulot sa mga GPU na magamit sa network mula sa iba't ibang VM, mainam para sa mga workload ng AI at HPC kung saan ang GPU ay gumaganap nang higit pa bilang isang remote computing resource kaysa bilang isang video card para sa graphical interface ng user.

Pumili sa pagitan ng vDGA, vGPU, o isang remote GPU model Depende ito kung kailangan mong ganap na gamitin ang isang GPU para sa isang makina (passthrough), kung gusto mong ipamahagi ang isang mamahaling card sa maraming user na may katamtamang workload (vGPU), o kung ang susi ay ang pagbuo ng isang pool ng mga GPU para sa distributed computing (BitFusion at mga katulad nito).

Mga kinakailangan sa hardware para sa paggamit ng vDGA sa ESXi

Bago magplano ng pag-deploy ng GPU passthrough sa VMware, kailangan mong tiyakin na ang Ang hardware platform ay nakakatugon sa isang serye ng mga kundisyon na higit pa sa "pagkakabit ng graphics card sa server".

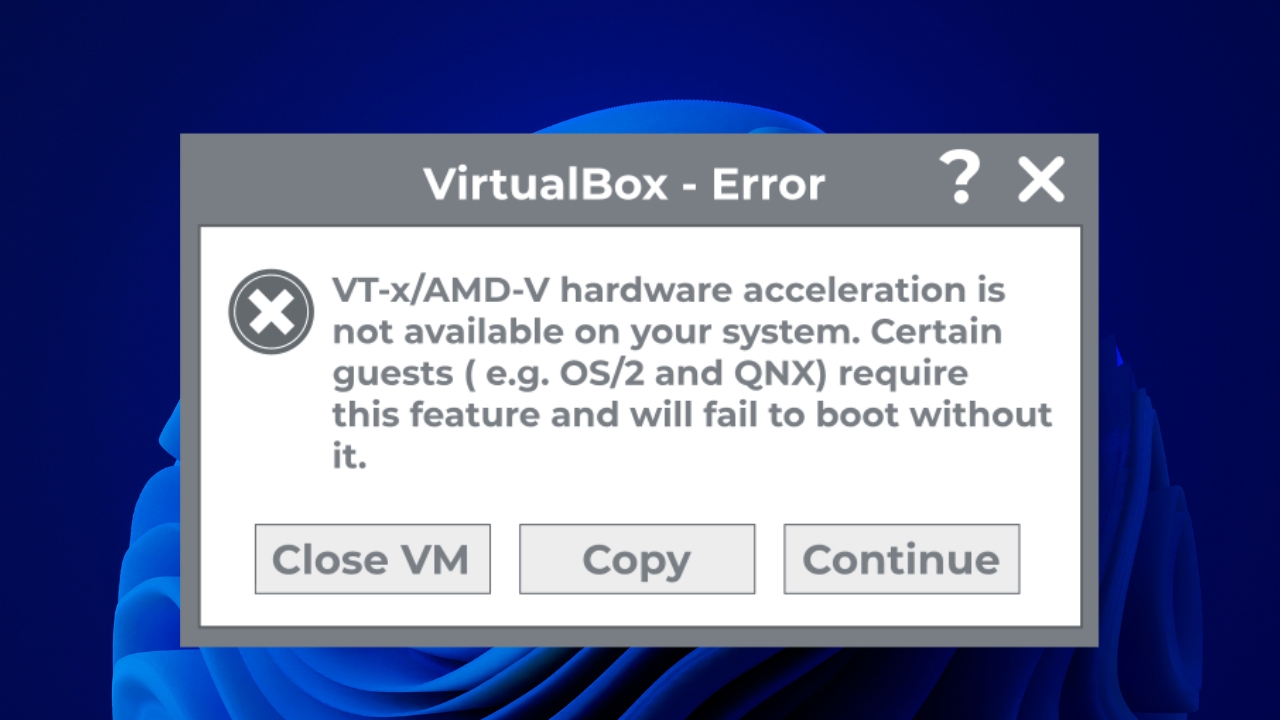

Una, dapat suportahan ng processor at chipset ng ESXi host motherboard ang birtwalisasyon gamit ang IOMMU. Sa Intel Nakakamit ito sa pamamagitan ng Intel VT-x kasama ang VT-dy, at sa pamamagitan ng AMD sa pamamagitan ng AMD-V kasama ang IOMMU. Karaniwang may mga partikular na opsyon ang BIOS/UEFI ng server para dito. i-activate ang mga extension ng virtualization ng I/O.

Pangalawa, kailangan mong suriin na ang support plate Pagmamapa ng memorya ng MMIO na higit sa 4 GB (minsan ay may label na "Above 4G decoding", "memory mapped I/O above 4G" o katulad). Ito ay lalong mahalaga sa mga high-end na GPU tulad ng Tesla, P100, V100 at mga katumbas nito, na nagdedeklara ng napakalaking rehiyon ng memorya sa kanilang BAR (Base Address Registers).

Ang ilan sa mga high-end card na ito ay maaaring mag-map mahigit sa 16 GB na espasyo ng MMIOSamakatuwid, bukod sa paglalaro ng BIOSPagkatapos, kailangang isaayos ang ilang partikular na parameter sa mga advanced na setting ng VM sa vSphere upang makapag-boot ito gamit ang GPU na iyon nang walang mga error sa kakulangan ng mga resources.

Siyempre, ang GPU mismo ay dapat tugma sa platform ng server at susuportahan ng host manufacturer (Dell, HPE, Lenovoatbp.) kapag ginamit sa passthrough mode. Sa pagsasagawa, gumagana ang karamihan sa mga modernong PCIe GPU, ngunit ipinapayong suriin ang mga listahan ng compatibility, lalo na para sa mga GRID card o mga bagong-bagong modelo.

Mga kinakailangan sa software at pagiging tugma ng bersyon

Sa antas ng software, mahalagang maging malinaw na Sinusuportahan ng VMware ang vDGA sa vSphere 6.x at mga mas bagong bersyonGayunpaman, may ilang mga gumagamit na nag-ulat ng mga partikular na problema sa ilang mga kumbinasyon ng hardware (halimbawa, mga NVIDIA GRID GPU sa mga Dell R720 server na may ESXi 6.x).

Sa mga ganitong pagkakataon, karaniwan nang makakita ng mga error tulad ng "ginagamit na ang device" o mga sintomas na nagmumungkahi na Tumigil sa paggana ang Passthrough matapos mag-upgrade mula ESXi 5.5 patungong 6.xsamantalang sa katotohanan ay tungkol ito sa mga partikular na bug, mga pagbabago sa pamamahala ng PCI device o mga driver, sa halip na isang opisyal na pagbawi ng suporta.

Ang guest operating system na gagamit ng GPU sa passthrough ay dapat mayroong mga opisyal na driver ng tagagawa na naka-install sa loob ng VM (NVIDIA, AMD, Intel), dahil ang ESXi ay hindi naglo-load ng anumang partikular na driver para sa card na iyon kapag gumagamit ng VMDirectPath I/O; inilalantad lang ng hypervisor ang device sa bisita.

Bukod pa rito, dapat i-configure ang VM para mag-boot in EFI o UEFI mode kapag gumagamit ng mga GPU na nagdedeklara ng malalaking rehiyon ng memorya ng MMIO. Mahalaga ang detalyeng ito: ang maling firmware ng VM ay maaaring humantong sa mga pagkabigo boot o kaya naman ay hindi nag-i-initialize nang tama ang GPU mula sa guest operating system.

Sa panig ng kliyente, kung ang pag-access sa VM ay nangyayari sa pamamagitan ng Remote desktop (RDP o iba pang mga protocol)Kakailanganing i-activate ang mga naaangkop na patakaran upang magamit ng guest system ang hardware graphics adapter sa mga remote session at hindi ma-stuck sa isang generic na driver na walang acceleration.

Pag-configure ng ESXi host para magamit ang GPU sa passthrough mode

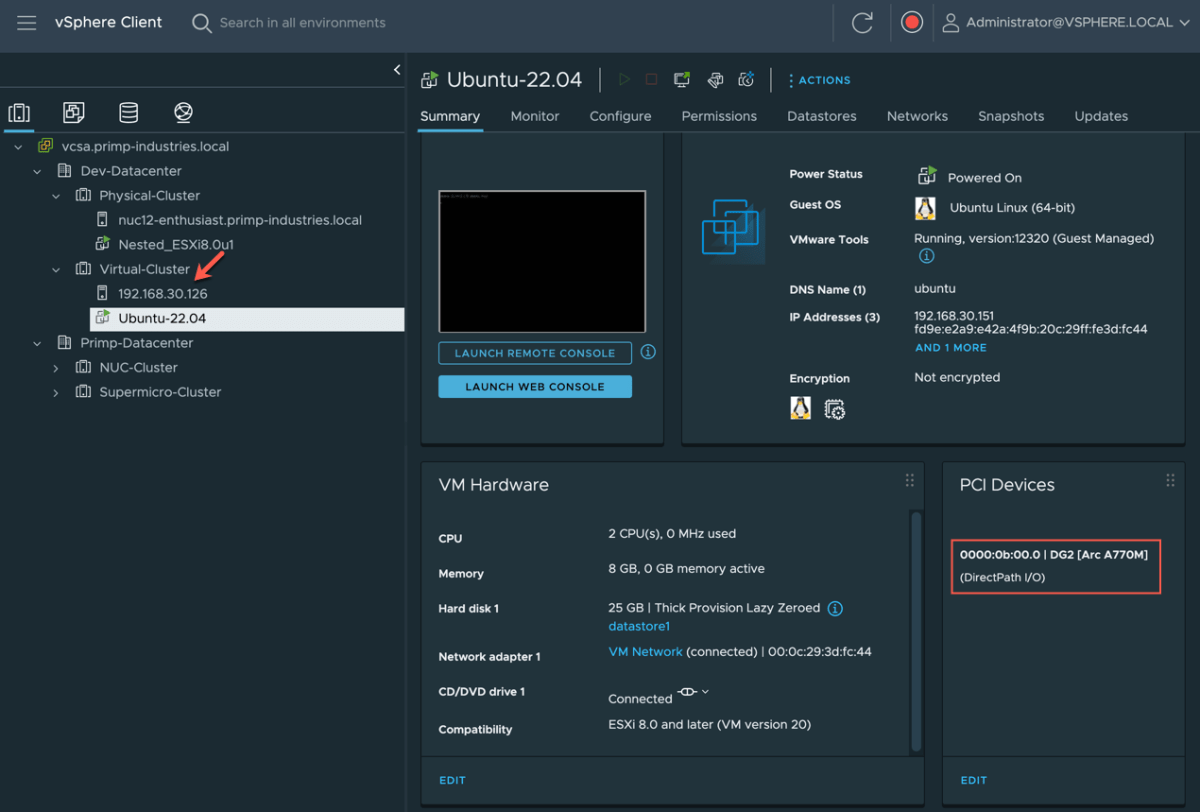

Ang unang praktikal na hakbang ay ang paghahanda ng vSphere/ESXi server para ilantad ang GPU bilang isang DirectPath I/O deviceKabilang dito ang pag-access sa BIOS, pagsuri sa imbentaryo ng PCI sa host, at pagmamarka sa card upang maitalaga ito sa mga VM.

Kung ang GPU ay nangangailangan ng malalaking rehiyon ng memorya ng MMIO (16 GB o higit pa), kailangan mong tingnan ang BIOS/UEFI ng server para sa mga opsyon tulad ng "Pag-decode na higit sa 4G" o "Paghawak ng resource na PCI 64‑bit na higit sa 4G" at i-activate ang mga ito. Ang partikular na pangalan ay nag-iiba depende sa tagagawa, ngunit kadalasan ay matatagpuan ito sa seksyon ng mga setting ng PCI o advanced resources.

Kapag nasimulan na ang ESXi gamit ang mga setting na ito, sa vSphere client, maaari kang pumunta sa kaukulang host at i-access ang "I-configure → Hardware → Mga PCI Device → I-edit" Para makita ang listahan ng mga natukoy na PCI device, makikita mo ang NVIDIA, AMD, o mga katulad na card kasama ang iba pang PCI hardware ng server.

Kung hindi pa naka-enable ang GPU para sa DirectPath I/O, lagyan lang ng tsek ang kahon. kahon para sa pagpasok sa inyong pasukan sa loob ng listahang iyon. Kapag sine-save ang mga pagbabago, hihilingin sa iyo ng vSphere na i-restart ang host upang ilapat ang configuration, dahil kailangang i-reserve at ihanda ng hypervisor ang device para mailipat sa mga VM.

Pagkatapos ng pag-restart, pagbalik sa seksyon "I-configure → Hardware → Mga PCI Device" May lalabas na window na may pamagat na “DirectPath I/O PCI Devices Available to VMs”, na naglilista ng lahat ng device na naging available na gamitin sa mga virtual machine, kabilang ang mga GPU at, sa maraming pagkakataon, mga advanced network adapter tulad ng Mellanox.

Paghahanda at pag-configure ng virtual machine

Kapag handa na ang host, ang susunod na hakbang ay ang paggawa o pag-adapt ng virtual machine na gagamit ng GPU. Ang unang bagay ay siguraduhin na ang VM Ito ay ginawa gamit ang angkop na EFI/UEFI firmware., lalo na sa mga sitwasyong may mga high-end na GPU at mataas na MMIO.

Sa vSphere client, piliin lamang ang VM, pumunta sa "I-edit ang Mga Setting → Mga Opsyon sa VM → Mga Opsyon sa Pag-boot" at beripikahin na ang "EFI" o "UEFI" ay napili sa field na "Firmware". Kung hindi, kakailanganin itong baguhin (at sa ilang mga kaso, ang VM o operating system ay kailangang muling likhain kung hindi nito sinusuportahan ang hot-swapping na ito).

Kapag gumagamit ng passthrough sa mga card na may mahigit 16 GB na espasyo ng MMIO, ipinapayong isaayos ang ilang advanced na parameter sa VM configuration, na maaaring ma-access mula sa "I-edit ang Mga Setting → Mga Opsyon sa VM → Advanced → Mga Parameter ng Configuration → I-edit ang Configuration"Doon ka maaaring magdagdag ng mga key na may kaugnayan sa pciPassthru upang kontrolin kung paano nakalaan ang espasyo ng address.

Sa partikular, ang paggamit ng 64-bit MMIO ay karaniwang pinagana at ang laki ay tinukoy para sa rehiyong iyon, na kinakalkula mula sa Ilang high-end GPU ang ilalaan sa VM?Ang karaniwang tuntunin ay karaniwang i-multiply ang 16 sa bilang ng mga GPU at i-round off ang resulta sa susunod na power na dalawa (halimbawa, ang dalawang ganoong GPU ay magkakaroon ng 64 GB ng 64-bit MMIO).

Matapos isaayos ang mga parameter na ito, isasagawa ang pag-install o mabeberipika na ang Sinusuportahan ng guest operating system ang EFI/UEFI at kayang pangasiwaan ang laki ng memory at GPU na pinag-uusapan.Sa puntong ito, ang graphics card ay hindi pa nakakonekta sa VM; ang kapaligiran ay inihahanda lamang upang, kapag nakakonekta na, ang lahat ay magsisimula nang walang mga error dahil sa kakulangan ng mga mapagkukunan o hindi tugmang firmware.

Italaga ang GPU sa VM gamit ang VMDirectPath I/O

Kapag namarkahan na ng host ang GPU bilang available para sa DirectPath I/O at na-configure nang tama ang VM, oras na para pisikal na iugnay ang card sa virtual machine na iyonDapat gawin ang hakbang na ito nang ganap na naka-off ang VM.

Mula sa vSphere client, piliin ang VM at ilagay ang "I-edit ang Mga Setting" para suriin ang virtual hardwareSa listahan ng device, maaari mong i-click ang "Magdagdag ng Bagong Device" at piliin ang "PCI Device" kung wala pa sa listahan ang GPU. Pagkatapos, piliin ang PCI device na naaayon sa graphics card (halimbawa, ang NVIDIA o AMD card na na-detect sa host).

Kapag na-save na ang configuration, ipapakita ng VM ang ganito sa hardware nito "PCI Device 0" na nauugnay sa partikular na GPUMula sa puntong ito, kapag nagsimula na ang guest operating system, makakakita ito ng karagdagang PCIe adapter na naaayon sa pisikal na graphics card.

Mahalaga na ang virtual machine ay mayroong inilaan ang lahat ng memorya na inilaan ditoSa vSphere, ito ay naka-configure sa “Edit Settings → Virtual Hardware → Memory”, na itinatakda ang value na “Reservation” sa dami ng RAM na naka-configure para sa VM. Kung wala ang buong reservation na ito, maaaring mabigo ang PCI passthrough o makaranas ng mga pasulput-sulpot na problema.

Pagkatapos i-on ang VM, sa isang sistema Linux Maaaring mapatunayan ang presensya ng GPU gamit ang comandos uri lspci | grep nvidia, habang sa Windows ay lilitaw ito sa ilalim ng “Display adapters” sa Device ManagerNormal lang na makita ang parehong VMware emulated graphics adapter at ang nakalaang pisikal na GPU.

Ang huling hakbang ay ang pag-install ng mga sumusunod sa guest device: driver Mga opisyal ng tagagawa ng GPU, na-download mula sa mga website ng NVIDIA, AMD o Intel, iniiwasan ang pag-asa sa mga generic na driver o iyong mga ibinigay Windows Updatena maaaring hindi na-optimize para sa mga senaryo ng passthrough.

Mga limitasyon at tampok ng vSphere na hindi gumagana sa vDGA

Ang B na bahagi ng GPU passthrough sa VMware ay iyon Nawala ang ilang mga advanced na tampok ng platform sa pamamagitan ng direktang paglalaan ng isang pisikal na device sa isang VM. Iyan ang kapalit para sa halos katutubong performance na iyon.

Ang unang malaking sakripisyo ay vMotion at DRSHindi maaaring i-hot-migrate ang isang virtual machine na may GPU sa passthrough mode sa ibang host dahil pisikal na naka-lock ang card sa orihinal na server. Hindi rin magagamit ang mga automated load balancing policy na kinabibilangan ng paglipat ng VM sa pagitan ng mga host sa cluster.

Mga tampok tulad ng Mga tradisyonal na snapshot o ilang partikular na mekanismo ng mataas na availability para sa partikular na VM na iyon. Dahil umaasa ito sa napaka-partikular na pisikal na hardware, nakompromiso ang kakayahang i-freeze at ibalik ang mga kumplikadong estado.

Isa pang aspeto na dapat isaalang-alang ay, sa ganitong paraan, Ang GPU ay hindi ibinabahagi sa pagitan ng maraming VMKung maraming desktop o server na may graphics acceleration ang kailangan sa iisang makina, isang card kada VM ang kakailanganin, o kaya naman, maaaring gamitin ang vGPU model kung saan ang card ay naka-virtualize sa maraming pagkakataon.

Sa panig ng suporta, maaaring may mga partikular na kaso kung saan Ang ilang kombinasyon ng hardware at driver ay maaaring magdulot ng mga problemaGaya ng naobserbahan ng ilang user noong nag-a-upgrade sa ESXi 6.x gamit ang mga NVIDIA GRID card sa mga partikular na server (hal., Dell R720), ipinapayong suriin ang dokumentasyon ng tagagawa ng VMware at GPU sa mga sitwasyong ito, at buksan ang mga support case kung kinakailangan.

Panghuli, dapat tandaan na ang ilang mga teknolohiya o serbisyo na nakikipag-ugnayan sa mga graphics, tulad ng mga remote desktop, mga subsystem ng Linux sa Windows, o mga advanced na tampok ng operating systemMaaari silang makagambala o magdulot ng mga error na "Code 43" sa mga driver ng NVIDIA kung matukoy ng mga ito na nagtatrabaho ka sa loob ng isang VM na may GPU passthrough.

Pagdaan ng GPU sa iba pang mga hypervisor: parallel sa Hyper-V

Bagama't ang pokus dito ay sa VMware, mahalagang maunawaan kung paano iba pang mga hypervisor (halimbawa virtualisasyon gamit ang KVM at virt-manager) tinutugunan ang parehong pangangailangang maglaan ng pisikal na GPU sa isang VMdahil nagbabago ang mga terminolohiya at kagamitan, ngunit ang pinagbabatayang ideya ay magkatulad.

Sa Hyper-V, ang katumbas ng VMware VMDirectPath I/O ay ang direktang pagtatalaga ng device gamit ang DDA (Discrete Device Assignment)Ang pamamaraang ito ay nagbibigay-daan sa pagmamapa ng isang partikular na PCIe device, tulad ng isang GPU o NVMe, nang direkta sa loob ng isang Windows virtual machine, na may antas ng kontrol at pagganap na katulad ng passthrough sa ESXi.

Ginamit ng mga mas lumang bersyon ng Windows Server ang teknolohiyang ito RemoteFX upang mag-alok ng GPU virtualization at magbahagi ng graphics card sa maraming VM. Gamit ang orasDahil sa mga isyu sa seguridad at mga limitasyon sa pagganap (tulad ng 1GB VRAM bawat VM cap at 30 FPS), itinigil ng Microsoft ang RemoteFX at iniwan ang DDA bilang pangunahing landas para sa mga nakalaang senaryo ng GPU.

Sa Windows 10 at Windows 11Lalo na sa ilang mga compilation, lumilitaw ang suporta para sa Paghahati ng GPU at muling paggamit ng mga mekanismo mula sa WSL2 at Windows SandboxGayunpaman, ang pag-configure nito ay karaniwang kinabibilangan ng mga kumplikadong script at pagkopya ng mga driver mula sa host patungo sa bisita, na hindi kasingdali ng pagtatalaga ng isang device sa vSphere.

Ang pagkaalam sa mga alternatibong ito ay nagbibigay-daan sa atin upang makita na Ang pilosopiya ng pag-aalok ng halos katutubong access sa GPU sa pamamagitan ng isang direktang PCIe channel Karaniwan ito sa ilang mga hypervisor, bagama't ang bawat isa ay may kanya-kanyang mga nuances, command, at mga paghihigpit sa compatibility.

Ipinapakita ng buong ecosystem na ito ng passthrough, vGPU, at DDA na, kung maayos na na-configure at may tamang hardware, Lubos na magagamit ang malalakas na GPU sa loob ng mga virtual na makina para sa produksyon Para sa mga workload mula sa mga mahahabang graphics desktop hanggang sa AI at HPC, palaging ipagpalagay na kakailanganin mong isuko ang ilang kaginhawahan ng tradisyonal na virtualization at bigyang-pansin ang mga driver, bersyon ng hypervisor, at suporta ng tagagawa ng GPU.

Masigasig na manunulat tungkol sa mundo ng mga byte at teknolohiya sa pangkalahatan. Gustung-gusto kong ibahagi ang aking kaalaman sa pamamagitan ng pagsusulat, at iyon ang gagawin ko sa blog na ito, ipakita sa iyo ang lahat ng mga pinaka-kagiliw-giliw na bagay tungkol sa mga gadget, software, hardware, teknolohikal na uso, at higit pa. Ang layunin ko ay tulungan kang mag-navigate sa digital na mundo sa simple at nakakaaliw na paraan.