- Duplikacja danych zakłóca analizę i podejmowanie decyzji, dlatego przed rozpoczęciem pracy z danymi należy je wykryć i skontrolować.

- Arkusze kalkulacyjne, takie jak Excel, umożliwiają wyróżnianie, filtrowanie i usuwanie duplikatów poprzez połączenie formatowania warunkowego, zaawansowanych filtrów i funkcji tekstowych.

- En Bazy danych Polecenia SQL, SELECT DISTINCT i alternatywy, takie jak GROUP BY, pomagają uzyskać wyniki bez powtarzających się wierszy i bez modyfikowania oryginalnych danych.

- Narzędzia do zarządzania bibliografią oraz dobre praktyki tworzenia kopii zapasowych i wstępnego recenzowania redukują ryzyko utraty istotnych informacji poprzez eliminację duplikatów.

Pracując z bazami danych, arkusze kalkulacyjne lub systemów informatycznych, Duplikacja danych może stać się prawdziwym bólem głowyPowtarzające się rekordy, nazwiska napisane na tysiące różnych sposobów, źle sformatowane daty lub dodatkowe spacje sprawiają, że analizy są mało wiarygodne i tracisz czas na ręczne sprawdzanie tego, co system mógłby pomóc Ci uporządkować w ciągu kilku sekund.

Dobra wiadomość jest taka, że istnieją Potężne narzędzia do lokalizowania, wyróżniania i usuwania duplikatów danych zarówno w Excelu, jak i Google Arkusze jak w Bazy danych SQL lub narzędzi do zarządzania bibliografią. Zrozumienie, jak działają, czym się różnią i jakie stwarzają ryzyko (takie jak usunięcie informacji, które później możesz przegapić), jest kluczem do utrzymania porządku w danych i umożliwienia ich spokojnej analizy.

Dlaczego pojawiają się duplikaty danych i dlaczego stanowią problem?

W praktyce, Duplikaty powstają w wyniku błędów ludzkich, powtarzających się importów lub słabej koordynacji systemów.Formularze przesyłane dwukrotnie, pliki łączone bez wcześniejszego czyszczenia lub integracje pomiędzy aplikacjami, które nie weryfikują prawidłowo informacji, stanowią doskonałe podłoże do zapełniania systemu zduplikowanymi rekordami.

Oprócz oczywistych duplikatów znajdziesz niewielkie różnice, które w rzeczywistości przedstawiają te same daneNazwy składające się z mieszanych wielkich i małych liter, dodatkowych spacji, różnych skrótów lub dat w różnych formatach, których system nie rozpoznaje jako takich samych, mimo że dla osoby czytającej jest oczywiste, że odnoszą się do tej samej rzeczy.

Wpływ jest znaczący: Statystyki są zniekształcone; liczba klientów i pacjentów jest zawyżona.E-maile są powtarzane w kampaniach e-mailowych, faktury są duplikowane, a liczba zamówień jest przeszacowana. Może to prowadzić do podejmowania błędnych decyzji, dodatkowych kosztów i znacznego braku zaufania do jakości danych.

Dlatego zanim zaczniesz tworzyć pulpity nawigacyjne lub zaawansowane analizy, warto zainwestować czas w Doskonałe narzędzie do czyszczenia danych, służące do wykrywania i korygowania niespójnościUsuwanie duplikatów jest kluczową częścią tego procesu, ale nie jedyną: musisz także ujednolicić tekst, usuń dziwne spacje i znormalizuj daty.

Wykrywaj i wyróżniaj duplikaty danych w arkuszach kalkulacyjnych

Narzędzia takie jak Excel oferują bardzo wygodne funkcje aby szybko zidentyfikować, które wartości powtarzają się w zakresie komórekZanim cokolwiek usuniesz, warto skorzystać z formatu wizualnego, który pomoże Ci przejrzeć i spokojnie zdecydować, co chcesz zachować.

Bardzo popularnym sposobem na rozpoczęcie jest... Formatowanie warunkowe w celu wyróżnienia wartości, które pojawiają się więcej niż razW ten sposób nie zmieniasz zawartości komórek, a jedynie je zaznaczasz, aby móc je analizować.

Typowy przepływ pracy polega na wybraniu najpierw komórek do przejrzenia, a następnie zastosowaniu Reguła formatowania warunkowego oznaczająca duplikaty innym kolorem tła lub czcionkąUmożliwia to identyfikację wzorców, na przykład sprawdzenie, czy dana osoba pojawia się wielokrotnie na liście klientów lub czy określone kody produktów zostały zarejestrowane więcej niż jeden raz.

Co więcej, możesz połączyć to automatyczne wyróżnianie z filtrami w samym arkuszu kalkulacyjnym, aby: Możesz przeglądać tylko wiersze zawierające duplikaty i sprawdzać je pojedynczo.Dzięki temu masz większą kontrolę i zmniejszasz ryzyko przypadkowego usunięcia ważnych informacji.

Bezpieczne usuwanie duplikatów wartości w programie Excel

Gdy już wiesz, które powtórzenia są zbędne, program Excel zawiera specjalną funkcję o nazwie „Usuń duplikaty” – trwale usuwa powtarzające się wierszeTutaj trzeba zachować ostrożność, bo usuniętych danych nie da się łatwo odzyskać, jeśli nie zapisałeś kopii.

Przed uruchomieniem tego narzędzia zdecydowanie zaleca się: Skopiuj oryginalny zakres danych do innego arkusza lub pliku kopii zapasowejW ten sposób, jeśli czyszczenie przyniesie nieoczekiwane rezultaty, będziesz mógł przejrzeć usunięte dane i odzyskać je bez żadnych problemów.

Procedura polega na wybraniu zakresu komórek, które chcesz oczyścić, a następnie wskazaniu kolumn, w których wartości powinny zostać porównane, aby stwierdzić, czy wiersz jest duplikatem. Jeśli zaznaczysz wiele kolumn, za duplikat zostanie uznany tylko wiersz, którego cała kombinacja pasuje do innego wiersza.co jest bardzo przydatne podczas pracy ze złożonymi danymi.

Po potwierdzeniu operacji program Excel usuwa dodatkowe wiersze i Pokazuje podsumowanie liczby usuniętych duplikatów i liczby pozostałych unikalnych rekordów.Ten krótki raport pomoże Ci sprawdzić, czy efekty odpowiadają temu, czego oczekiwałeś rozpoczynając sprzątanie.

Należy o tym pamiętać Filtrowanie unikalnych wartości nie jest tym samym, co usuwanie duplikatów.Podczas filtrowania duplikaty wierszy są tylko tymczasowo ukrywane, ale nadal tam są; usunięcie duplikatów powoduje ich całkowite usunięcie. Dlatego rozsądniejszą strategią jest rozpoczęcie od filtra unikatowego lub formatowania warunkowego.

Kryteria uznania wartości za duplikowaną

Gdy narzędzia arkusza kalkulacyjnego porównują duplikaty, Opierają się na tym, co faktycznie widać w komórce, a nie na interpretowanej wartości.Niesie to za sobą pewne ciekawe konsekwencje, o których powinieneś wiedzieć, aby uniknąć przykrych niespodzianek.

Na przykład dwie daty reprezentujące ten sam dzień nie mogą być uważane za duplikaty, jeśli Jedna data to „08/03/2006”, a druga „8 marca 2006”.Ponieważ treść tekstu jest inna, nawet jeśli znaczenie jest identyczne. To samo może się zdarzyć w przypadku nazw i ciągów znaków z różnymi spacjami lub wielkościami liter.

Podobnie liczba zapisana jako tekst i ta sama liczba w formacie numerycznym Można je traktować jako różne wartości. Dlatego tak ważne jest znormalizowanie formatów przed próbą masowego usuwania duplikatów wierszy.

Przed wykonaniem agresywnego czyszczenia warto najpierw przeprowadzić filtrowanie w celu znalezienia unikatowych wartości lub skorzystać z formatowania warunkowego w celu ich potwierdzenia. że kryterium porównania działa tak, jak myśliszUstalenie tych zasad gry na początku zapobiega utracie prawidłowych danych lub powstawaniu ukrytych duplikatów.

Funkcje tekstowe w arkuszach kalkulacyjnych do czyszczenia brudnych danych

Ogromna część problemów z duplikatami nie wynika z powtarzania dokładnie tej samej wartości, ale z faktu, że Te same informacje są zapisywane w nieco inny sposóbTutaj właśnie wchodzą w grę funkcje tekstowe programów Excel lub Arkusze Google, które umożliwiają standaryzację i przygotowanie gruntu przed usunięciem powtórzeń.

Bardzo często zdarza się, że w kolumnach niektóre nazwy są pisane wielkimi literami, inne małymi, a jeszcze inne są losowo wymieszane. Aby je ujednolicić, istnieją funkcje, które… Zamieniają wszystko na małe litery, wszystko na wielkie lub zamieniają tylko pierwszą literę każdego słowa na wielką.Dzięki temu „ANA PÉREZ”, „ana pérez” i „Ana Pérez” będą traktowane w ten sam sposób.

Teksty z dodatkowe spacje, zarówno wewnątrz łańcucha, jak i na początku lub na końcuSpecjalna funkcja może usunąć zbędne spacje i pozostawić tylko zwykłą spację między wyrazami, eliminując w ten sposób frazy „Juan García” lub podobne, które powodują błędy porównań.

W przypadku danych, które są ściśle ze sobą powiązane, takich jak połączone kody lub imiona i nazwiska w tej samej komórce, przydatne jest użycie funkcji ekstrakcji i sumowania. Możesz wyodrębnić część tekstu wskazując, z jakiej pozycji i ile znaków chcesz wyodrębnić lub połączyć kilka ciągów w jeden, aby odtworzyć bardziej spójne pola.

W przypadku dat, jeśli są one dostarczane jako tekst o różnych stylach, dobrym pomysłem jest ich przekształcenie w standardowy format daty oparty na roku, miesiącu i dniuDzięki temu arkusze kalkulacyjne traktują je jak rzeczywiste daty, można je poprawnie sortować, a porównania nie zależą już od wyglądu komórki.

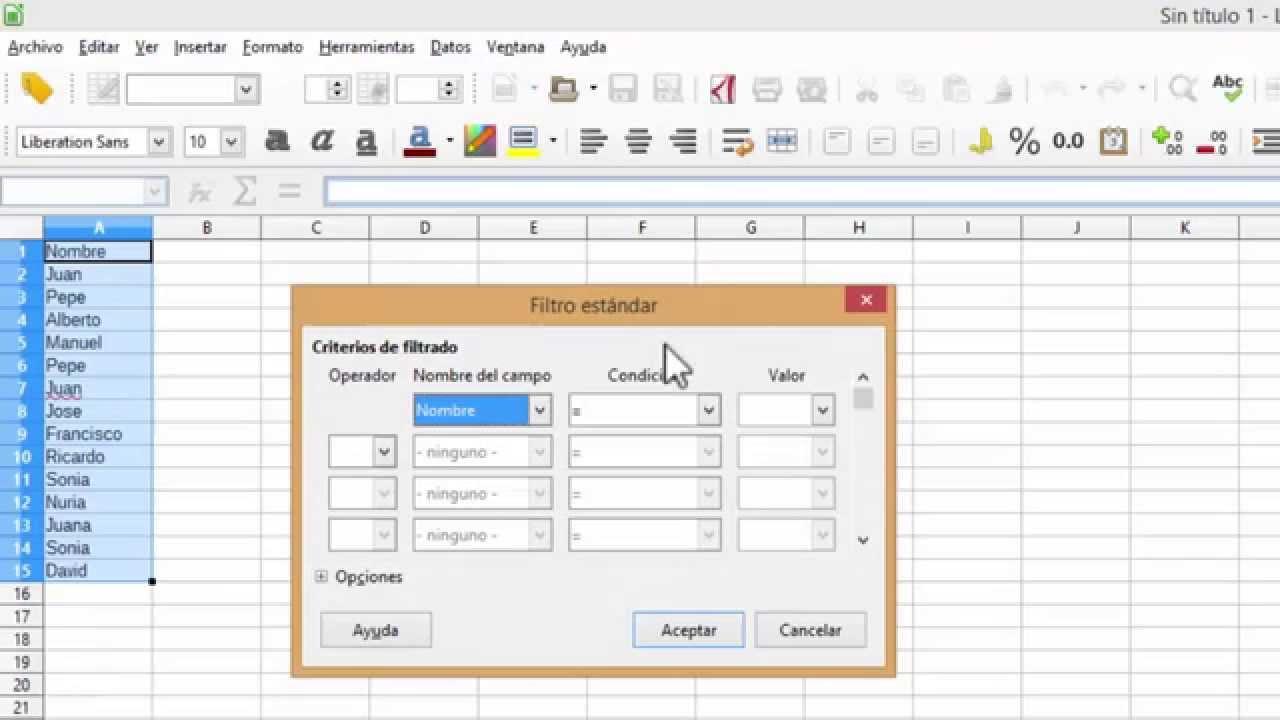

Filtruj unikalne wartości i usuwaj duplikaty w arkuszach kalkulacyjnych

Oprócz narzędzi formatowania i funkcji tekstowych zarówno Excel, jak i Arkusze Google umożliwiają Szybkie filtrowanie w celu wyświetlania tylko unikalnych wartości z kolumny lub zestawu kolumnTo bardzo skuteczny sposób na przeanalizowanie wyników przed podjęciem nieodwracalnych decyzji.

W niektórych środowiskach możesz użyć zaawansowanych opcji filtrowania, aby wskazać, że chcesz wyświetlić tylko wiersze z unikatowymi wartościami w jednej lub kilku konkretnych kolumnach. Filtrowanie nie usuwa danych, lecz jedynie tymczasowo ukrywa duplikaty., co sprawia, że jest to bardzo ostrożny krok pośredni.

Po potwierdzeniu, że interesujący Cię jest ten unikalny widok, masz polecenia specyficzne dla Usuń duplikaty bezpośrednio z menu danychZazwyczaj wykonuje się to w taki sposób, że uzyskuje się dostęp do opcji „Dane > Usuń duplikaty”, gdzie można wybrać kolumny, na których ma opierać się porównanie.

Inną opcją jest użycie formatowania warunkowego, aby wyróżnić zarówno duplikaty, jak i wartości unikatowe, w zależności od potrzeb. Możesz na przykład: Podświetl jasnym kolorem wiersze, które pojawiają się tylko raz i przeanalizuj, czy są to nietypowe rekordy, błędy ładowania, czy po prostu rzadkie przypadki, które należy zachować.

Jeśli pracujesz z listami rozwijanymi lub walidacją danych, ich czyszczenie również ma sens. Możesz to zrobić za pomocą menu walidacji. zdefiniuj listy zamknięte, które zapobiegają wprowadzaniu odmian typograficznych, zmniejszając w ten sposób występowanie fałszywych duplikatów, które w rzeczywistości są po prostu literówkami.

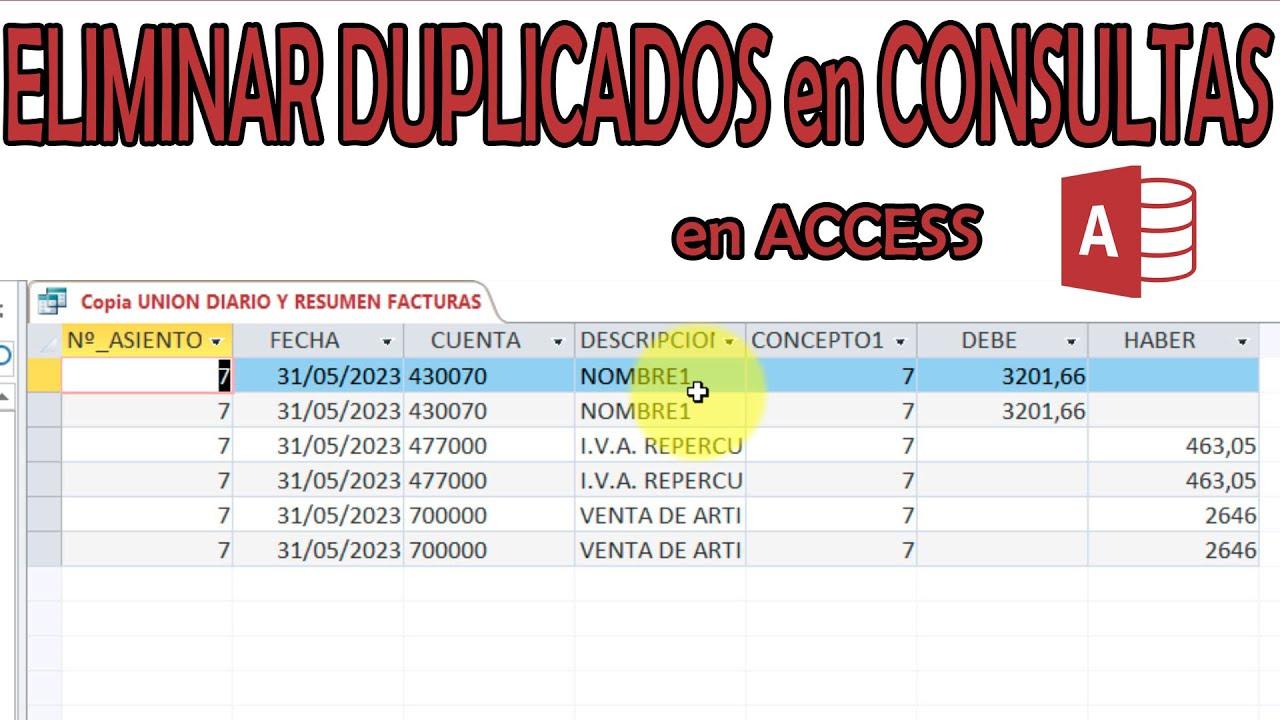

Czyszczenie duplikatów w bazach danych SQL za pomocą polecenia SELECT DISTINCT

Kiedy przeszliśmy ze świata arkuszy kalkulacyjnych do świata Bazy danychPodejście ulega nieznacznej zmianie. W SQL jednym z pierwszych narzędzi do zarządzania powtarzającymi się informacjami jest operator DISTINCT, używany w połączeniu z poleceniem SELECT w celu zwracania wierszy bez duplikatów w wynikach zapytania.

Pomysł jest prosty: podczas tworzenia instrukcji SELECT można dodać słowo kluczowe DISTINCT, aby wskazać, że Potrzebujesz tylko jednego wystąpienia każdej kombinacji wartości w wybranych kolumnach. W ten sposób, jeśli ten sam logiczny wiersz powtórzy się kilka razy w tabeli, zapytanie zwróci pojedynczy wiersz.

Ważne jest, aby zrozumieć, że polecenie SELECT DISTINCT nie usuwa niczego z bazy danych: Dotyczy to wyłącznie wyniku, który widzisz po uruchomieniu zapytania.Oryginalne informacje pozostają niezmienione w tabelach, co jest idealne w przypadku analiz eksploracyjnych, w których na razie nie chcemy modyfikować danych.

Jeśli chodzi o składnię, ogólny wzór polega na połączeniu polecenia SELECT DISTINCT z listą interesujących Cię kolumn, a następnie klauzuli FROM wskazującej tabelę i opcjonalnie klauzula WHERE do filtrowania według określonych warunkówW ten sposób możesz na przykład poprosić o zamówienie unikalnych klientów z jednego kraju lub o różne produkty z określonej kategorii.

To podejście jest bardzo przydatne, gdy chcesz zawęzić wyniki do wpisów, które nie są duplikatami, niezależnie od tego, czy Uzyskaj listę klientów bez duplikatów spowodowanych wielokrotnymi zamówieniami, wyświetlić listę odrębnych kodów produktów lub wygenerować liczbę unikalnych pozycji w zestawie danych.

Różnice między DISTINCT a innymi sposobami unikania duplikatów w SQL

Chociaż DISTINCT i UNIQUE mogą brzmieć podobnie, Nie pełnią tej samej roli w ekosystemie SQLDISTINCT działa w zapytaniach SELECT, wpływając na zwracane wiersze; UNIQUE zwykle odnosi się do ograniczeń w definicji tabel, wskazując, że pewne pola nie mogą zawierać powtarzających się wartości.

Co więcej, w kontekstach z dużą ilością danych użycie SELECT DISTINCT może być intensywne pod względem wydajności, ponieważ Moduł bazy danych musi porównać wszystkie wybrane kolumny. aby określić, które wiersze są takie same. W dużych tabelach lub tabelach z wieloma kolumnami może to być uciążliwe.

Dlatego w niektórych przypadkach warto rozważyć alternatywy. Jedną z najczęstszych jest użycie GROUP BY, aby grupować wiersze według jednej lub więcej kolumn i zastosuj funkcje agregacji (takie jak COUNT, MIN lub MAX), które pozwolą Ci efektywnie podsumować dane.

Można również polegać na klauzulach takich jak EXISTS sprawdź, czy pewne wartości znajdują się w innej tabeliDzięki temu unikniesz niepotrzebnego łączenia zduplikowanych wierszy. Możesz też użyć podzapytań z dobrze zdefiniowanymi klauzulami SELECT, FROM i WHERE, aby lepiej określić, które rekordy chcesz pobrać.

Gdy chcesz policzyć, ile unikalnych wartości znajduje się w kolumnie, często łączy się funkcję COUNT z DISTINCT, dzięki czemu Otrzymujesz bezpośrednio liczbę różnych elementów. bez konieczności ręcznego sprawdzania każdego z nich.

Praktyczne przykłady: zapytania i adresy klientów bez duplikatów

Wyobraź sobie, że pracujesz z tabelą zamówień, w której każdy wiersz reprezentuje dokonany zakup. Często się zdarza, że Ten sam klient pojawi się wielokrotnie, jeśli złożył więcej niż jedno zamówienie.Jeśli chcesz zobaczyć każdego klienta tylko raz, SELECT DISTINCT jest bardzo przejrzystym narzędziem.

W tym scenariuszu należy utworzyć zapytanie wybierające kolumny identyfikacyjne klienta (na przykład jego identyfikator i imię) i zastosować do nich metodę DISTINCT. otrzymasz listę od każdego klienta tylko raz., chociaż oryginalna tabela ma dziesięć różnych kolejności.

Coś podobnego dzieje się, gdy chcesz zobaczyć wszystkie unikalne adresy wysyłki, na które wysłano produktyJeśli każde zamówienie zawiera adres, tabela będzie pełna powtórzeń. Jednak stosując polecenie DISTINCT w kolumnach adresu, można wygenerować zwięzłą listę punktów wysyłki.

Jeśli chcesz skupić się na klientach z określonego obszaru, możesz dodać klauzulę WHERE, aby wskazać na przykład, że Interesują Cię tylko rekordy z konkretnego krajuW ten sposób polecenie SELECT DISTINCT działa na podzbiorze tabeli, a nie na wszystkich danych.

W sektorze opieki zdrowotnej lub akademickim operator jest również bardzo praktyczny dane grupowe od pacjentów lub autorów, którzy pojawiają się wielokrotnie w różnych badaniach lub artykułach, pokazując tylko jeden wpis na jednostkę dla celów analizy.

Zarządzanie duplikatami odniesień w bazach bibliograficznych

W dziedzinie dokumentacji naukowej bazy bibliograficzne zazwyczaj oferują konkretne narzędzia do usuwania duplikatów odniesień Podczas przeszukiwania różnych źródeł niezwykle ważne jest zapobieganie wypełnianiu przeglądów literatury zduplikowanymi artykułami.

W tych systemach w menu narzędzi znajduje się zazwyczaj polecenie „Usuń duplikaty”, które Analizuje zestaw wyników i automatycznie usuwa zduplikowane odniesienia.System zazwyczaj informuje, ile elementów zostało usuniętych i ile pozostało w bieżącym zestawie.

Na wielu platformach możesz skonfigurować w sekcji preferencji, że: Usuwanie duplikatów odniesień odbywa się automatycznie. za każdym razem, gdy przeprowadzasz nowe wyszukiwanie. Oszczędza to dużo pracy ręcznej, choć zaleca się regularne sprawdzanie, czy duplikaty kryteriów są poprawne.

Oprócz usuwania zbiorczego menedżery te umożliwiają ręczne wybieranie konkretnych odniesień i podejmowanie decyzji o ich zachowaniu lub usunięciu. Ręczne przeglądanie jest przydatne, gdy system nie jest pewien, czy dwa rekordy to rzeczywiście ten sam element. lub jeśli odpowiadają różnym wersjom (na przykład przedrukom i wersjom ostatecznym).

Po usunięciu duplikatów zestaw wyników jest aktualizowany i pokazuje zmniejszoną liczbę odniesieńTaka kontrola numeryczna pozwala zweryfikować, czy debugowanie przyniosło efekt, a także udokumentować proces w przeglądach systematycznych lub raportach z wyszukiwania.

Pisarz z pasją zajmujący się światem bajtów i technologii w ogóle. Uwielbiam dzielić się swoją wiedzą poprzez pisanie i właśnie to będę robić na tym blogu, pokazywać Ci wszystkie najciekawsze rzeczy o gadżetach, oprogramowaniu, sprzęcie, trendach technologicznych i nie tylko. Moim celem jest pomóc Ci poruszać się po cyfrowym świecie w prosty i zabawny sposób.