- Microservices maken de ontwikkeling van modulaire en schaalbare applicaties mogelijk, waarbij elke service autonoom is en onafhankelijk kan worden geïmplementeerd.

- Met Docker is het eenvoudig om lichtgewicht, draagbare containers te creëren die elke microservice met al zijn afhankelijkheden verpakken.

- Kubernetes orkestreert de containers en beheert de implementatie, schaling, netwerken en automatische herstel van microservices in het cluster.

- Het toepassen van goede beveiligings-, monitoring- en automatiseringspraktijken is essentieel voor het succesvol draaien van microservices in een productieomgeving.

In de afgelopen jaren, de combinatie van microservices, Docker en Kubernetes Het is de facto de standaard geworden voor het implementeren van moderne, schaalbare en gemakkelijk te onderhouden applicaties. Steeds meer bedrijven stappen af van monolithische applicaties en kiezen voor gedistribueerde architecturen die beter aansluiten bij veranderende omgevingen en DevOps-strategieën.

Als je het vraagt Hoe implementeer je microservices met Docker en Kubernetes in de praktijk?Deze inhoud is perfect voor jou: we bespreken de belangrijkste concepten, voordelen en uitdagingen, hoe je containers maakt, hoe je ze in een cluster beheert en welke stappen je moet volgen om ze te installeren. Windows y Linuxen een aantal tips voor het verstandig gebruik ervan in de praktijk.

Wat is een microservices-architectuur en waarin verschilt deze van een monolithische architectuur?

Een microservices-architectuur is gebaseerd op verdeel een applicatie in meerdere kleine, autonome en onafhankelijk inzetbare services.Elk platform was gericht op een specifieke functionaliteit (gebruikers, betalingen, catalogus, bestellingen, enz.) en communiceerde voornamelijk via lichte API's (HTTP/REST, gRPC, berichtenverkeer, enz.).

Bij een monolithische applicatie daarentegen, Alle bedrijfslogica, de presentatielaag en de gegevenstoegang zijn verpakt in één enkel implementatieblok.Elke wijziging vereist het opnieuw compileren, testen en implementeren van het gehele systeem, wat de ontwikkeling bemoeilijkt en het risico op fouten in de productieomgeving vergroot.

Bij microservices heeft elke service zijn eigen levenscyclus: Het kan onafhankelijk van elkaar worden ontwikkeld, getest, geïmplementeerd, geschaald en van versiebeheer worden voorzien.Dit maakt het mogelijk dat meerdere teams parallel werken, vereenvoudigt de implementatie van nieuwe technologieën en vergemakkelijkt de integratie met CI/CD-praktijken.

Bovendien introduceert deze architectuur het concept van component-onafhankelijke schaalbaarheidIn plaats van een complete monolithische applicatie op te schalen om de toegenomen belasting van een specifieke module te ondersteunen, worden alleen de microservices opgeschaald die dit daadwerkelijk nodig hebben, waardoor de infrastructuurbronnen beter worden geoptimaliseerd.

De werkelijke voordelen en uitdagingen van microservices

Overstappen op microservices is geen tijdelijke hype: Het biedt concrete voordelen op het gebied van schaalbaarheid, veerkracht en implementatiesnelheid.Maar het brengt ook een operationele complexiteit met zich mee die beheerd moet worden.

Tot de meest opvallende voordelen behoort de onafhankelijke schaalbaarheid van elke dienstAls de betalingsmodule bijvoorbeeld meer verkeer te verwerken krijgt dan de beheermodule, kunt u het aantal replica's van de betalingsmicroservice verhogen, zonder de rest van de applicatie aan te raken of resources te verspillen.

Je wint er ook veel mee continue inzet en frequente leveringenDoor elke service te isoleren, is het mogelijk om nieuwe versies stapsgewijs uit te brengen, zonder de hele applicatie te hoeven stoppen of opnieuw te implementeren. Dit verkort de onderhoudsperiodes en verbetert de time-to-market.

Een ander belangrijk punt is de veerkracht en fouttolerantieAls een microservice correct is ontworpen, mag het uitvallen ervan niet het hele systeem platleggen. Dankzij mechanismen zoals time-outs, herhaalpogingen en circuit breakers kunnen de andere services blijven reageren, waardoor de impact van de storingen beperkt blijft.

Bovendien maken microservices het mogelijk om... technologische flexibiliteitElk team kan de taal, het framework of de database kiezen die het meest geschikt is voor hun dienstverlening, zolang ze de communicatiecontracten en het algemene beleid van het platform respecteren.

Aan de andere kant van de medaille vinden we de operationele en observeerbaarheidscomplexiteitHet beheren van tientallen of honderden services brengt het volgende met zich mee: gedistribueerde netwerken, tracering tussen services, gecentraliseerde logging, beveiliging, API-versiebeheer en gegevensconsistentie. Dit vereist geavanceerde tools en vol成熟e processen.

Het wordt ook ingewikkeld. beheer van de communicatie tussen dienstenHet is essentieel om zorgvuldig te ontwerpen hoe gegevens worden uitgewisseld, hoe fouten worden afgehandeld, hoe latentie wordt beheerd en hoe te voorkomen dat een trage afhankelijkheid de rest van het systeem vertraagt. Testen en debuggen zijn daardoor niet langer triviaal, omdat Het is niet één enkel blok dat wordt getest, maar een reeks onderling verbonden services..

Containers: de basis voor het geïsoleerd uitvoeren van microservices.

Containertechnologie is de ideale ondersteuning voor microservices geworden omdat Het stelt je in staat om een applicatie en al haar afhankelijkheden te verpakken in een gestandaardiseerde en draagbare eenheid.In plaats van bibliotheken, runtime-omgevingen en tools op elke server te installeren, wordt alles binnen de container verplaatst.

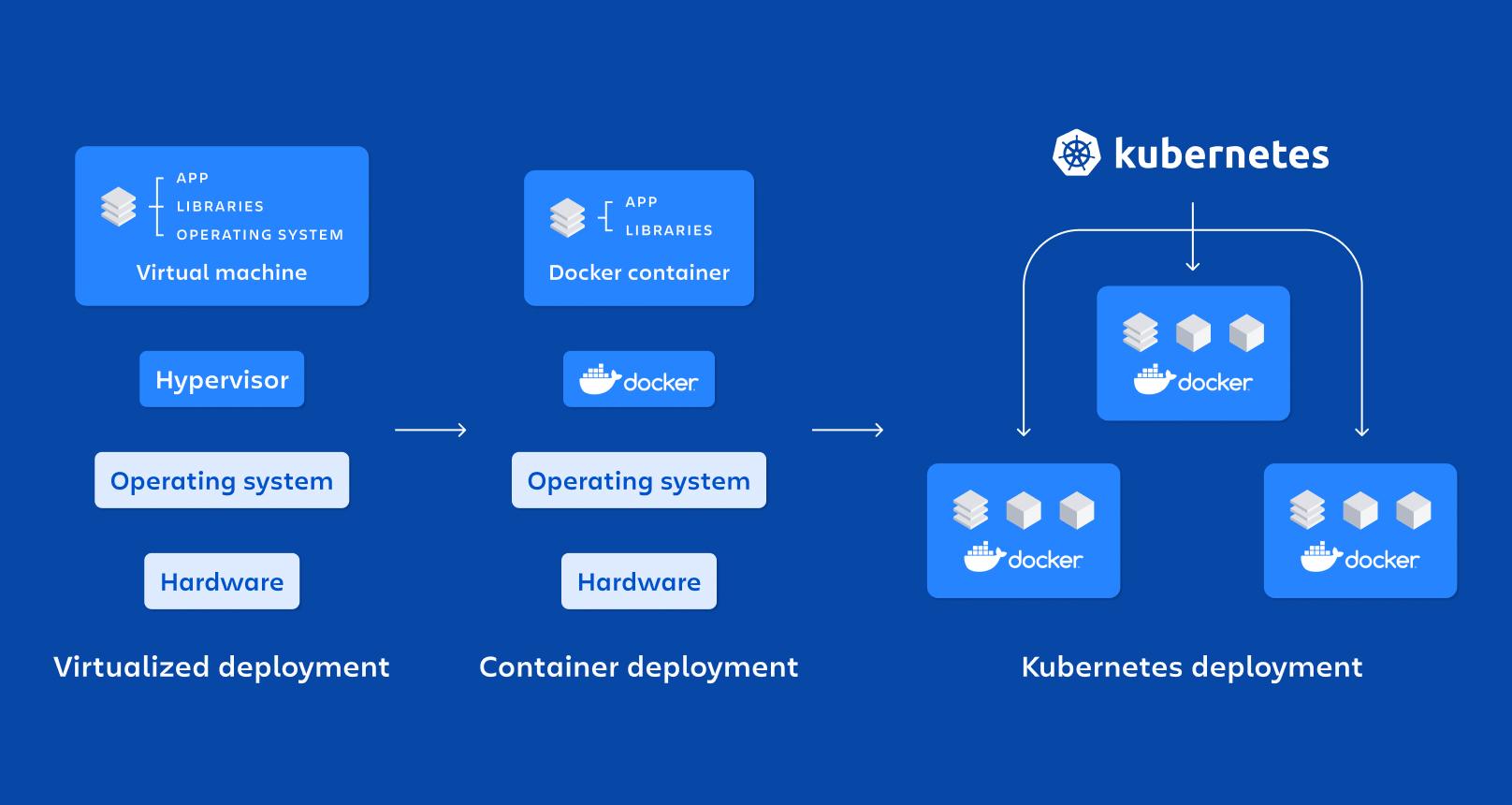

Een container is in wezen... een lichtgewicht vorm van virtualisatie op besturingssysteemniveauDeelt de hostkernel, maar voert processen uit in geïsoleerde namespaces en met resources die beperkt worden door cgroups, waardoor ze snel opstarten en minder resources verbruiken dan een virtuele machine.

Tot de belangrijkste eigenschappen behoren de isolatie, draagbaarheid, lichtheid en modulariteitDoordat elke microservice in zijn eigen container draait, is deze gemakkelijker te implementeren, stoppen, bijwerken of repliceren, wat perfect aansluit bij de principes van gedistribueerde architecturen.

Vergeleken met de virtuele machines voor productiede containers Ze hebben geen volledig besturingssysteem per instantie nodig.maar in plaats daarvan de bestanden van de host delen. Dit verkleint de bestandsgrootte van de afbeeldingen aanzienlijk. de tijd de Bootwaardoor je containers binnen enkele seconden kunt optillen of vernietigen.

Docker: hét referentieplatform voor het containeriseren van microservices

Docker is de populairste tool voor het werken met containers, omdat Het maakt het mogelijk om applicaties in containers te creëren, te verpakken, te distribueren en uit te voeren. zowel in ontwikkelomgevingen als in test- en productieomgevingen.

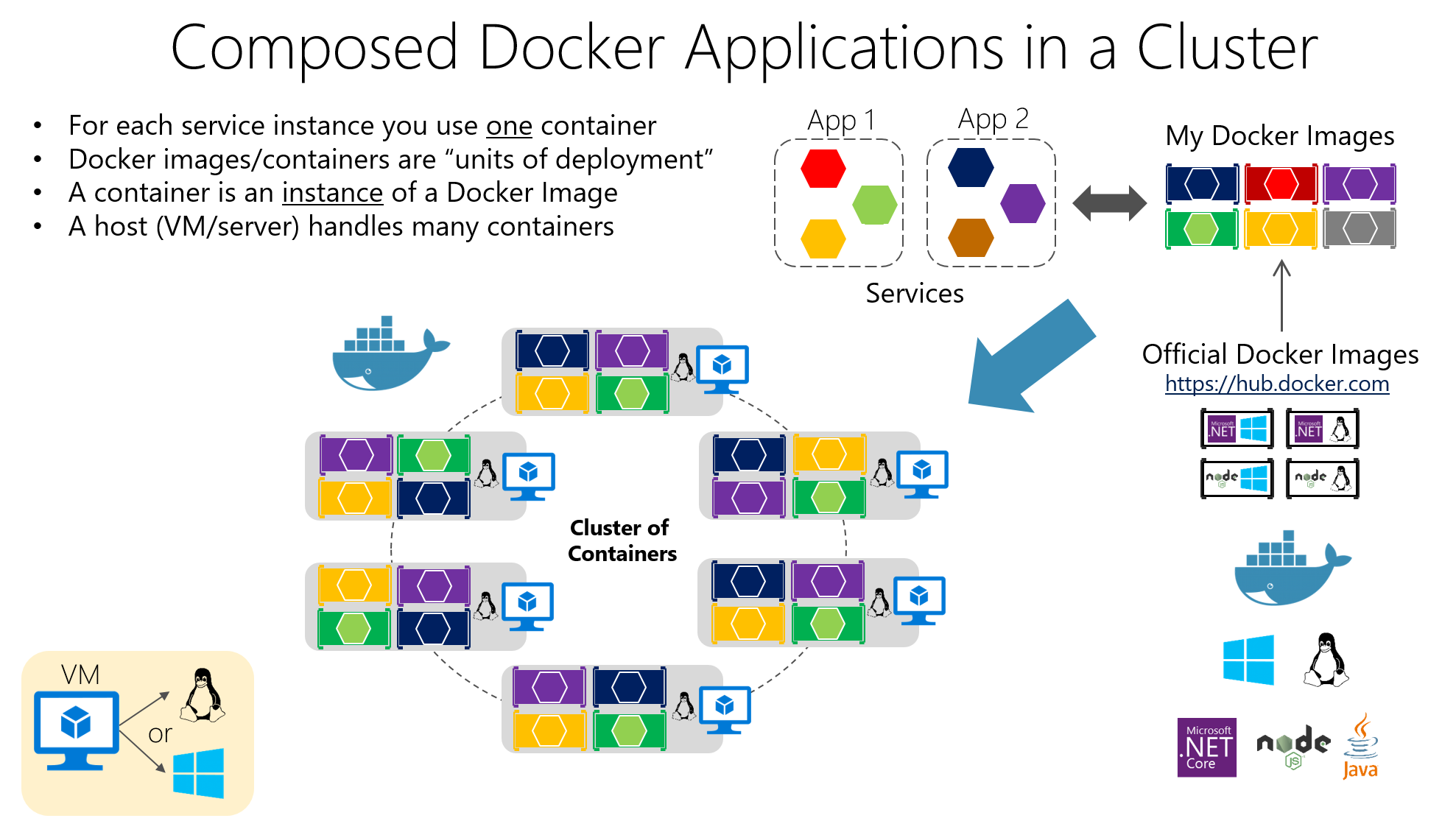

Hun centrale idee is om de software te verpakken in Docker-imagesDit zijn onveranderlijke artefacten die de applicatiecode, de benodigde bibliotheken, systeemtools en basisconfiguraties bevatten. Applicaties worden op basis van deze images gemaakt. containers in bedrijf, wat geïsoleerde gevallen zijn op basis van die afbeelding.

De beeldconstructie wordt gedefinieerd in een Dockerfile, een tekstbestand dat instructies bevat zoals de basisimage, de werkmap, welke bestanden gekopieerd moeten worden, welke afhankelijkheden geïnstalleerd moeten worden, welke poorten beschikbaar moeten worden gesteld en welk commando moet worden uitgevoerd bij het starten van de container.

Stel je voor dat je een API hebt geschreven in Node.js. Je zou een Dockerfile kunnen maken die er ongeveer als volgt uitziet, waarbij Uitgaande van een officiële Node-image worden de bestanden gekopieerd, de afhankelijkheden geïnstalleerd en de opstartopdracht gedefinieerd.:

FROM node:14

WORKDIR /app

COPY . .

RUN npm install

EXPOSE 3000

CMD

Dit bestand geeft aan dat de applicatie in deze map zal worden uitgevoerd. /app binnen de containerdat de afhankelijkheden met npm worden geïnstalleerd, dat poort 3000 wordt geopend en dat de container bij het opstarten het volgende zal uitvoeren npm begin.

Om die container te bouwen en te starten, hoeft u alleen maar de opdracht vanuit de projectmap uit te voeren. docker bouwen en koppelingsrunhet toewijzen van de poorten om toegang vanaf de host mogelijk te maken, of voor toepassingen met meerdere containers havenarbeider-compose:

docker build -t mi-app .

docker run -p 3000:3000 mi-app

Dankzij dit model, Het klassieke probleem "het werkt op mijn computer" wordt tot een minimum beperkt.Omdat de runtime-omgeving met de applicatie meereist. Bovendien integreert Docker naadloos met CI/CD-systemen, private registries en orchestratietools zoals Kubernetes.

Belangrijke componenten van Docker en hun rol in microservices

Bij een typische implementatie hebben we het over een Docker-hostDat is het systeem (fysiek of virtueel) waarop Docker is geïnstalleerd; het draait daar bovenop. Docker Engine, de daemon die images, netwerken, volumes en de levenscyclus van containers beheert.

De containers bevatten de applicatie en de bijbehorende afhankelijkheden verpakt in een imageHierdoor kan elke server met Docker die image consistent uitvoeren. Deze consistentie is cruciaal wanneer je veel microservices hebt geïmplementeerd in verschillende omgevingen (ontwikkeling, QA, productie, enz.).

Een van de meest interessante voordelen van Docker is dat... Overdraagbaarheid tussen omgevingen, automatische implementatie, procesmodulariteit en ondersteuning voor gelaagdheid en versiebeheer in images.waardoor het gemakkelijker wordt om wijzigingen terug te draaien en te optimaliseren. opslagruimte.

Kubernetes: de orchestrator voor het beheren van honderden containers

Als je van een paar containers naar tientallen of honderden containers gaat, Het handmatig beheren ervan wordt waanzinnig.Dat is waar Kubernetes om de hoek komt kijken, een open source platform dat is ontworpen om containers op grote schaal te orkestreren.

Kubernetes automatiseert cruciale taken zoals implementatie, schaling, foutafhandeling, netwerkconfiguratie en opslag van gecontaineriseerde applicaties. Het is ontworpen om te werken in publieke clouds, private clouds, hybride omgevingen en zelfs on-premises.

De focus ligt op het beheren van clusters die bestaan uit meerdere knooppunten (machines) waarop containers draaien. Het doel is ervoor te zorgen dat De applicaties bevinden zich altijd in de gewenste staat.: aantal replica's, geïmplementeerde versies, toegewezen resources en connectiviteit tussen services.

Fundamentele elementen van Kubernetes

De kleinste eenheid in Kubernetes is de PeulEen Pod vertegenwoordigt een of meer containerinstanties die samen moeten draaien (bijvoorbeeld een applicatiecontainer en een sidecarcontainer voor logging). Pods zijn tijdelijk. Ze worden aangemaakt, vernietigd en vervangen, afhankelijk van de behoeften van het cluster..

Om je Pods beschikbaar te maken, biedt Kubernetes de volgende resource: Dienstendie fungeert als een abstractielaag voor het netwerk. Een Service groepeert een set Pods en Het biedt een stabiel IP-adres, een DNS-naam en interne taakverdeling.zodat klanten de details van elke Pod niet hoeven te weten.

De hulpbron Deployment Het wordt gebruikt om te definiëren hoe Pods moeten worden geïmplementeerd en bijgewerkt: hoeveel replica's, welke image te gebruiken, welke tags toe te passen en welke update-strategie te volgen. Kubernetes regelt dit. Zorg er altijd voor dat het gewenste aantal Pods actief blijft. en om gefaseerde updates of terugdraaiingen uit te voeren wanneer u de configuratie wijzigt.

Er zijn ook hulpmiddelen zoals ConfigMap en SecretDeze functies stellen u in staat om configuraties te externaliseren en gevoelige gegevens (wachtwoorden, tokens, API-sleutels) op te slaan zonder deze in de images te hoeven verpakken. Dit vereenvoudigt het beheer van veilige configuraties in verschillende omgevingen aanzienlijk.

Hoe organiseer je een Kubernetes-cluster?

Het "hoofd" van de cluster is de Kubernetes-controleplandie verschillende componenten samenbrengt die verantwoordelijk zijn voor de aansturing van het gehele systeem. Een van die componenten is de API-serverDit is de toegangspoort tot het beheren van het cluster; elke actie (een Deployment aanmaken, Pods weergeven, een Service wijzigen) verloopt via deze API.

El Scheduler Het is verantwoordelijk voor het bepalen op welk knooppunt elke Pod draait, rekening houdend met beschikbare resources, affiniteiten en beperkingen; terwijl de Controller Manager Houd de status van het cluster in de gaten en onderneem actie om ervoor te zorgen dat de werkelijkheid overeenkomt met wat u in de manifesten hebt aangegeven (maak bijvoorbeeld nieuwe Pods aan als er minder zijn dan u hebt aangevraagd).

De opslag van de status wordt gedelegeerd aan enzEen gedistribueerde database slaat de configuratie en informatie op voor alle resources van het cluster. Daarnaast worden op elk werkknooppunt processen uitgevoerd zoals de volgende: kubus (agent die de node met de API-server communiceert), de kube-proxy (die het netwerkverkeer en de taakverdeling beheert) en de container-runtime (Docker, containerd, CRI-O, enz.).

Microservices implementeren in Kubernetes met YAML-bestanden

Om een microservice in Kubernetes te implementeren, is het gebruikelijk om deze te beschrijven met een YAML-manifestHier definieer je de implementatie (Pod-sjabloon, image, poorten, aantal replica's, labels) en de bijbehorende service om deze binnen of buiten het cluster beschikbaar te stellen.

Een eenvoudig voorbeeld van een implementatie voor een applicatie genaamd "my-app" zou er ongeveer zo uit kunnen zien, waarbij Er zijn drie replica's en poort 3000 gedefinieerd. als containerhaven:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mi-app

spec:

replicas: 3

selector:

matchLabels:

app: mi-app

template:

metadata:

labels:

app: mi-app

spec:

containers:

- name: mi-app

image: mi-app:latest

ports:

- containerPort: 3000

Dit manifest geeft aan dat het cluster het volgende moet handhaven: drie Pods in bedrijf Met de image "my-app:latest" worden alle Pods getagd met app=my-app, zodat een Service ze kan vinden en het verkeer erover kan verdelen. Kubernetes regelt automatisch de logica voor schalen, updates en het vervangen van Pods in geval van een storing.

Naast implementaties is het gebruikelijk om services van het type te definiëren. ClusterIP, NodePort of LoadBalancerAfhankelijk van of de microservice alleen binnen het cluster, vanaf de knooppunten of vanaf het internet toegankelijk moet zijn, wordt al deze configuratie in repositories beheerd, waardoor een naadloze integratie met CI/CD-pipelines mogelijk is.

Schaalbaarheid, upgrades en zelfherstel in Kubernetes

Een van de belangrijkste redenen om Kubernetes te gebruiken, is het vermogen om Microservices schalen en bijwerken zonder de applicatie te stoppen.Je kunt het aantal replica's wijzigen in het manifest (of met een kubectl-commando) en het cluster zorgt er vervolgens voor dat er Pods worden aangemaakt of verwijderd totdat de gewenste waarde is bereikt.

Deze schaalvergroting kan handmatig of automatisch plaatsvinden, met behulp van hulpmiddelen zoals Horizontale Pod Autoscaler (HPA)Deze functie past replica's dynamisch aan op basis van statistieken zoals CPU- of geheugengebruik. Hierdoor wordt de capaciteit verhoogd tijdens perioden van hoge vraag en worden resources vrijgemaakt wanneer de belasting afneemt.

Wat betreft updates implementeert Kubernetes het volgende: doorlopende updates Standaard worden Pods met de nieuwe versie aangemaakt en worden de Pods van de vorige versie geleidelijk verwijderd, zonder abrupt te stoppen. Als er iets misgaat, rollback Hiermee kunt u snel de vorige versie herstellen.

Een andere cruciale functionaliteit is de zelfreparatieAls een container of Pod uitvalt, maakt Kubernetes deze automatisch opnieuw aan; als een node niet meer reageert, worden de betreffende Pods opnieuw ingepland op andere beschikbare nodes, zodat de applicatie operationeel blijft.

Monitoring en observeerbaarheid van microservices in Kubernetes

Om een microservices-omgeving correct te beheren, is het niet voldoende om deze simpelweg te implementeren en op te schalen: U hebt realtime inzicht nodig in de prestaties en status van uw services.In Kubernetes is het heel gebruikelijk om tools zoals Prometheus te integreren voor het verzamelen van metrics en Grafana voor het visualiseren ervan.

Prometheus verzamelt metrics van de Pods, nodes en clustercomponenten, slaat ze op en stelt je in staat om er waarschuwingen voor te definiëren; in combinatie met Grafana kun je dashboards maken waar Monitor CPU-gebruik, geheugen, HTTP-fouten, latentie, aantal replica's of knooppuntstatus. heel duidelijk.

Daarnaast biedt kubectl het volgende: commando's Om de status van implementaties, services, pods en andere resources te controleren, raadpleegt u de volgende pagina. logsDit omvat het beschrijven van gebeurtenissen of het benaderen van containers voor debugging. Dit alles maakt deel uit van een observatiestrategie die in microservices Het is geen optie als je rustig wilt slapen..

De relatie tussen microservices, Docker en Kubernetes

Microservices, Docker en Kubernetes passen perfect in elkaar, als de stukjes van dezelfde puzzel: Microservices-architectuur bepaalt hoe je de applicatie ontwerpt, Docker verzorgt het verpakken en uitvoeren van elke service, en Kubernetes orkestreert al die containers. in een cluster.

Elke microservice is ingekapseld in een Docker-image die de code en afhankelijkheden bevat.Dit zorgt ervoor dat het zich op dezelfde manier gedraagt op de laptop van een ontwikkelaar, in een testomgeving of in een cloudproductieomgeving. Deze consistente verpakking is essentieel voor de DevOps-filosofie.

Kubernetes fungeert op zijn beurt als containerorkestratorHet bepaalt hoeveel instanties van elke microservice er moeten draaien, waar ze zich bevinden, hoe het verkeer erover verdeeld wordt, hoe ze herstellen van storingen en hoe ze schalen wanneer de vraag toe- of afneemt.

In een e-commerce-applicatie zou je bijvoorbeeld microservices kunnen hebben voor authenticatie, catalogus, winkelwagen en betalingen, elk met een eigen Docker-image en Kubernetes-implementatie. Op deze manier, Je kunt de catalogus opschalen voor grootschalige campagnes of betalingen op cruciale momenten zonder dat dit de rest beïnvloedt.en de volledige levenscyclus ervan orkestreren, van CI/CD-pipelines tot monitoring na de productie.

Docker en Kubernetes installeren op Windows

Als je met Windows werkt, is de makkelijkste manier om te beginnen het installeren van... Docker-bureaubladDit omvat de Docker-engine en extra tools, en zelfs opties om Kubernetes in uw machine te integreren.

Het gebruikelijke proces omvat Download Docker Desktop van de officiële website.Voer het installatieprogramma (Docker Desktop Installer.exe) uit en volg de instructies van de wizard. Tijdens de installatie kunt u kiezen tussen het gebruik van Hyper-V of WSL 2 als virtualisatietechnologie; als er maar één beschikbaar is, dan wordt die gebruikt.

Na het opnieuw opstarten van het systeem initialiseert het openen van Docker Desktop de containeromgeving; als virtualisatie niet was ingeschakeld, biedt het installatieprogramma zelf meestal een oplossing. schakel het automatisch inVan daaruit kun je containers starten, bijvoorbeeld Nginx of je eigen applicaties.

Om Kubernetes op Windows te gebruiken, moet je eerst Docker en virtualisatiemogelijkheden inschakelen. Vervolgens kun je Kubernetes inschakelen via Docker Desktop of Kubectl installeren en configureren om externe clusters te beheren en, indien nodig, het Kubernetes-dashboard te implementeren via een extern manifest.

Na configuratie kunt u het dashboard via een lokale proxy benaderen met behulp van een authenticatietoken dat is gegenereerd met kubectl en dat bijvoorbeeld verwijst naar het configuratiebestand. .kube/config Om de toegang tot het cluster vanuit de browser te beheren.

Docker en Kubernetes installeren op Linux

Op Linux-systemen, zoals Ubuntu, is het installeren van Docker meestal vrij eenvoudig: De pakketten worden bijgewerkt, de Docker-engine wordt geïnstalleerd en de omgeving wordt gecontroleerd om er zeker van te zijn dat alles correct werkt. Een testcontainer uitvoeren.

De gebruikelijke stappen omvatten het bijwerken van het systeem met apt-get update en apt-get upgradeVerwijder eventuele eerdere versies van Docker Desktop en installeer vervolgens docker-ce, docker-ce-cli, containerd.io en de docker-compose plugin vanuit de officiële repositories of door de gewenste versie te specificeren.

Om te controleren of alles in orde is, wordt meestal een "hello-world"-container gestart. Het downloadt een minimale image en voert deze uit.Als het bericht correct wordt weergegeven, is Docker operationeel en klaar om uw microservices te containeriseren.

Wat Kubernetes betreft, dat kan op Linux worden geïnstalleerd met behulp van tools zoals... KubeadmDe gebruikelijke workflow omvat het toevoegen van de Kubernetes-repositorysleutel, het configureren van het pakketlijstbestand, het installeren van kubeadm en het controleren van de versie ervan.

Het cluster wordt vervolgens geïnitialiseerd op het masterknooppunt met kubeadm init (waarbij het netwerkbereik voor de Pods wordt gespecificeerd), wordt het "join"-commando opgehaald zodat de worker-nodes zich bij het cluster voegen en lokale toegang wordt geconfigureerd door de directory aan te maken. $HOME/.kubedoor het bestand admin.conf te kopiëren en de machtigingen aan te passen.

Hiermee heb je een basiscluster klaar voor gebruik. microservices in containers implementerenInstalleer een netwerk van Pods (Flannel, Calico, enz.) en begin te werken met Deployments, Services en de rest van de Kubernetes-resources.

Beste werkwijzen en aanbevelingen voor het gebruik van Docker en Kubernetes

Om het maximale uit deze omgevingen te halen, is het raadzaam een aantal best practices voor Docker te volgen, te beginnen met Gebruik officiële of betrouwbare afbeeldingen., hetzij vanuit Docker Hub of vanuit geverifieerde privérepositories, om de beveiligingsrisico's te verkleinen.

Het wordt sterk aanbevolen optimaliseer de afbeeldingsgrootte gebruikmakend van lichtgewicht basisafbeeldingen, meerfasige bouwprocessen en het verwijderen van tijdelijke bestanden of onnodige artefacten. Kleinere afbeeldingen worden sneller gedownload en versnellen de implementatie op Kubernetes.

Een ander belangrijk punt is het gebruik van volumes voor gegevenspersistentieIn plaats van informatie in containers op te slaan, leidt het verlies of de heraanmaak van een container niet tot verlies van belangrijke gegevens.

Het beperken van de resources die aan elke container worden toegewezen (CPU, geheugen, I/O) helpt om Voorkom dat één enkele dienst de host monopoliseert. en de rest te degraderen. Bovendien moeten containers worden gemonitord met tools zoals Docker Stats of meer geavanceerde oplossingen om de controle in productie te behouden.

Bij Kubernetes is het essentieel om de clusterarchitectuur en de componenten ervan te begrijpen voordat je het in productie neemt. Dit voorkomt veel problemen.

Het is ook een goed idee zoveel mogelijk automatiserenGebruik replicatiecontrollers, autoscalers en Jobs voor batchuploads; profiteer van rolling updates en rollbacks; en definieer versiebeheerde declaratieve manifesten in Git-repositories.

Veiligheid moet altijd de hoogste prioriteit hebben: Beperk de toegang tot de API-server, beheer inloggegevens met behulp van geheimen en versleutel gegevens tijdens overdracht en opslag.Voer regelmatig patches uit en definieer netwerkbeleid dat de communicatie tussen services beperkt volgens het principe van minimale bevoegdheden.

Tot slot is het essentieel om te beschikken over goede gecentraliseerde monitoring- en logboeksystemenEn dat geldt ook voor pre-productieomgevingen waar wijzigingen grondig kunnen worden getest voordat ze naar de productieomgeving worden doorgevoerd, waardoor risico's en onaangename verrassingen worden verminderd.

Dit complete ecosysteem van microservices, Docker-containers en Kubernetes-orkestratie stelt je in staat systemen te bouwen die veel flexibeler, schaalbaarder en veerkrachtiger zijn dan traditionele monolithische systemen. Door een doordachte architectuur, de juiste tools en de beste DevOps-praktijken te combineren, kun je applicaties implementeren die zich naadloos aanpassen aan veranderingen in de werkbelasting, snel herstellen van storingen en gemakkelijker in de loop der tijd kunnen worden doorontwikkeld.

Gepassioneerd schrijver over de wereld van bytes en technologie in het algemeen. Ik deel mijn kennis graag door te schrijven, en dat is wat ik in deze blog ga doen: je de meest interessante dingen laten zien over gadgets, software, hardware, technologische trends en meer. Mijn doel is om u te helpen op een eenvoudige en onderhoudende manier door de digitale wereld te navigeren.