- Arsitektur microservices memungkinkan pengembangan aplikasi yang modular dan skalabel, di mana setiap layanan bersifat otonom dan dapat diimplementasikan secara independen.

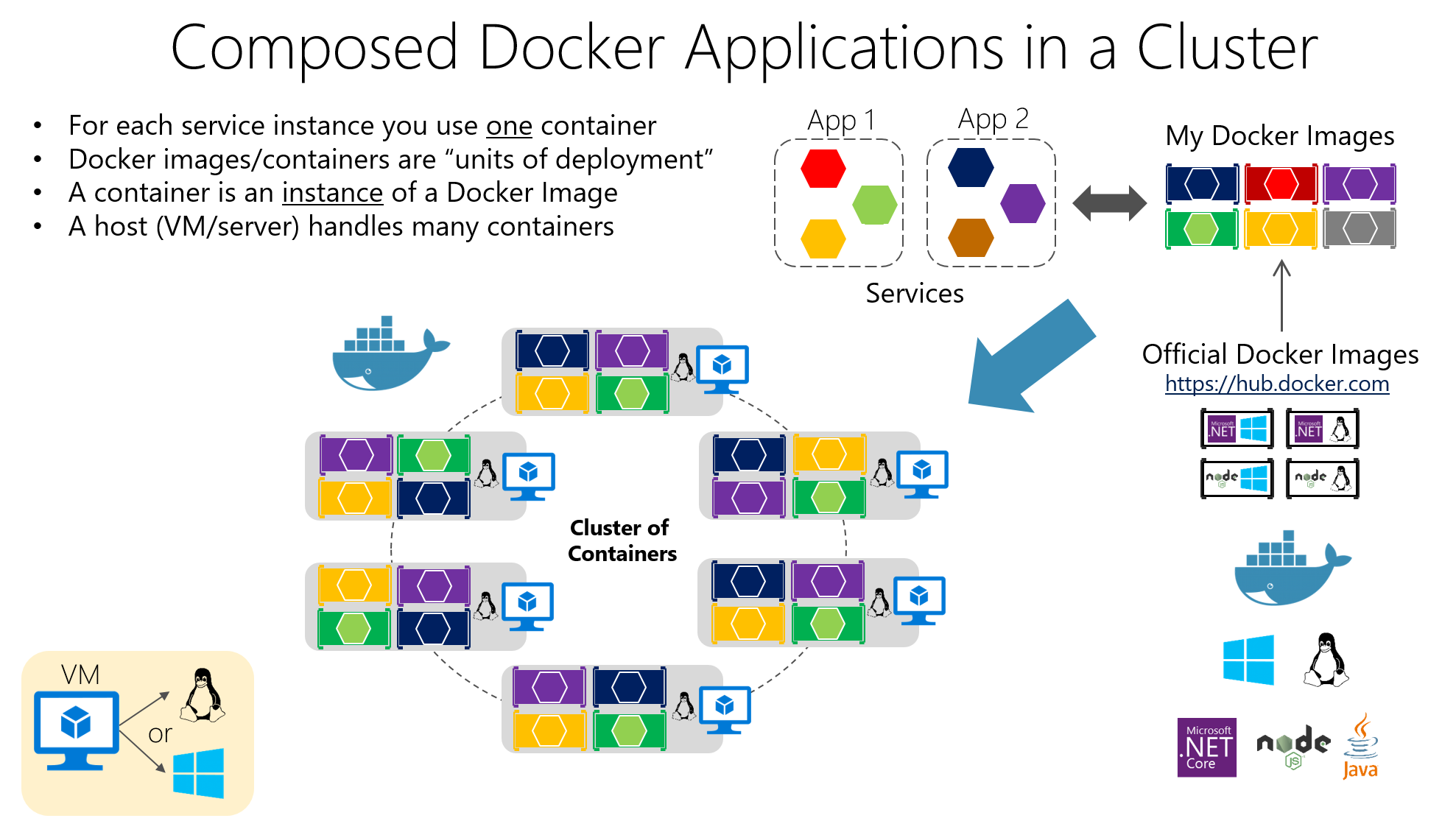

- Docker memudahkan pembuatan kontainer ringan dan portabel yang mengemas setiap layanan mikro beserta semua dependensinya.

- Kubernetes mengatur kontainer, mengelola penyebaran, penskalaan, jaringan, dan pemulihan otomatis layanan mikro dalam klaster.

- Menerapkan praktik keamanan, pemantauan, dan otomatisasi yang baik adalah kunci keberhasilan pengoperasian microservices di lingkungan produksi.

Dalam beberapa tahun terakhir, kombinasi dari microservices, Docker, dan Kubernetes Arsitektur terdistribusi telah menjadi standar de facto untuk menerapkan aplikasi modern, terukur, dan mudah dipelihara. Semakin banyak perusahaan beralih dari aplikasi monolitik ke arsitektur terdistribusi yang lebih sesuai dengan lingkungan yang berubah dan strategi DevOps.

Jika Anda bertanya-tanya Cara mengimplementasikan microservices dengan Docker dan Kubernetes dalam praktik.Konten ini akan sangat cocok untuk Anda: kami akan mengulas konsep-konsep kunci, keunggulan dan tantangan, cara membuat kontainer, cara mengorkestrasikannya dalam sebuah klaster, dan langkah-langkah yang harus diikuti untuk menginstalnya. Windows y Linuxserta serangkaian kiat untuk menggunakannya dengan bijak di lingkungan dunia nyata.

Apa itu arsitektur microservices dan apa perbedaannya dengan arsitektur monolit?

Arsitektur microservices didasarkan pada Membagi aplikasi menjadi beberapa layanan kecil, otonom, dan dapat diimplementasikan secara independen.Masing-masing berfokus pada fungsi spesifik (pengguna, pembayaran, katalog, pesanan, dll.), yang berkomunikasi terutama melalui API ringan (HTTP/REST, gRPC, perpesanan, dll.).

Sebaliknya, dalam aplikasi monolitik, Semua logika bisnis, lapisan presentasi, dan akses data dikemas ke dalam satu blok penerapan tunggal.Setiap perubahan memerlukan kompilasi ulang, pengujian, dan penerapan seluruh sistem, yang mempersulit evolusi dan meningkatkan risiko munculnya kesalahan dalam produksi.

Dengan arsitektur microservices, setiap layanan memiliki siklus hidupnya sendiri: Sistem ini dapat dikembangkan, diuji, diterapkan, diskalakan, dan dikelola versinya secara independen.Hal ini memungkinkan beberapa tim untuk bekerja secara paralel, menyederhanakan adopsi teknologi baru, dan memfasilitasi integrasi dengan praktik CI/CD.

Selain itu, arsitektur ini memperkenalkan konsep tentang skalabilitas independen komponenAlih-alih meningkatkan skala seluruh aplikasi monolitik untuk mendukung beban yang lebih besar pada modul tertentu, hanya layanan mikro yang benar-benar membutuhkannya yang ditingkatkan skalanya, sehingga mengoptimalkan sumber daya infrastruktur dengan lebih baik.

Keunggulan dan tantangan nyata dari layanan mikro

Migrasi ke arsitektur microservices bukan sekadar tren sesaat: Hal ini memberikan manfaat nyata dalam hal skalabilitas, ketahanan, dan kecepatan penerapan.Namun, hal ini juga menghadirkan kompleksitas operasional yang harus dikelola.

Salah satu keuntungan yang paling menonjol adalah skalabilitas independen dari setiap layananJika, misalnya, modul pembayaran menerima lebih banyak trafik daripada modul administrasi, Anda hanya perlu meningkatkan replika dari microservice pembayaran, tanpa menyentuh bagian aplikasi lainnya atau membuang sumber daya.

Anda juga mendapatkan banyak keuntungan penyebaran berkelanjutan dan pengiriman yang seringDengan mengisolasi setiap layanan, dimungkinkan untuk merilis versi baru secara bertahap, tanpa harus menghentikan atau menyebarkan ulang seluruh aplikasi, sehingga mengurangi waktu pemeliharaan dan meningkatkan waktu pemasaran.

Poin penting lainnya adalah ketahanan dan toleransi kesalahanJika dirancang dengan benar, kegagalan satu microservice seharusnya tidak menyebabkan seluruh sistem ikut mati. Dengan pola seperti timeout, percobaan ulang, dan circuit breaker, layanan lain dapat terus merespons, sehingga membatasi dampak kegagalan tersebut.

Selain itu, microservices memungkinkan fleksibilitas teknologiSetiap tim dapat memilih bahasa, kerangka kerja, atau basis data yang paling sesuai untuk layanan mereka, selama mereka menghormati kontrak komunikasi dan kebijakan global platform tersebut.

Di sisi lain dari koin tersebut, kita menemukan kompleksitas operasional dan observabilitasMengelola puluhan atau ratusan layanan melibatkan penanganan jaringan terdistribusi, pelacakan antar layanan, pencatatan terpusat, keamanan, pembuatan versi API, dan konsistensi data, yang membutuhkan alat canggih dan proses yang matang.

Ini juga menjadi rumit. manajemen komunikasi antar layananSangat penting untuk merancang dengan cermat bagaimana data dipertukarkan, bagaimana kesalahan ditangani, bagaimana latensi dikelola, dan bagaimana mencegah ketergantungan yang lambat memperlambat sistem lainnya. Pengujian dan debugging tidak lagi menjadi hal yang sepele, karena Bukan hanya satu blok yang diuji, melainkan serangkaian layanan yang saling terhubung..

Kontainer: fondasi untuk menjalankan layanan mikro secara terisolasi.

Teknologi kontainer telah menjadi pendukung ideal untuk layanan mikro karena... Ini memungkinkan Anda untuk mengemas aplikasi dan semua dependensinya ke dalam satu unit yang terstandarisasi dan portabel.Alih-alih menginstal pustaka, runtime, dan alat di setiap server, semuanya berjalan di dalam kontainer.

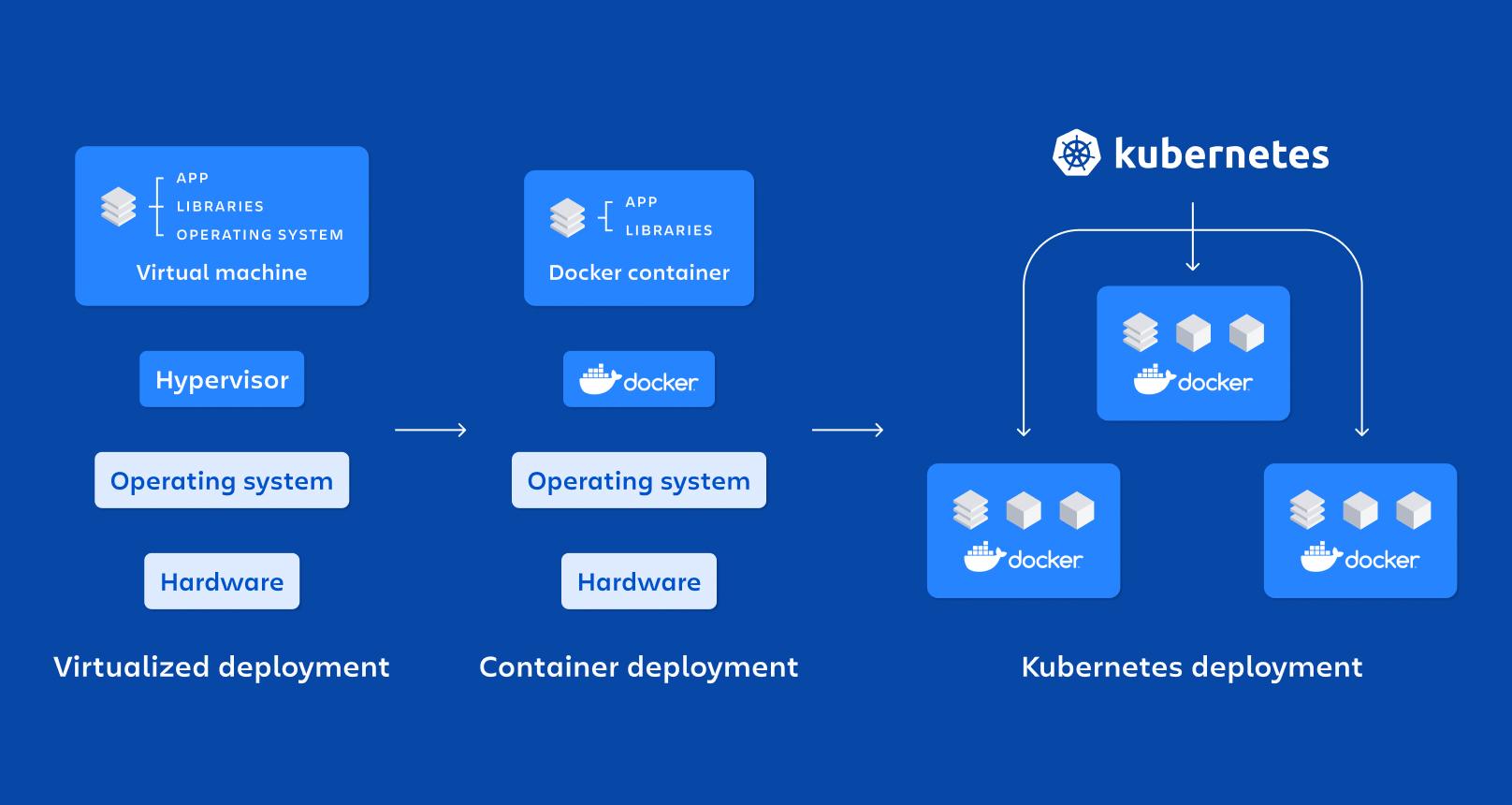

Pada dasarnya, sebuah wadah adalah... bentuk virtualisasi tingkat sistem operasi yang ringan: berbagi kernel host tetapi menjalankan proses dalam namespace terisolasi dan dengan sumber daya yang dibatasi oleh cgroup, yang membuatnya booting lebih cepat dan mengonsumsi lebih sedikit daripada mesin virtual.

Di antara sifat-sifat utamanya adalah isolasi, portabilitas, ringan, dan modularitasSetiap layanan mikro yang berjalan dalam kontainernya sendiri menjadi lebih mudah untuk diimplementasikan, dihentikan, diperbarui, atau direplikasi, yang sangat sesuai dengan prinsip-prinsip arsitektur terdistribusi.

Dibandingkan dengan mesin virtual untuk produksiwadah-wadah tersebut Mereka tidak memerlukan sistem operasi lengkap untuk setiap instance.melainkan berbagi milik host. Ini secara drastis mengurangi ukuran gambar dan el tiempo de bootmemungkinkan Anda untuk mengangkat atau menghancurkan kontainer dalam hitungan detik.

Docker: platform referensi untuk mengemas layanan mikro ke dalam kontainer.

Docker adalah alat yang paling populer untuk bekerja dengan kontainer, karena Hal ini mempermudah pembuatan, pengemasan, distribusi, dan eksekusi aplikasi berbasis kontainer. baik di lingkungan pengembangan maupun di lingkungan pengujian dan produksi.

Ide utama mereka adalah mengemas perangkat lunak ke dalam Gambar DockerIni adalah artefak yang tidak dapat diubah yang mencakup kode aplikasi, pustaka yang dibutuhkannya, alat sistem, dan konfigurasi dasar. Aplikasi dibuat dari citra-citra ini. kontainer dalam pengoperasian, yang merupakan contoh-contoh terisolasi berdasarkan gambar tersebut.

Konstruksi gambar didefinisikan dalam sebuah Dockerfile, sebuah file teks yang menentukan instruksi seperti citra dasar, direktori kerja, file mana yang akan disalin, dependensi mana yang akan diinstal, port mana yang akan diekspos, dan perintah mana yang akan dijalankan saat memulai kontainer.

Bayangkan Anda memiliki API yang ditulis dalam Node.js. Anda dapat membuat Dockerfile yang mirip dengan berikut ini, di mana Dimulai dengan image Node resmi, file disalin, dependensi diinstal, dan perintah boot ditentukan.:

FROM node:14

WORKDIR /app

COPY . .

RUN npm install

EXPOSE 3000

CMD

File ini menunjukkan bahwa aplikasi akan berjalan di direktori tersebut. /aplikasi di dalam kontainer, bahwa dependensi akan diinstal dengan npm, bahwa port 3000 akan diekspos, dan bahwa, setelah memulai kontainer, ia akan mengeksekusi mulai npm.

Untuk membuat dan menjalankan kontainer tersebut, cukup jalankan perintah dari folder proyek. membangun buruh pelabuhan dan sesudahnya buruh pelabuhanmemetakan port untuk memungkinkan akses dari host, atau untuk aplikasi multi-kontainer gunakan docker-compose:

docker build -t mi-app .

docker run -p 3000:3000 mi-app

Berkat model ini, Masalah klasik "berjalan di mesin saya" diminimalkan.Karena lingkungan runtime menyertai aplikasi. Selain itu, Docker terintegrasi dengan mulus dengan sistem CI/CD, registri pribadi, dan alat orkestrasi seperti Kubernetes.

Komponen-komponen kunci dalam Docker dan peranannya dalam layanan mikro

Dalam penerapan tipikal, kita berbicara tentang sebuah Tuan Rumah Dockeryaitu sistem (fisik atau virtual) tempat Docker diinstal; Docker berjalan di atas sistem tersebut. Mesin Docker, yaitu daemon yang mengelola image, jaringan, volume, dan siklus hidup kontainer.

Wadah-wadah tersebut berisi aplikasi dan dependensinya dikemas dalam sebuah imageHal ini memungkinkan server mana pun yang menggunakan Docker untuk menjalankan image tersebut secara konsisten. Konsistensi ini sangat penting ketika Anda memiliki banyak microservice yang diimplementasikan di berbagai lingkungan (pengembangan, QA, produksi, dll.).

Di antara keunggulan Docker yang paling menarik adalah: portabilitas antar lingkungan, otomatisasi penerapan, modularitas proses, dan dukungan untuk layering dan kontrol versi dalam image.yang memudahkan untuk membalikkan perubahan dan mengoptimalkan penyimpanan.

Kubernetes: orchestrator untuk mengatur ratusan kontainer

Ketika Anda beralih dari beberapa kontainer menjadi puluhan atau ratusan kontainer, Mengelolanya secara manual menjadi hal yang gila.Di situlah Kubernetes berperan, sebuah platform sumber terbuka yang dirancang untuk mengatur kontainer dalam skala besar.

Kubernetes mengotomatiskan tugas-tugas penting seperti penyebaran, penskalaan, pemulihan kesalahan, konfigurasi jaringan, dan penyimpanan dari aplikasi berbasis kontainer. Dirancang untuk bekerja di cloud publik, cloud pribadi, lingkungan hibrida, dan bahkan di lingkungan on-premises.

Fokusnya adalah pada pengelolaan klaster yang terdiri dari beberapa node (mesin) tempat kontainer berjalan. Tujuannya adalah untuk memastikan bahwa Aplikasi selalu berada dalam kondisi yang diinginkan.: jumlah replika, versi yang diimplementasikan, sumber daya yang dialokasikan, dan konektivitas antar layanan.

Elemen-elemen fundamental Kubernetes

Unit terkecil di Kubernetes adalah PolongPod mewakili satu atau lebih instance kontainer yang harus berjalan bersama (misalnya, kontainer aplikasi dan kontainer sidecar untuk pencatatan log). Pod bersifat sementara. Mereka diciptakan, dihancurkan, dan diganti sesuai dengan kebutuhan klaster..

Untuk mengekspos Pod Anda, Kubernetes menawarkan sumber daya tersebut. Pelayananyang bertindak sebagai lapisan abstraksi jaringan. Sebuah Layanan mengelompokkan sekumpulan Pod dan Ini menyediakan alamat IP yang stabil, nama DNS, dan penyeimbangan beban internal.agar pelanggan tidak perlu mengetahui detail setiap Pod.

Sumber daya Penyebaran Ini digunakan untuk menentukan bagaimana Pod harus di-deploy dan diperbarui: berapa banyak replika, image mana yang akan digunakan, tag mana yang akan diterapkan, dan strategi pembaruan mana yang akan diikuti. Kubernetes menangani hal ini. selalu mempertahankan jumlah Pod yang diinginkan agar tetap berjalan dan untuk melakukan pembaruan bergulir atau pengembalian (rollback) saat Anda mengubah konfigurasi.

Tersedia juga sumber daya seperti ConfigMap dan SecretFitur-fitur ini memungkinkan Anda untuk mengexternalisasi konfigurasi dan menyimpan data sensitif (kata sandi, token, kunci API) tanpa harus mengemasnya di dalam image. Hal ini sangat menyederhanakan manajemen konfigurasi yang aman di berbagai lingkungan.

Cara mengatur klaster Kubernetes

“Kepala” dari klaster tersebut adalah Rencana Kontrol Kubernetesyang mengelompokkan beberapa komponen yang bertanggung jawab untuk mengatur keseluruhan sistem. Di antaranya adalah Server APIyang merupakan gerbang untuk mengelola klaster; setiap tindakan (membuat Deployment, mendaftarkan Pod, memodifikasi Service) dilakukan melalui API ini.

El Penjadwal Tugasnya adalah menentukan node mana yang akan digunakan setiap Pod, dengan mempertimbangkan sumber daya, afinitas, dan batasan yang tersedia; sedangkan Manajer Pengontrol Pantau status klaster dan ambil tindakan untuk memastikan kenyataan sesuai dengan apa yang telah Anda nyatakan dalam manifest (misalnya, buat Pod baru jika jumlahnya kurang dari yang Anda minta).

Penyimpanan negara didelegasikan kepada dllBasis data terdistribusi menyimpan konfigurasi dan informasi untuk semua sumber daya klaster. Selain itu, proses seperti berikut berjalan di setiap node pekerja: kubus (agen yang menghubungkan node dengan Server API), kube-proxy (yang mengelola lalu lintas jaringan dan penyeimbangan beban) dan waktu proses kontainer (Docker, containerd, CRI-O, dll.).

Menerapkan microservice di Kubernetes dengan file YAML

Untuk menerapkan microservice di Kubernetes, biasanya microservice tersebut dijelaskan dengan sebuah Manifesto YAMLDi sinilah Anda menentukan Deployment (template Pod, image, port, jumlah replika, label) dan Service yang sesuai untuk mengeksposnya di dalam atau di luar cluster.

Contoh dasar Deployment untuk aplikasi bernama “my-app” mungkin terlihat seperti ini, di mana Tiga replika dan port 3000 didefinisikan. sebagai pelabuhan kontainer:

apiVersion: apps/v1

kind: Deployment

metadata:

name: mi-app

spec:

replicas: 3

selector:

matchLabels:

app: mi-app

template:

metadata:

labels:

app: mi-app

spec:

containers:

- name: mi-app

image: mi-app:latest

ports:

- containerPort: 3000

Manifesto ini menunjukkan bahwa klaster harus mempertahankan tiga Pod beroperasi Dengan image “my-app:latest”, semuanya diberi tag app=my-app, sehingga sebuah Service dapat menemukannya dan mendistribusikan trafik di antara mereka. Kubernetes secara otomatis menangani logika untuk penskalaan, pembaruan, dan penggantian Pod jika terjadi kegagalan.

Bersamaan dengan Deployment, biasanya didefinisikan juga Layanan dengan tipe tertentu. ClusterIP, NodePort atau LoadBalancerTergantung pada apakah microservice hanya dapat diakses di dalam cluster, dari node, atau dari internet, semua konfigurasi ini diatur versinya dalam repositori, terintegrasi dengan mulus dengan pipeline CI/CD.

Penskalaan, peningkatan, dan perbaikan mandiri di Kubernetes

Salah satu alasan utama menggunakan Kubernetes adalah kemampuannya untuk Meningkatkan skala dan memperbarui layanan mikro tanpa menghentikan aplikasi.Anda dapat mengubah jumlah replika di manifest (atau dengan perintah kubectl) dan klaster akan menangani pembuatan atau penghapusan Pod hingga nilai yang diinginkan tercapai.

Penskalaan ini dapat dilakukan secara manual atau otomatis, dengan menggunakan sumber daya seperti Horizontal Pod Autoscaler (HPA)Fitur ini secara dinamis menyesuaikan replika berdasarkan metrik seperti CPU atau memori. Dengan demikian, kapasitas ditingkatkan selama periode permintaan tinggi, dan sumber daya dibebaskan ketika beban menurun.

Terkait pembaruan, Kubernetes mengimplementasikan pembaruan bergulir Secara default: ia membuat Pod dengan versi baru dan secara bertahap menghapus Pod dari versi sebelumnya, tanpa pemutusan mendadak. Jika terjadi kesalahan, rollback Ini memungkinkan Anda untuk memulihkan versi sebelumnya dengan cepat.

Fungsi penting lainnya adalah perbaikan sendiriJika sebuah kontainer atau Pod mati, Kubernetes akan secara otomatis membuatnya kembali; jika sebuah node berhenti merespons, Pod yang terpengaruh akan dijadwalkan ulang pada node lain yang tersedia, sehingga aplikasi tetap beroperasi.

Pemantauan dan observabilitas layanan mikro di Kubernetes

Untuk mengoperasikan lingkungan microservices dengan benar, tidak cukup hanya dengan melakukan deployment dan scale: Anda memerlukan visibilitas waktu nyata terhadap kinerja dan status layanan.Di Kubernetes, sangat umum untuk mengintegrasikan alat-alat seperti Prometheus untuk mengumpulkan metrik dan Grafana untuk memvisualisasikannya.

Prometheus menangani "pengambilan" metrik dari Pod, node, dan komponen klaster, menyimpannya, dan memungkinkan Anda untuk menentukan peringatan tentang metrik tersebut; dikombinasikan dengan Grafana, Anda dapat membuat dasbor tempat Pantau penggunaan CPU, memori, kesalahan HTTP, latensi, jumlah replika, atau status node. dengan sangat jelas.

Selain itu, kubectl menawarkan perintah Untuk memeriksa status Deployment, Layanan, Pod, dan sumber daya lainnya, lihat logIni termasuk mendeskripsikan peristiwa atau mengakses kontainer untuk debugging. Semua ini adalah bagian dari strategi observabilitas yang, dalam arsitektur microservices, Ini bukan pilihan jika Anda ingin tidur nyenyak..

Hubungan antara microservices, Docker, dan Kubernetes

Microservices, Docker, dan Kubernetes saling melengkapi seperti kepingan puzzle yang sama: Arsitektur microservices mendefinisikan cara Anda mendesain aplikasi, Docker menangani pengemasan dan menjalankan setiap layanan, dan Kubernetes mengatur semua kontainer tersebut. dalam sebuah kelompok.

Setiap layanan mikro dienkapsulasi dalam sebuah image Docker yang menyertakan kode dan dependensinyaHal ini memastikan bahwa aplikasi tersebut berperilaku sama di laptop pengembang, di lingkungan pengujian, atau di lingkungan produksi cloud. Pengemasan yang konsisten ini sangat penting bagi filosofi DevOps.

Sementara itu, Kubernetes bertindak sebagai pengatur kontainerSistem ini menentukan berapa banyak instance dari setiap microservice yang harus dijalankan, di mana lokasinya, bagaimana lalu lintas didistribusikan ke instance tersebut, bagaimana cara pemulihan dari kegagalan, dan bagaimana cara penskalaan saat permintaan meningkat atau menurun.

Dalam aplikasi e-commerce, misalnya, Anda dapat memiliki microservice untuk otentikasi, katalog, keranjang belanja, dan pembayaran, masing-masing dengan image Docker dan deployment Kubernetes sendiri. Dengan cara ini, Anda dapat meningkatkan skala katalog dalam kampanye besar-besaran atau pembayaran pada saat-saat kritis tanpa memengaruhi yang lainnya.dan mengatur seluruh siklus hidupnya mulai dari pipeline CI/CD hingga pemantauan pasca-produksi.

Cara Menginstal Docker dan Kubernetes di Windows

Jika Anda bekerja dengan Windows, cara termudah untuk memulai adalah dengan menginstal Desktop Dockeryang mencakup mesin Docker dan alat tambahan, bahkan opsi untuk mengaktifkan Kubernetes yang terintegrasi ke dalam mesin Anda.

Proses tipikalnya meliputi: Unduh Docker Desktop dari situs web resminya.Jalankan program instalasi (Docker Desktop Installer.exe) dan ikuti panduannya. Selama instalasi, Anda dapat memilih antara menggunakan Hyper-V atau WSL 2 sebagai teknologi virtualisasi; jika hanya ada satu yang tersedia, maka itulah yang akan digunakan.

Setelah sistem dimulai ulang, membuka Docker Desktop akan menginisialisasi lingkungan kontainer; jika virtualisasi tidak diaktifkan, penginstal itu sendiri biasanya menawarkan mengaktifkannya secara otomatisDari situ Anda dapat menjalankan kontainer, misalnya, Nginx atau aplikasi Anda sendiri.

Untuk menggunakan Kubernetes di Windows, Anda harus terlebih dahulu mengaktifkan Docker dan kemampuan virtualisasi. Kemudian, Anda dapat mengaktifkan Kubernetes dari Docker Desktop atau Instal dan konfigurasikan kubectl untuk mengelola klaster eksternal dan, jika sesuai, menyebarkan dasbor Kubernetes melalui manifes jarak jauh.

Setelah dikonfigurasi, Anda akan dapat mengakses dasbor melalui proxy lokal, menggunakan token otentikasi yang dihasilkan dengan kubectl dan mengarah, misalnya, ke file konfigurasi. .kube/config untuk mengelola akses ke klaster dari browser.

Menginstal Docker dan Kubernetes di Linux

Pada sistem Linux, seperti Ubuntu, menginstal Docker biasanya cukup mudah: Paket-paket diperbarui, mesin Docker diinstal, dan lingkungan diperiksa untuk memastikan semuanya berfungsi dengan benar. Menjalankan kontainer pengujian.

Langkah-langkah umumnya meliputi memperbarui sistem dengan apt-get update dan apt-get upgradeHapus semua versi Docker Desktop sebelumnya, jika ada, lalu instal docker-ce, docker-ce-cli, containerd.io, dan plugin docker-compose dari repositori resmi atau dengan menentukan versi yang diinginkan.

Untuk memverifikasi bahwa semuanya berjalan dengan baik, biasanya sebuah kontainer "hello-world" diluncurkan. Program ini mengunduh citra minimal dan menjalankannya.Jika pesan ditampilkan dengan benar, berarti Docker Anda sudah berjalan dan siap untuk memulai proses pengemasan layanan mikro Anda ke dalam kontainer.

Sedangkan untuk Kubernetes, di Linux dapat diinstal menggunakan alat-alat seperti... kubeadmAlur kerja tipikal melibatkan penambahan kunci repositori Kubernetes, mengkonfigurasi file daftar paket, menginstal kubeadm, dan memeriksa versinya.

Klaster kemudian diinisialisasi pada node master dengan kubeadm init (dengan menentukan rentang jaringan untuk Pod), perintah "join" diambil agar node pekerja bergabung dengan klaster dan akses lokal dikonfigurasi dengan membuat direktori. $HOME/.kubedengan menyalin file admin.conf dan menyesuaikan izinnya.

Dengan ini, Anda akan memiliki klaster dasar yang siap digunakan. menerapkan layanan mikro berbasis kontainerInstal jaringan Pod (Flannel, Calico, dll.) dan mulailah bekerja dengan Deployment, Service, dan sumber daya Kubernetes lainnya.

Praktik terbaik dan rekomendasi untuk menggunakan Docker dan Kubernetes

Untuk mendapatkan hasil maksimal dari lingkungan ini, disarankan untuk mengikuti serangkaian praktik terbaik dengan Docker, dimulai dengan Gunakan gambar resmi atau tepercaya., baik dari Docker Hub atau dari repositori pribadi yang terverifikasi, untuk mengurangi risiko keamanan.

Sangat dianjurkan mengoptimalkan ukuran gambar menggunakan citra dasar yang ringan, build multi-tahap, dan penghapusan file sementara atau artefak yang tidak perlu. Gambar yang lebih kecil diunduh lebih cepat dan mempercepat penyebaran di Kubernetes.

Poin penting lainnya adalah menggunakan volume untuk persistensi dataAlih-alih menyimpan informasi di dalam kontainer, hilangnya atau pembuatan ulang kontainer tidak berarti hilangnya data penting.

Membatasi sumber daya yang dialokasikan untuk setiap kontainer (CPU, memori, I/O) membantu untuk mencegah satu layanan memonopoli host. dan menurunkan kualitas sisanya. Selain itu, kontainer harus dipantau dengan alat seperti Docker Stats atau solusi yang lebih canggih untuk menjaga kendali di lingkungan produksi.

Dengan Kubernetes, sangat penting untuk memahami arsitektur klaster dan komponen-komponennya sebelum masuk ke tahap produksi. Hal ini mengurangi banyak masalah.

Itu juga ide yang bagus mengotomatiskan sebanyak mungkinGunakan replication controller, autoscaler, dan Job untuk unggahan batch; manfaatkan pembaruan dan rollback bergulir; dan definisikan manifest deklaratif versi di repositori Git.

Keselamatan harus selalu menjadi prioritas utama: Batasi akses ke Server API, kelola kredensial menggunakan Secret, enkripsi data saat dalam perjalanan dan saat disimpan.Terapkan patch secara berkala dan tetapkan kebijakan jaringan yang membatasi komunikasi antar layanan sesuai dengan prinsip hak akses minimal.

Terakhir, sangat penting untuk memiliki sistem pemantauan dan pencatatan terpusat yang baikserta dengan lingkungan pra-produksi di mana perubahan dapat diuji secara menyeluruh sebelum diterapkan ke klaster produksi, sehingga mengurangi risiko dan kejutan yang tidak menyenangkan.

Ekosistem lengkap yang terdiri dari microservices, kontainer Docker, dan orkestrasi Kubernetes ini memungkinkan Anda membangun sistem yang jauh lebih fleksibel, terukur, dan tangguh daripada sistem monolitik tradisional. Dengan menggabungkan arsitektur yang dipikirkan dengan matang, alat yang tepat, dan praktik terbaik DevOps, Anda dapat menerapkan aplikasi yang beradaptasi dengan mulus terhadap perubahan beban kerja, pulih dengan cepat dari kegagalan, dan lebih mudah dikembangkan dari waktu ke waktu.

Penulis yang bersemangat tentang dunia byte dan teknologi secara umum. Saya suka berbagi ilmu melalui tulisan, dan itulah yang akan saya lakukan di blog ini, menunjukkan kepada Anda semua hal paling menarik tentang gadget, perangkat lunak, perangkat keras, tren teknologi, dan banyak lagi. Tujuan saya adalah membantu Anda menavigasi dunia digital dengan cara yang sederhana dan menghibur.