- Die GPU-Passthrough-Funktion (vDGA/VMDirectPath I/O) in VMware ordnet einer VM eine vollständige physische GPU zu, um eine nahezu native Leistung zu erzielen.

- Seine Verwendung erfordert strenge Anforderungen Hardware (VT‑d/AMD‑V, IOMMU, MMIO 64‑bit) und EFI/UEFI-Firmware auf der virtuellen Maschine.

- Die Aktivierung von vDGA führt zum Verlust wichtiger vSphere-Funktionen wie vMotion, DRS und Snapshots auf der VM, die die GPU im Passthrough-Modus verwendet.

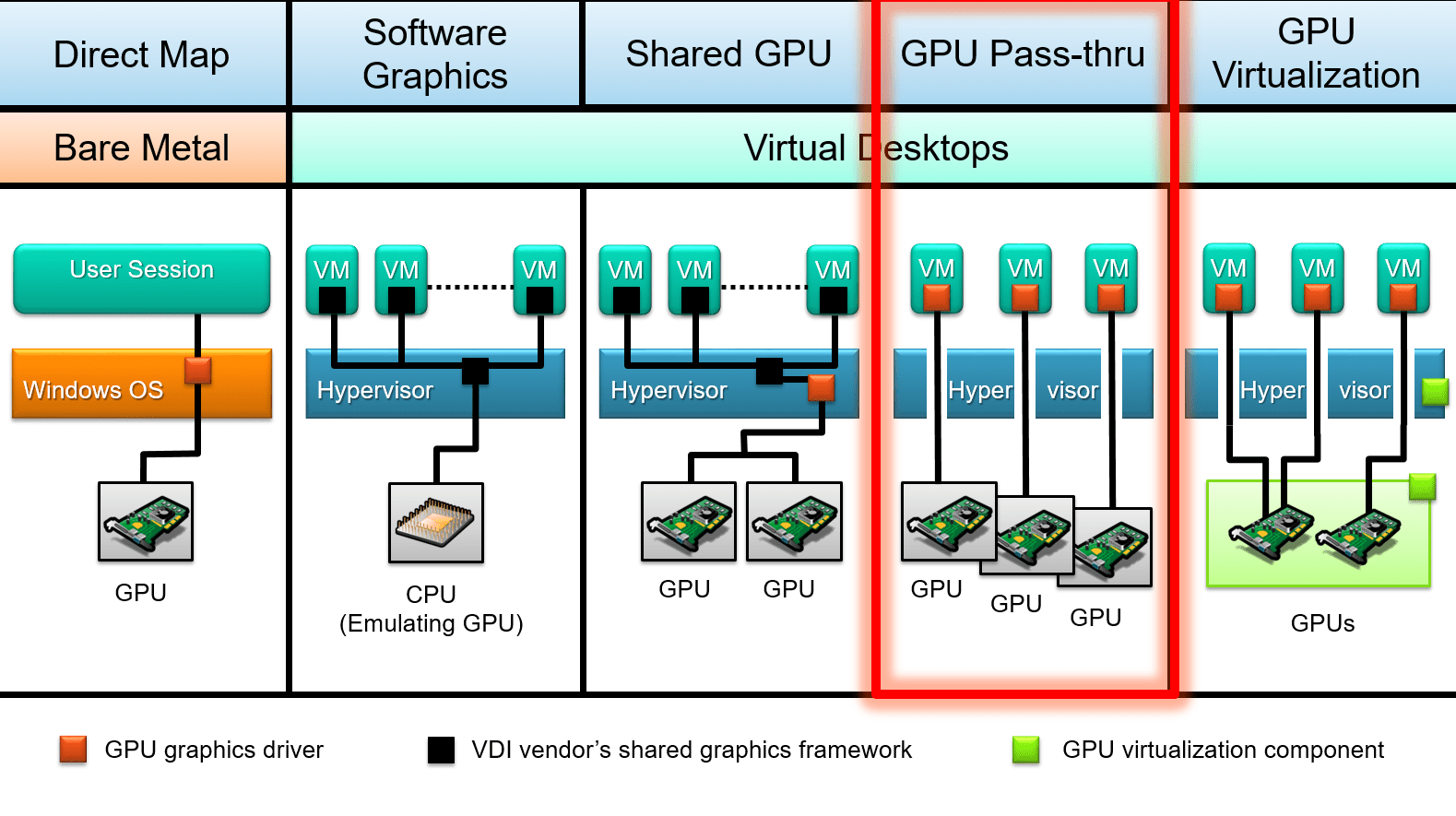

- Im Vergleich zu vGPU und anderen Lösungen priorisiert vDGA die dedizierte Leistung gegenüber Flexibilität und der Möglichkeit, die GPU zwischen mehreren VMs zu teilen.

Direkte Verbindung einer physischen GPU mit einer virtuellen Maschine in VMware Das ist eine jener Änderungen, die bei der Arbeit mit stark ausgelasteten Grafiken den entscheidenden Unterschied ausmachen. IA oder 3D-Rendering. Der Wechsel von einer emulierten Grafikkarte zu einem direkten Zugriff über Passthrough (vDGA / VMDirectPath I/O) kann die Leistung der VM der eines physischen Rechners annähern, bringt aber im Gegenzug eine ganze Reihe neuer Anforderungen und Einschränkungen mit sich, die vor Beginn unbedingt beachtet werden sollten.

Darüber hinaus existieren im aktuellen Ökosystem mehrere Möglichkeiten zur Nutzung der GPU in virtualisierten Umgebungen nebeneinander: Dedizierter Passthrough, gemeinsam genutzte vGPU und Technologien wie BitFusion oder GPU-PartitionierungDas Verständnis dafür, was die einzelnen Komponenten leisten, in welchen Fällen sie eingesetzt werden und wie sie in vSphere/ESXi konfiguriert werden (und wie sie sich auf ähnliche Technologien wie Hyper-V DDA beziehen), ist der Schlüssel, um nicht in einer Sackgasse mit der Hardware oder der gewählten Hypervisor-Version zu landen.

Was ist GPU-Passthrough (vDGA / VMDirectPath I/O) in VMware?

GPU-Passthrough in VMware, auch bekannt als vDGA oder VMDirectPath I/ODies ist ein Betriebsmodus, in dem eine im ESXi-Host installierte physische Grafikkarte direkt einer virtuellen Maschine zugewiesen wird. Anstatt einen vom Hypervisor emulierten Grafikadapter zu verwenden, erkennt das Gastbetriebssystem die GPU nahezu so, als wäre sie an ein physisches Motherboard angeschlossen.

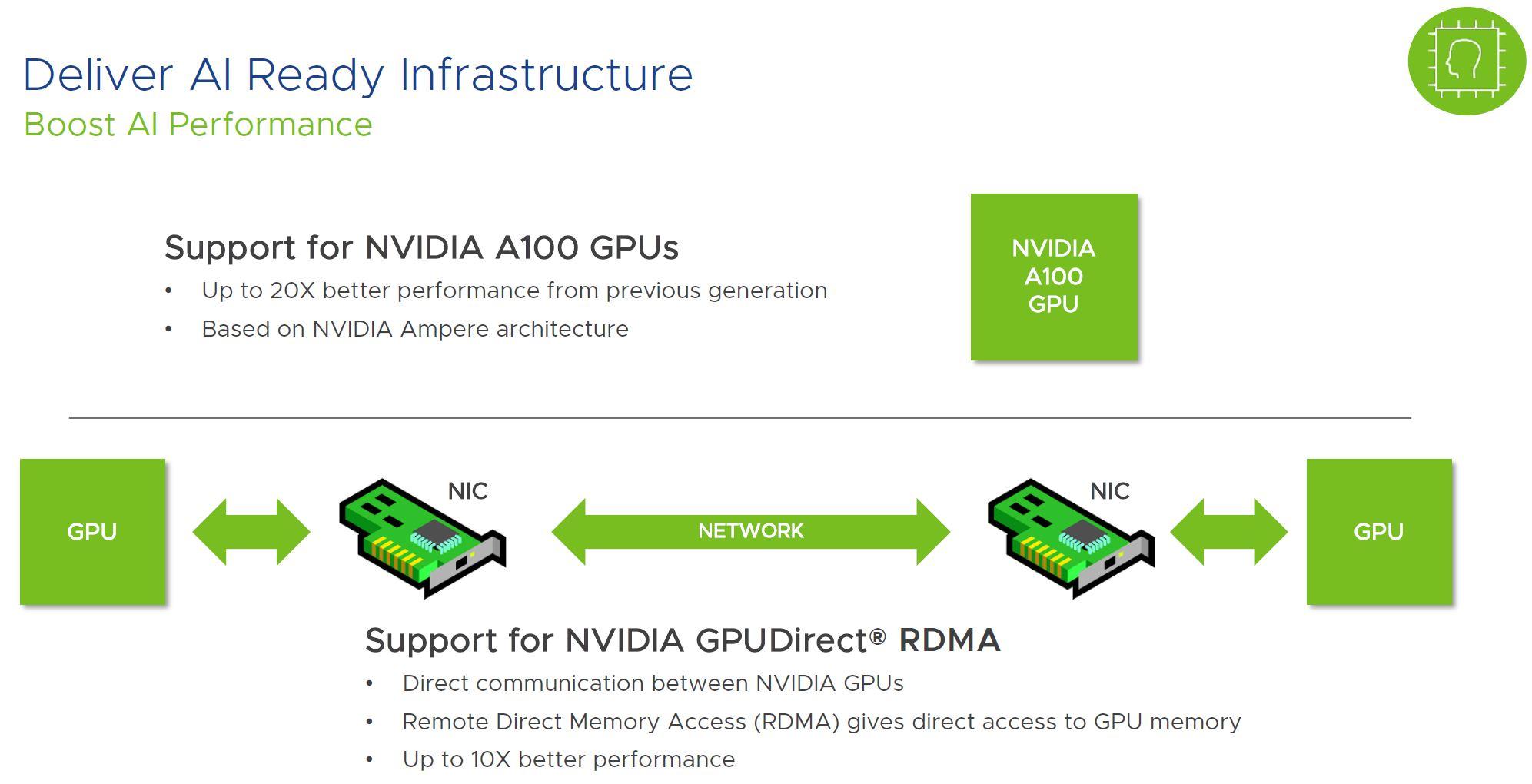

Diese Abkürzung ermöglicht es der VM, Vorteile zu nutzen. Die gesamte Leistung des Grafikchips, seines Videospeichers und seiner fortschrittlichen Funktionen Technologien wie CUDA, OpenCL, Direct3D und OpenGL werden nativ unterstützt, mit nur geringem zusätzlichem Aufwand durch den Hypervisor. In VMware-Labortests wurde im Vergleich zum Betrieb derselben GPU auf einem Bare-Metal-System typischerweise ein Leistungsverlust von etwa 4–5 % festgestellt.

In der Praxis bedeutet die Verwendung von GPU-Passthrough, dass Diese Karte ist ausschließlich einer einzigen virtuellen Maschine zugeordnet.Es gibt keine fein abgestufte Ressourcenzuweisung zwischen mehreren VMs, und es wird auch keine Drittanbieter-Softwareschicht auf ESXi geladen, um die Grafikkarte gemeinsam zu nutzen, anders als bei vGPU-Lösungen wie beispielsweise NVIDIA NETZ.

Es ist wichtig, diesen Ansatz von anderen Methoden der GPU-Nutzung in der Virtualisierung zu unterscheiden, wie zum Beispiel NVIDIA vGPU (gemeinsame vGPU), RemoteFX/Partitionierung auf Hyper-V- oder BitFusion-artigen Lösungen, die versuchen, eine GPU oder einen Pool von GPUs auf mehrere Maschinen mit unterschiedlichen Virtualisierungs- oder Remote-Umleitungstechniken zu verteilen.

Wenn wir in der VMware-Welt über vDGA sprechen, beschreiben wir im Wesentlichen Folgendes: direkte Zuordnung des PCIe-Geräts der GPU zur VM unter Verwendung von VMDirectPath I/O, mit allen damit verbundenen Vor- (Leistung) und Nachteilen (Einschränkungen bei Mobilität und Hochverfügbarkeit).

Vorteile der Verwendung von GPU-Passthrough in vSphere

Der Hauptgrund für den Wechsel zu vDGA ist, dass Die Grafik- und Rechenleistung ist nahezu identisch mit der eines physischen Computers.Durch das Weglassen eines großen Teils der Virtualisierungsschicht für dieses PCIe-Gerät verschwinden die typischen Engpässe der emulierten GPU, und die VM kann mit Spielen, 3D-Anwendungen oder KI-Engines wesentlich reibungsloser arbeiten.

Dies wird besonders deutlich in Szenarien, in denen die integrierten GPUs oder die standardmäßig emulierte virtuelle Grafikkarte deutlich hinter den Erwartungen zurückbleiben: Fortgeschrittenes Grafikdesign, CAD, 3D-Modellierung und -Rendering, Videobearbeitung, Animation und SpieleentwicklungEs ist außerdem von entscheidender Bedeutung für das Training von Modellen des maschinellen Lernens und KI-Workloads, die stark auf CUDA oder vergleichbare Technologien angewiesen sind.

Ein weiterer klarer Vorteil ist die flexiblere Nutzung der Hardware auf Rechenzentrumsebene. Anstatt eines physischer Arbeitsplatz pro Benutzer oder pro ProjektEs ist möglich, einen ausreichend dimensionierten ESXi-Host mehreren VMs zuzuweisen, von denen jede über eine eigene GPU im Passthrough-Modus verfügt, und mit Zeitplänen oder Spitzenlasten zu experimentieren.

In bestimmten Umgebungen, insbesondere wenn Server mit freien PCIe-Steckplätzen bereits verfügbar sind, die Kosten pro Benutzer oder pro Projekt Es ist möglicherweise weniger aufwendig als die Wartung einer ganzen Reihe leistungsstarker physischer Workstations, insbesondere wenn die Grafikkarte nicht 24 Stunden am Tag benötigt wird und je nach Bedarf an intensiver Arbeit umkonfiguriert werden kann.

Schließlich ergibt sich auch ein indirekter Vorteil in Bezug auf Sicherheit und Betrieb: durch die Aufrechterhaltung der Grafik-Workloads innerhalb isolierter virtueller MaschinenWenn etwas schiefgeht (eine Sicherheitslücke ausgenutzt wird, ein problematischer Treiber vorliegt oder eine fehlerhafte Konfiguration vorliegt), ist es einfacher, die Auswirkungen einzudämmen, auf einen früheren Snapshot zurückzugreifen oder eine Sicherung wiederherzustellen, solange die Einschränkungen des Passthrough-Verfahrens, auf die wir später eingehen werden, beachtet werden.

GPU-Passthrough im Vergleich zu vGPU und anderen Alternativen

Innerhalb des VMware-Ökosystems gibt es verschiedene Möglichkeiten, eine Grafikkarte zu nutzen, und nicht alle davon erfordern, dass sie ausschließlich einer einzelnen VM zugewiesen wird. Die bekanntesten sind: vDGA / VMDirectPath I/O, vGPU (NVIDIA GRID oder andere) und Remote-Zugriffs-/Rechenlösungen wie BitFusion.

Im direkten Passthrough-Modus (vDGA) wird die GPU zugewiesen ausschließlich an eine virtuelle MaschineRechenkerne und VRAM werden nicht zwischen mehreren VMs geteilt, und die Rolle des Hypervisors beschränkt sich praktisch auf das Weiterleiten des PCIe-Geräts an den Gast. Es ist die am einfachsten zu verstehende Option und ähnelt am ehesten einem physischen Server mit dedizierter Grafikkarte.

Beim vGPU-Ansatz wird spezialisierte Software (zum Beispiel NVIDIA GRID vGPU auf VMware vSphereEs übernimmt die GPU-Virtualisierung auf Controller-Ebene und stellt virtuelle GPU-Instanzen bereit, die mehreren VMs gleichzeitig zugewiesen werden können. Jede Gastmaschine sieht einen „Slice“ der GPU mit garantierten oder gemeinsam genutzten Ressourcen.

vGPUs ermöglichen es mehreren virtuellen Desktops oder Servern, eine einzige Grafikkarte gemeinsam zu nutzen, was sehr nützlich ist in VDI, leichtgewichtige, beschleunigte Büroumgebungen, Grafikarbeitsplätze im Einzelhandel oder Gastgewerbe.oder Szenarien, in denen die maximale Grafikauslastung von Benutzer zu Benutzer ungleichmäßig verteilt ist. Im Gegenzug entsteht ein gewisser Mehraufwand, und die gleiche Spitzenleistung wie mit einer vollständig physischen GPU, die einer einzelnen VM zugewiesen ist, wird nicht erreicht.

Es gibt auch Lösungen wie zum Beispiel BitFusion Flexdirect und ähnliche TechnologienDadurch können GPUs über das Netzwerk von verschiedenen VMs genutzt werden, was ideal für KI- und HPC-Workloads ist, bei denen die GPU eher als entfernte Rechenressource denn als Grafikkarte für die grafische Benutzeroberfläche des Benutzers fungiert.

Wählen Sie zwischen vDGA, vGPU oder einem Remote-GPU-Modell. Es kommt darauf an, ob Sie eine GPU für eine einzelne Maschine voll ausnutzen müssen (Passthrough), ob Sie eine teure Karte auf viele Benutzer mit mittleren Arbeitslasten verteilen möchten (vGPU), oder ob der Schlüssel darin besteht, einen Pool von GPUs für verteiltes Rechnen zu orchestrieren (BitFusion und ähnliches).

Hardwarevoraussetzungen für die Verwendung von vDGA auf ESXi

Bevor Sie eine GPU-Passthrough-Bereitstellung in VMware planen, müssen Sie sicherstellen, dass die Die Hardwareplattform erfüllt eine Reihe von Bedingungen die über das bloße „Anschließen einer Grafikkarte an den Server“ hinausgehen.

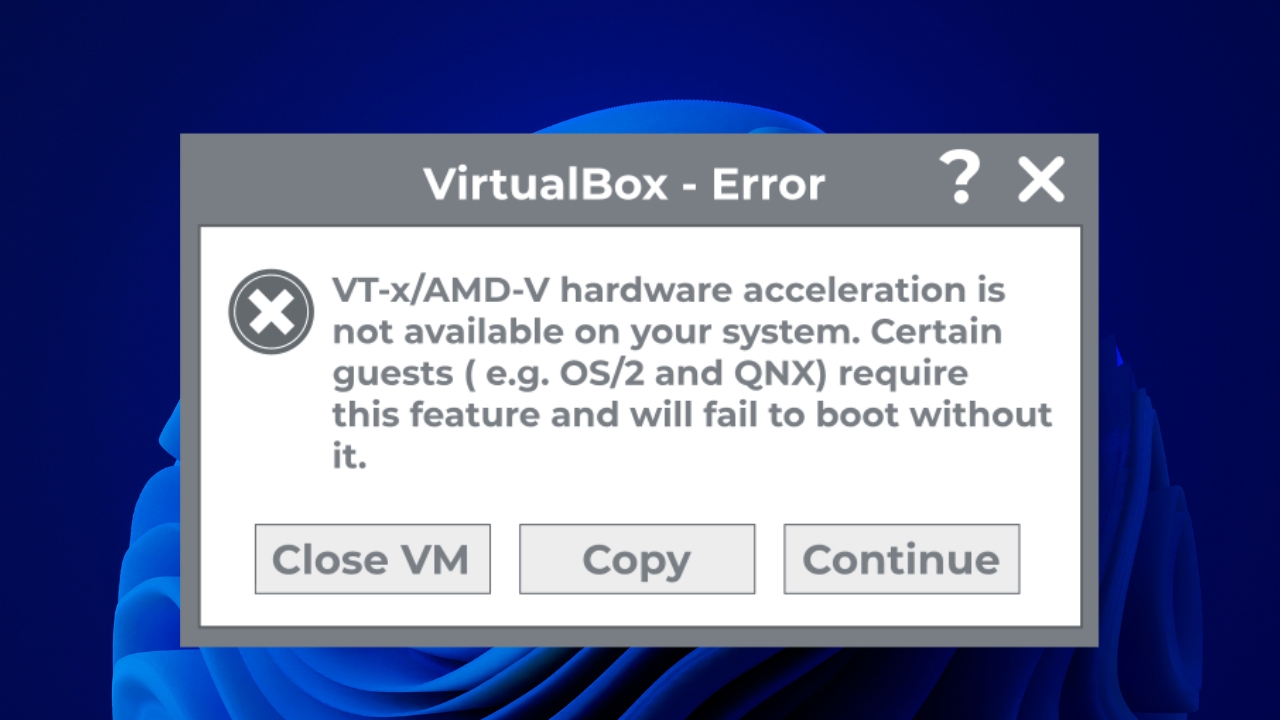

Zunächst müssen Prozessor und Chipsatz des ESXi-Host-Motherboards die folgenden Funktionen unterstützen: Virtualisierung mit IOMMU. in Intel Dies wird durch Intel VT-x und VT-dy sowie durch AMD über AMD-V mit IOMMU erreicht. Das BIOS/UEFI des Servers bietet hierfür üblicherweise spezifische Optionen. Virtualisierungserweiterungen aktivieren von Ein-/Ausgabe.

Zweitens müssen Sie überprüfen, ob die Stützplatte MMIO-Speicherabbildung über 4 GB (manchmal auch als „Dekodierung oberhalb von 4G“, „speicherbasierte E/A oberhalb von 4G“ oder ähnlich bezeichnet). Dies ist besonders wichtig bei High-End-GPUs wie z. B. TeslaP100, V100 und Äquivalente, die sehr große Speicherbereiche in ihren BAR (Basisadressregistern) deklarieren.

Einige dieser High-End-Karten können abbilden mehr als 16 GB MMIO-SpeicherplatzDeshalb, zusätzlich zum Spielen der BIOSAnschließend müssen bestimmte Parameter in den erweiterten VM-Einstellungen in vSphere angepasst werden, damit die VM mit dieser GPU ohne Fehler aufgrund unzureichender Ressourcen starten kann.

Natürlich muss die GPU selbst kompatibel mit der Serverplattform und vom Host-Hersteller (Dell, HPE, Lenovousw.) im Passthrough-Modus. In der Praxis funktionieren die meisten modernen PCIe-GPUs, es empfiehlt sich jedoch, die Kompatibilitätslisten zu überprüfen, insbesondere bei GRID-Karten oder sehr neuen Modellen.

Softwarevoraussetzungen und Versionskompatibilität

Auf Softwareebene ist es wichtig, klarzustellen, dass VMware unterstützt vDGA in vSphere 6.x und späteren Versionen.Allerdings haben einige Benutzer von spezifischen Problemen mit bestimmten Hardwarekombinationen berichtet (zum Beispiel NVIDIA GRID GPUs in Dell R720 Servern mit ESXi 6.x).

In solchen Fällen treten häufig Fehler wie „Gerät ist bereits in Gebrauch“ oder Symptome auf, die darauf hindeuten, dass Nach dem Upgrade von ESXi 5.5 auf 6.x funktionierte Passthrough nicht mehr.In Wirklichkeit geht es um spezifische Bugs, Änderungen im PCI-Gerätemanagement oder bei Treibern und nicht um eine offizielle Einstellung des Supports.

Das Gastbetriebssystem, das die GPU im Passthrough-Modus nutzen soll, muss Folgendes aufweisen: Offizielle Herstellertreiber sind in der VM installiert. (NVIDIA, AMD, Intel), da ESXi beim Einsatz von VMDirectPath I/O keinen spezifischen Treiber für diese Karte lädt; der Hypervisor stellt das Gerät einfach dem Gastsystem zur Verfügung.

Zusätzlich muss die VM so konfiguriert sein, dass sie in EFI- oder UEFI-Modus Bei der Verwendung von GPUs, die große MMIO-Speicherbereiche deklarieren, ist dieser Punkt entscheidend: Eine fehlerhafte VM-Firmware kann zu Fehlern führen. Starten oder dass die GPU vom Gastbetriebssystem nicht korrekt initialisiert wird.

Auf Clientseite, wenn der Zugriff auf die VM erfolgt über Remote-Desktop (RDP oder andere Protokolle)Es müssen die entsprechenden Richtlinien aktiviert werden, damit das Gastsystem in Remote-Sitzungen den Hardware-Grafikadapter verwendet und nicht auf einen generischen Treiber ohne Beschleunigung angewiesen ist.

Konfigurieren des ESXi-Hosts zur Verwendung der GPU im Passthrough-Modus

Der erste praktische Schritt besteht darin, die vSphere/ESXi-Server, um die GPU als DirectPath-E/A-Gerät bereitzustellenDies beinhaltet den Zugriff auf das BIOS, die Überprüfung des PCI-Inventars auf dem Host und die Markierung der Karte, damit sie VMs zugewiesen werden kann.

Benötigt die GPU große MMIO-Speicherbereiche (16 GB oder mehr), müssen Sie im BIOS/UEFI des Servers nach Optionen wie den folgenden suchen: „Dekodierung oberhalb von 4G“ oder „PCI 64-Bit-Ressourcenverwaltung oberhalb von 4G“ und aktivieren Sie sie. Die genaue Bezeichnung variiert je nach Hersteller, ist aber in der Regel in den PCI-Einstellungen oder im Bereich „Erweiterte Ressourcen“ zu finden.

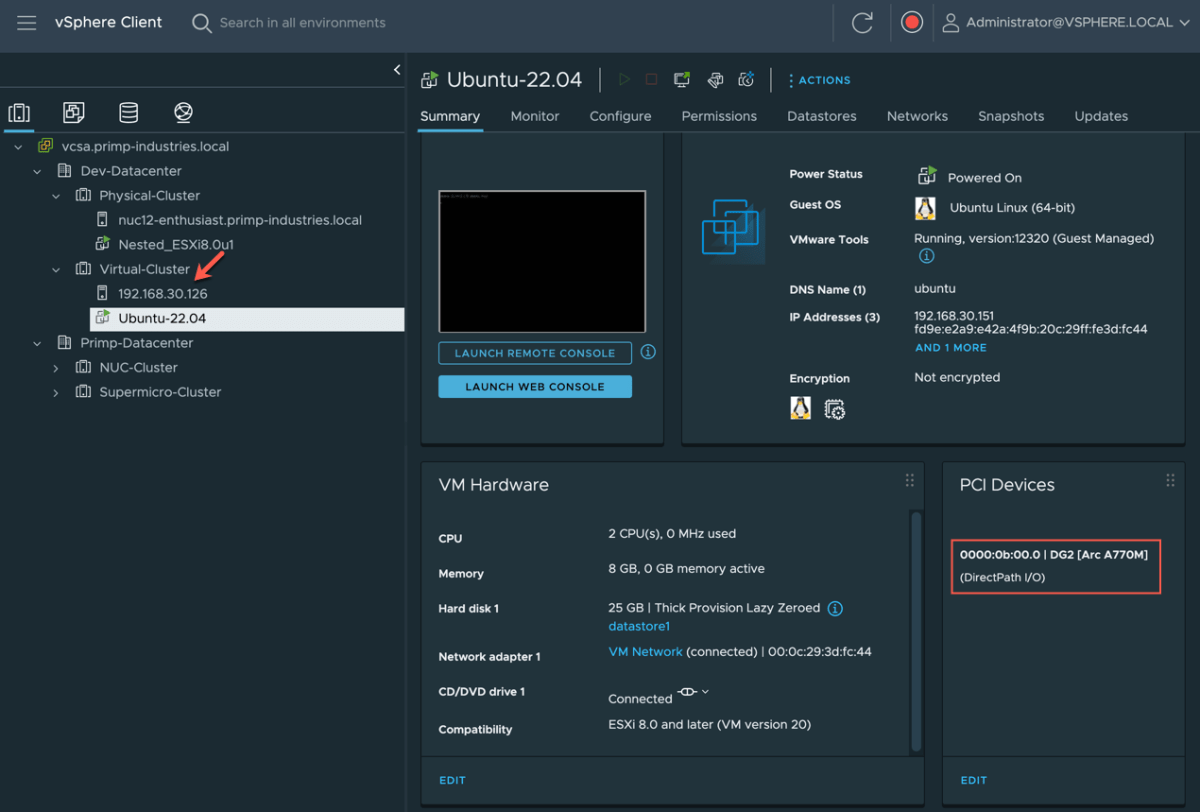

Sobald ESXi mit diesen Einstellungen gestartet wurde, können Sie im vSphere Client zum entsprechenden Host navigieren und darauf zugreifen. „Konfigurieren → Hardware → PCI-Geräte → Bearbeiten“ In der Liste der erkannten PCI-Geräte werden Ihnen NVIDIA-, AMD- oder ähnliche Karten zusammen mit der übrigen PCI-Hardware des Servers angezeigt.

Falls die GPU noch nicht für DirectPath I/O aktiviert ist, aktivieren Sie einfach das Kontrollkästchen. Durchreichekasten an Ihrem Eingang Innerhalb dieser Liste. Beim Speichern der Änderungen fordert vSphere Sie auf, den Host neu zu starten, um die Konfiguration anzuwenden, da der Hypervisor das Gerät reservieren und für die erneute Zuweisung an VMs vorbereiten muss.

Nach dem Neustart, beim Zurückkehren zum Abschnitt „Konfigurieren → Hardware → PCI-Geräte“ Es wird ein Fenster mit einem Titel wie „Für VMs verfügbare DirectPath I/O PCI-Geräte“ angezeigt, in dem alle Geräte aufgelistet sind, die für die Verwendung in virtuellen Maschinen verfügbar geworden sind, einschließlich GPUs und in vielen Fällen auch fortschrittlicher Netzwerkadapter wie Mellanox.

Vorbereiten und Konfigurieren der virtuellen Maschine

Nachdem der Host bereit ist, besteht der nächste Schritt darin, die virtuelle Maschine zu erstellen oder anzupassen, die die GPU nutzen soll. Zunächst muss sichergestellt werden, dass die VM Es wurde mit geeigneter EFI/UEFI-Firmware erstellt.insbesondere in Szenarien mit High-End-GPUs und hohem MMIO.

Im vSphere-Client wählen Sie einfach die VM aus und gehen zu „Einstellungen bearbeiten → VM-Optionen → Startoptionen“ Überprüfen Sie, ob im Feld „Firmware“ „EFI“ oder „UEFI“ ausgewählt ist. Falls nicht, muss dies geändert werden (und in manchen Fällen muss die VM oder das Betriebssystem neu erstellt werden, wenn es Hot-Swapping nicht unterstützt).

Bei Verwendung von Passthrough mit Karten, die mehr als 16 GB MMIO-Speicherplatz belegen, empfiehlt es sich, einige erweiterte Parameter in der VM-Konfiguration anzupassen, die über folgende Adresse zugänglich sind: „Einstellungen bearbeiten → VM-Optionen → Erweitert → Konfigurationsparameter → Konfiguration bearbeiten“Dort können Sie Schlüssel im Zusammenhang mit pciPassthru hinzufügen, um zu steuern, wie der Adressraum reserviert wird.

Insbesondere ist die Verwendung von 64-Bit-MMIO üblicherweise aktiviert und für diesen Bereich wird eine Größe definiert, die sich wie folgt berechnet: Wie viele High-End-GPUs werden der VM zugewiesen?Als Faustregel gilt üblicherweise, 16 mit der Anzahl der GPUs zu multiplizieren und das Ergebnis auf die nächste Zweierpotenz aufzurunden (beispielsweise würden zwei solcher GPUs 64 GB 64-Bit-MMIO ergeben).

Nach der Anpassung dieser Parameter wird die Installation durchgeführt oder es wird überprüft, ob die Das Gastbetriebssystem unterstützt EFI/UEFI und ist in der Lage, die fragliche Speichergröße und GPU zu verarbeiten.Zu diesem Zeitpunkt ist die Grafikkarte noch nicht mit der VM verbunden; die Umgebung wird lediglich vorbereitet, damit beim Anschluss alles fehlerfrei aufgrund von Ressourcenmangel oder inkompatibler Firmware startet.

Weisen Sie die GPU der VM mithilfe von VMDirectPath I/O zu.

Sobald der Host die GPU für DirectPath I/O als verfügbar markiert hat und die VM korrekt konfiguriert ist, ist es Zeit für Die Karte physisch mit dieser virtuellen Maschine verknüpfen.Dieser Schritt muss bei vollständig ausgeschalteter VM durchgeführt werden.

Wählen Sie im vSphere-Client die VM aus und geben Sie Folgendes ein: „Einstellungen bearbeiten“, um die virtuelle Hardware zu überprüfen.In der Geräteliste können Sie auf „Neues Gerät hinzufügen“ klicken und „PCI-Gerät“ auswählen, falls die GPU noch nicht aufgeführt ist. Wählen Sie anschließend das PCI-Gerät aus, das der Grafikkarte entspricht (z. B. die vom Host erkannte NVIDIA- oder AMD-Karte).

Wenn die Konfiguration gespeichert ist, zeigt die VM auf ihrer Hardware etwa Folgendes an. „PCI-Gerät 0“, das der spezifischen GPU zugeordnet istAb diesem Zeitpunkt erkennt das Gastbetriebssystem beim Start einen zusätzlichen PCIe-Adapter, der der physischen Grafikkarte entspricht.

Es ist unerlässlich, dass die virtuelle Maschine über reservierte den gesamten ihm zugewiesenen Speicher.In vSphere wird dies unter „Einstellungen bearbeiten → Virtuelle Hardware → Arbeitsspeicher“ konfiguriert. Der Wert für „Reservierung“ wird auf die für die VM konfigurierte RAM-Menge festgelegt. Ohne diese vollständige Reservierung kann PCI-Passthrough fehlschlagen oder zeitweise Probleme verursachen.

Nach dem Einschalten der VM auf einem System Linux Das Vorhandensein der GPU kann überprüft werden mit Befehle Typ lspci | grep nvidiaUnter Windows wird es unter „Grafikkarten“ angezeigt. Geräte-ManagerEs ist normal, sowohl den von VMware emulierten Grafikadapter als auch die dedizierte physische GPU zu sehen.

Der letzte Schritt besteht darin, Folgendes auf dem Gastgerät zu installieren: Treiber Offizielle Vertreter der GPU-Hersteller, heruntergeladen von den Websites von NVIDIA, AMD oder Intel, wobei die Verwendung generischer oder mitgelieferter Treiber vermieden werden sollte. Windows Updatedie möglicherweise nicht für Passthrough-Szenarien optimiert sind.

Einschränkungen und Funktionen von vSphere, die nicht mit vDGA funktionieren

Die Kehrseite der GPU-Passthrough-Funktion in VMware ist, dass Mehrere fortschrittliche Funktionen der Plattform gehen verloren. indem man einer VM ein physisches Gerät direkt zuweist. Das ist der Preis für diese nahezu native Leistung.

Das erste große Opfer ist vMotion und DRSEine virtuelle Maschine mit einer GPU im Passthrough-Modus kann nicht per Hot-Migration auf einen anderen Host verschoben werden, da die Grafikkarte physisch an den ursprünglichen Server gebunden ist. Automatisierte Load-Balancing-Richtlinien, die das Verschieben der VM zwischen Hosts im Cluster vorsehen, können ebenfalls nicht verwendet werden.

Funktionen wie Traditionelle Snapshots oder bestimmte Hochverfügbarkeitsmechanismen Für diese spezielle VM. Da sie auf sehr spezielle physische Hardware angewiesen ist, ist die Möglichkeit, komplexe Zustände einzufrieren und wiederherzustellen, eingeschränkt.

Ein weiterer zu berücksichtigender Aspekt ist, dass in diesem Modus Die GPU wird nicht von mehreren VMs gemeinsam genutzt.Wenn mehrere Desktops oder Server mit Grafikbeschleunigung auf demselben Rechner benötigt werden, ist eine Karte pro VM erforderlich. Alternativ kann ein vGPU-Modell verwendet werden, bei dem die Karte über mehrere Instanzen virtualisiert wird.

Auf der Unterstützungsseite kann es spezifische Fälle geben, in denen Bestimmte Kombinationen von Hardware und Treibern können Probleme verursachen.Wie einige Benutzer beim Upgrade auf ESXi 6.x mit NVIDIA GRID-Karten auf bestimmten Servern (z. B. Dell R720) festgestellt haben, ist es ratsam, in solchen Fällen die Dokumentation von VMware und des GPU-Herstellers zu konsultieren und gegebenenfalls Supportfälle zu eröffnen.

Abschließend sei darauf hingewiesen, dass bestimmte Technologien oder Dienste, die mit Grafiken interagieren, wie zum Beispiel Remote-Desktops, Linux-Subsysteme in Windows oder erweiterte BetriebssystemfunktionenSie können mit NVIDIA-Treibern interferieren oder „Code 43“-Fehler verursachen, wenn sie erkennen, dass Sie in einer VM mit GPU-Passthrough arbeiten.

GPU-Passthrough in anderen Hypervisoren: Parallel mit Hyper-V

Obwohl der Schwerpunkt hier auf VMware liegt, ist es dennoch wichtig zu verstehen, wie andere Hypervisoren (zum Beispiel Virtualisierung mit KVM und virt-manager) dem gleichen Bedarf gerecht werden, einer VM eine physische GPU zuzuweisen.weil sich die Terminologie und die Werkzeuge ändern, die zugrunde liegende Idee aber ähnlich bleibt.

In Hyper-V entspricht VMware VMDirectPath I/O dem folgenden System: direkte Gerätezuordnung mittels DDA (Discrete Device Assignment)Diese Technik ermöglicht die direkte Einbindung eines bestimmten PCIe-Geräts, wie z. B. einer GPU oder NVMe, in eine virtuelle Windows-Maschine, mit einem ähnlichen Maß an Kontrolle und Leistung wie beim Passthrough in ESXi.

Ältere Versionen von Windows Server nutzten diese Technologie. RemoteFX um GPU-Virtualisierung anzubieten und eine Grafikkarte von mehreren VMs gemeinsam nutzen zu lassen. die zeitAufgrund von Sicherheitsbedenken und Leistungsbeschränkungen (wie der Begrenzung auf 1 GB VRAM pro VM und 30 FPS) hat Microsoft RemoteFX eingestellt und DDA als primären Weg für dedizierte GPU-Szenarien beibehalten.

Unter Windows 10 und Windows 11Insbesondere bei bestimmten Zusammenstellungen ist Unterstützung für … aufgetaucht. GPU-Partitionierung und wiederverwendete Mechanismen aus WSL2 und Windows SandboxAllerdings erfordert die Konfiguration in der Regel komplexe Skripte und das Kopieren von Treibern vom Host zum Gast, was nicht so einfach ist wie die Zuweisung eines Geräts in vSphere.

Die Kenntnis dieser Alternativen ermöglicht es uns zu erkennen, dass Die Philosophie, einen nahezu nativen Zugriff auf die GPU über einen direkten PCIe-Kanal zu ermöglichen Es ist bei mehreren Hypervisoren üblich, obwohl jeder seine eigenen Nuancen, Befehle und Kompatibilitätsbeschränkungen hat.

Dieses gesamte Ökosystem aus Passthrough, vGPU und DDA beweist, dass bei korrekter Konfiguration und mit der richtigen Hardware Es ist durchaus machbar, leistungsstarke GPUs zu verwenden innerhalb Virtuelle Maschinen für die Produktion Bei Arbeitslasten, die von anspruchsvollen Grafik-Desktops bis hin zu KI und HPC reichen, sollten Sie stets davon ausgehen, dass Sie auf gewisse Annehmlichkeiten der traditionellen Virtualisierung verzichten müssen und besonderes Augenmerk auf Treiber, Hypervisor-Versionen und die Unterstützung durch den GPU-Hersteller legen.

Leidenschaftlicher Autor über die Welt der Bytes und der Technologie im Allgemeinen. Ich liebe es, mein Wissen durch Schreiben zu teilen, und genau das werde ich in diesem Blog tun und Ihnen die interessantesten Dinge über Gadgets, Software, Hardware, technologische Trends und mehr zeigen. Mein Ziel ist es, Ihnen dabei zu helfen, sich auf einfache und unterhaltsame Weise in der digitalen Welt zurechtzufinden.